gulimall技术栈笔记

项目地址:

1.项目背景

1.1电商模式

市面上有5种常见的电商模式B2B、B2C、C2B、C2C、O2O

- B2B模式

B2B(Business to Business),是指商家与商家建立的商业关系。如:阿里巴巴。

- B2C模式

B2C(Business to Consumer),就是我们经常看到的供应商直接把商品卖给用户,即“商家对客户”模式,也 就是通常说的商业零售,直接面向消费者销售产品和服务。如:苏宁易购、京东、天猫。

- C2B模式

C2B模式(Consumer to Business),即消费者对企业。先有消费者需求产生而后有企业生产,即先有消费 者提出需求,后有生产企业按需求组织生产。

- C2C模式

C2C(Customer to Consumer),客户之间自己把东西放网上去卖,如:淘宝,咸鱼。

- O2O模式

O2O(Online to Offine),将线下商务的机会与互联网结合在一起,让互联网成为线下交易的前台。线上快 速支付,线下优质服务。如:饿了么,美团。

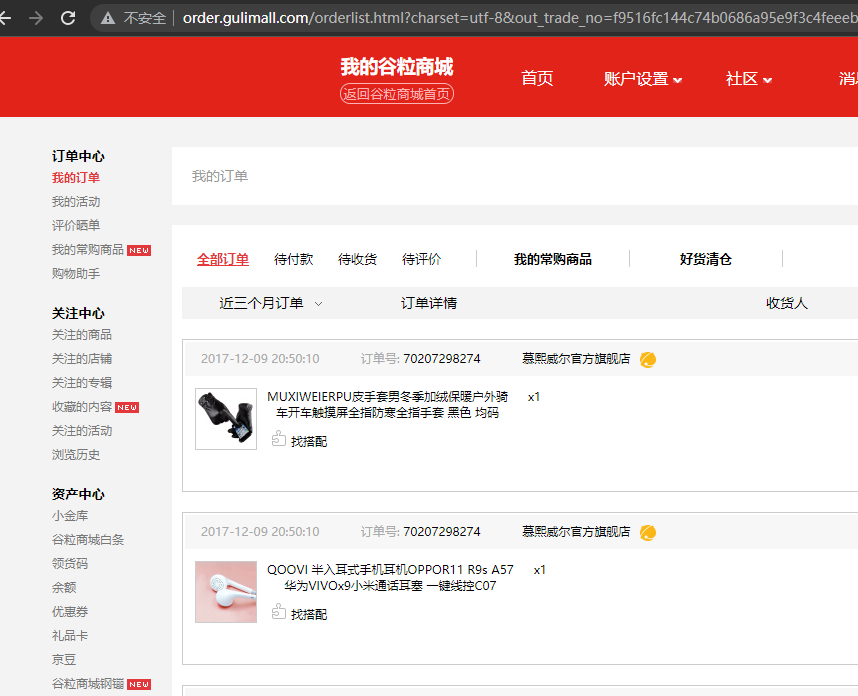

1.2谷粒商城

谷粒商城是一个B2C模式的电商平台,类似于淘宝、京东,销售自营商品给客户。

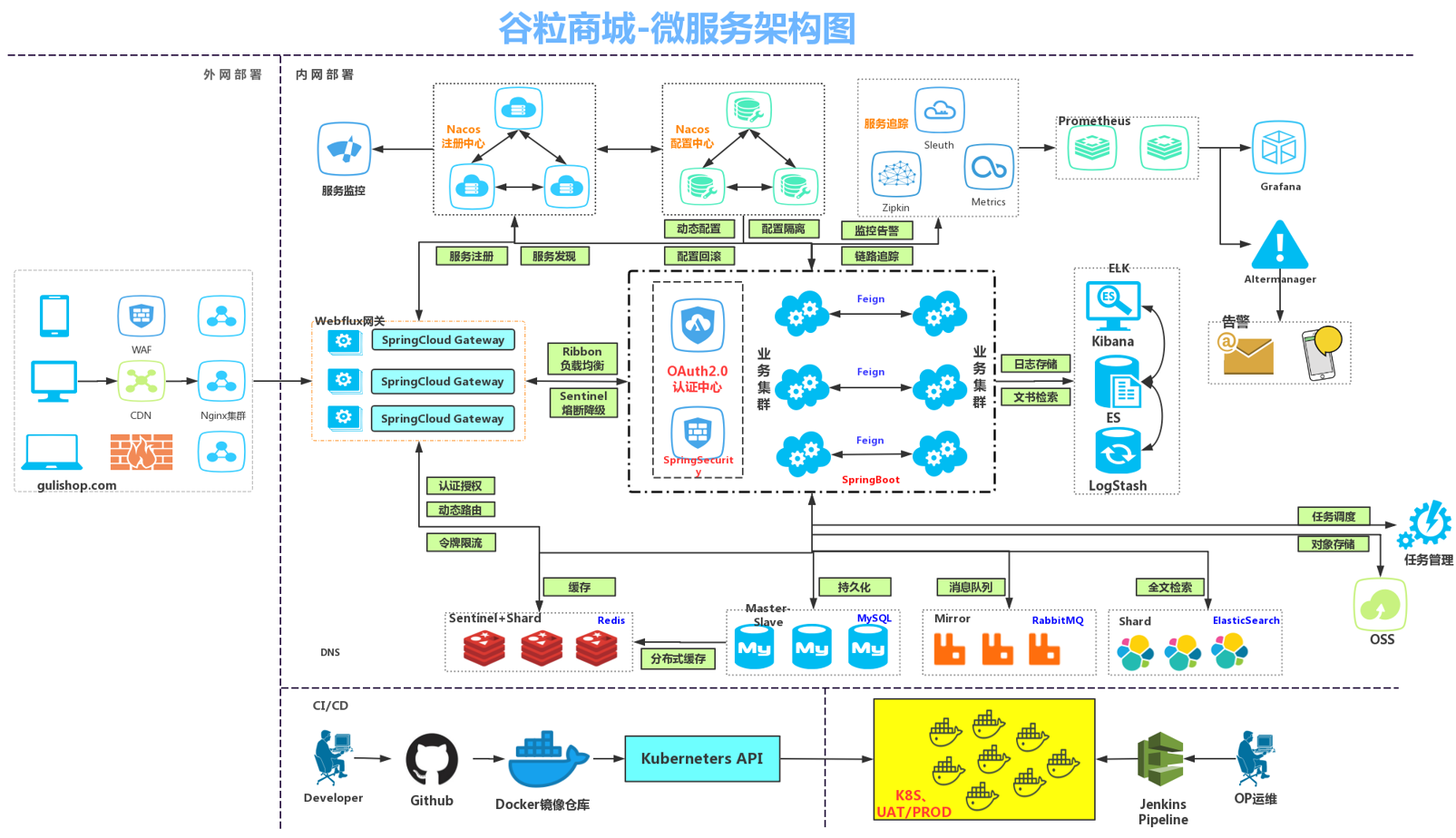

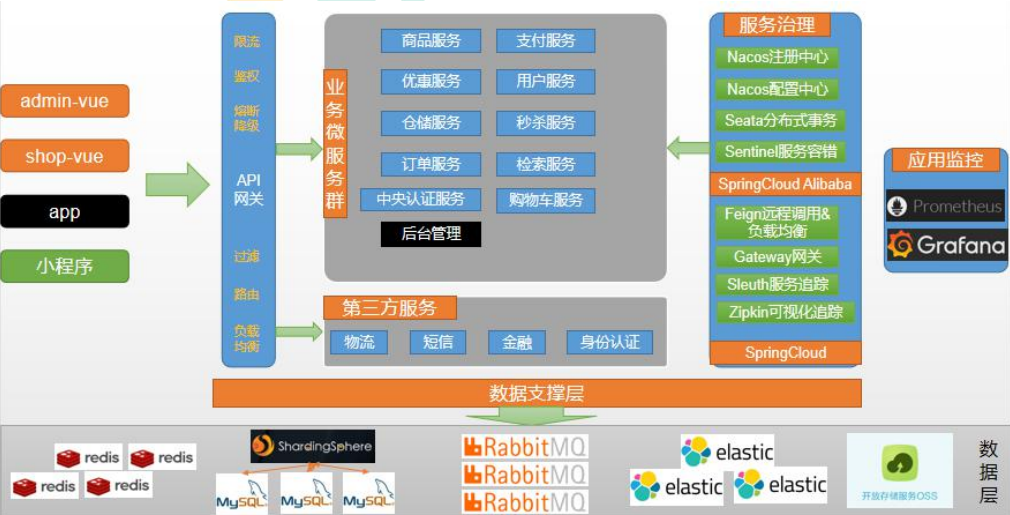

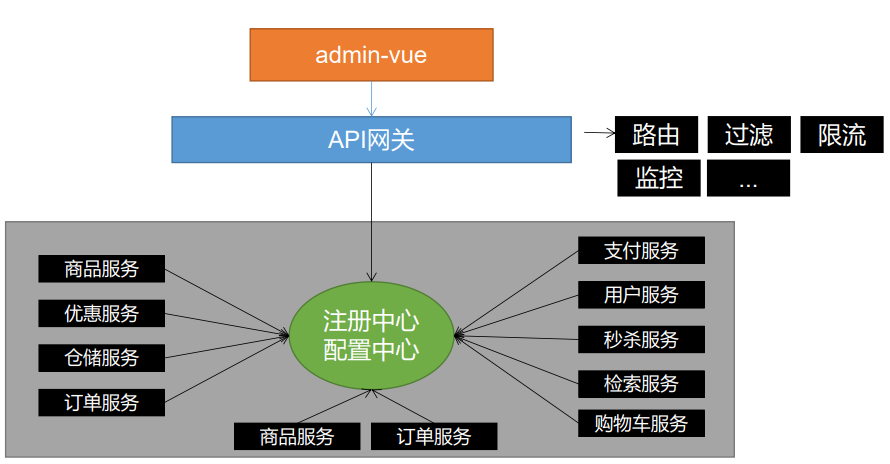

2.项目架构图

微服务架构图

微服务划分图

3.项目技术&特色

- 前后端分离开发,并开发基于vue的后台管理系统

- SpringCloud全新的解决方案

- 全方位涉及应用监控、限流、网关、熔断降级等分布式方案

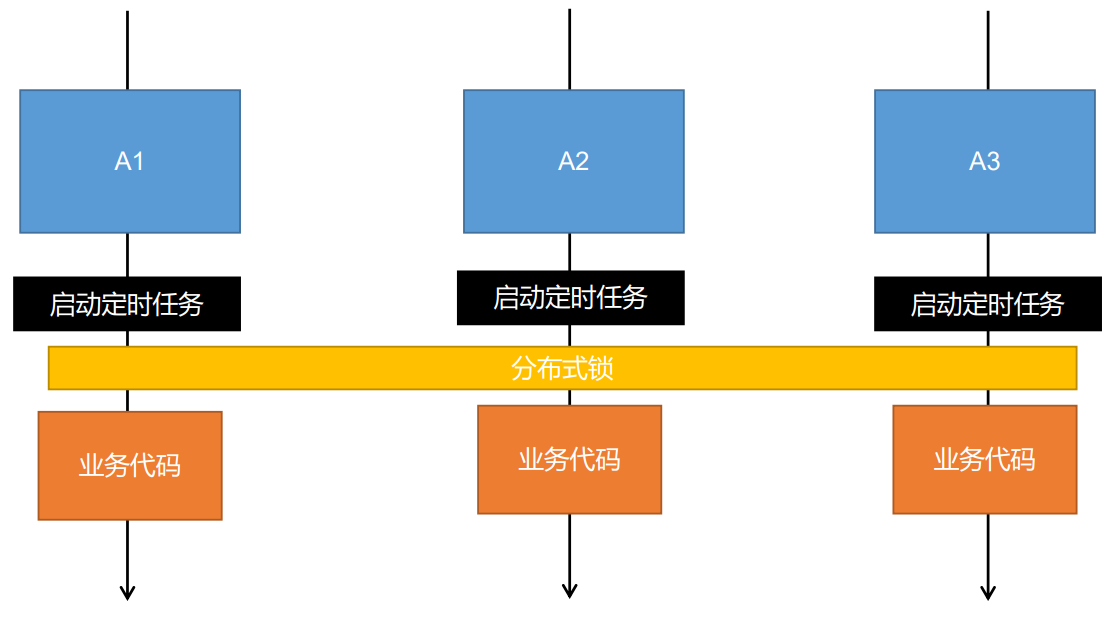

- 透彻讲解分布式事务、分布式锁等分布式系统的难点

- 分析高并发场景的编码方式,线程池,异步编排等使用

- 压力测试与性能优化

- 各种集群技术的区别即使用

- CI/CD使用

- …

4.项目前置要求

学习项目前的前置知识:建议使用win10系统进行开发

- 熟悉SpringBoot以及常见整合方案

- 了解SpringCloud

- 熟悉git、maven

- 熟悉linux,redis,docker基本操作

- 了解html,css,js,vue

- 熟练使用idea开发项目

5.分布式基础概念

5.1微服务

微服务架构风格就像是把一个单独的应用程序开发为一套小服务,每个小服务运行在自己的进程中,并使用轻量级机制通信,通常是HTTP API。这些服务围绕业务能力来构建,并通过完全自动化部署机制来独立部署。这些服务使用不同的编程语言书写,以及不同数据存储技术,并保持最低限度的集中式管理。

简而言之:==拒绝大型单体应用,基于业务边界进行服务微化拆分,各个服务独立部署运行==

5.2集群&分布式&节点

集群是个物理形态,分布式是个工作方式。

只要是一堆机器,就可以叫集群

《分布式系统原理与范型》定义

“分布式系统是若干个独立计算机的集合,这些计算机对于用户来说就像单个相关系统”

分布式系统是建立在网络之上的软件系统

分布式系统是指将不同的业务分布在不同的地方

集群指的是将几台服务器集中在一起,实现同一业务

节点:集群中的一个服务器

例如:京东是一个分布式系统,众多业务运行在不同的机器,所有业务构成一个大型的业务集群。每一个小的业务,比如用户系统,访问压力大的时候一台服务器是不够的。我们就应该将用户系统部署到多个服务器,也就是每一个业务系统也可以做集群化。

==分布式中的每一个节点,都可以做集群。而集群并不一定就是分布式的。==

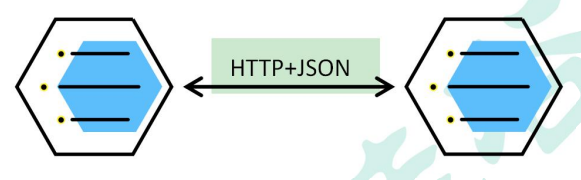

5.3远程调用

在分布式系统中,各个服务可以处于不同主机,但是服务之间不可避免的需要相互调用,我们称之为远程调用。

SpringCloud中使用HTTP+JSON的方式完成远程调用

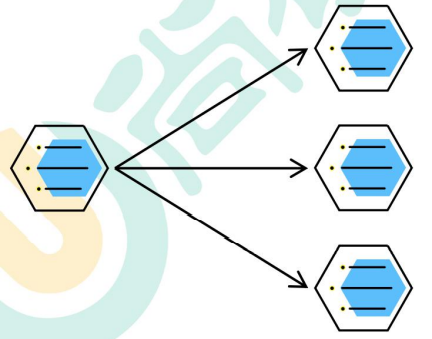

5.4负载均衡

- 分布式系统中,A服务需要调用B服务,B服务在多台服务器中都存在,A调用任意一个服务器均可完成此功能。为了使每一个服务器都不要太忙或者太闲,我们可以负载均衡的调用每一个服务器,提升网站的健壮性

常见的负载均衡算法:

轮询: 为第一个请求选择健康池中的第一个后端服务器,然后按顺序往后依次选择,直到最后一个,然后循环

最小链接: 优先选择连接数最少,也就是压力最小的后端服务器,在会话较长的情况下可以考虑采取这种方式

散列: 根据请求源的ip散列(hash)来选择要转发的服务器。这种方式可以一定程度上保证特定用户能连接到相同的服务器。如果你的应用需要处理状态而要求用户能连接到和之前相同的服务器,可以考虑采取这种方式

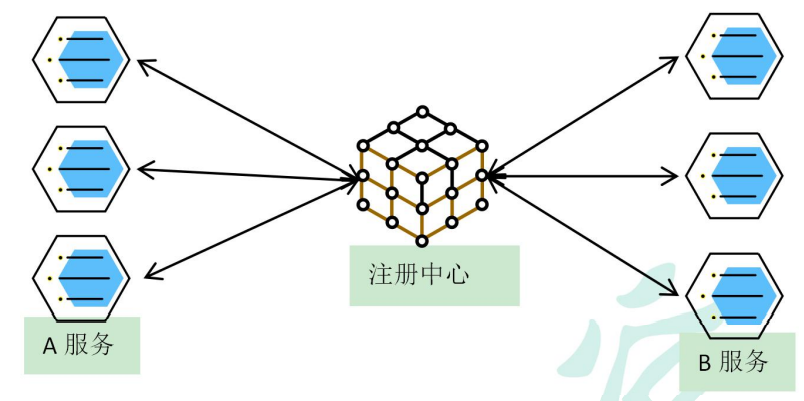

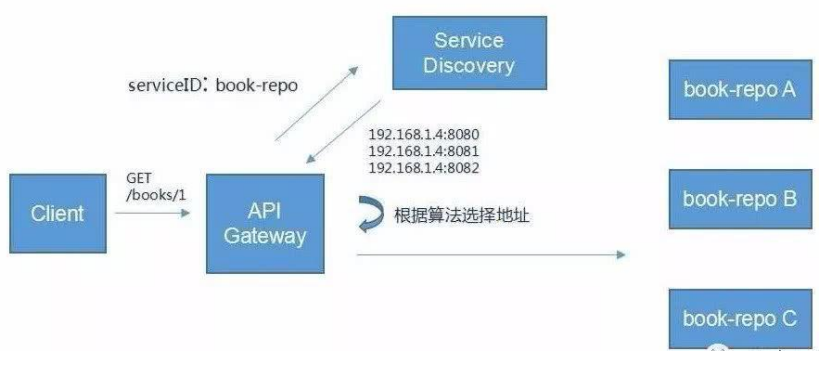

5.5服务注册/发现&注册中心

A服务调用B服务,A服务并不知道B服务当前在哪几台服务器有,那些正常的,哪些服务以及下线。解决这个问题可以引入注册中心。如果某些服务下线,我们其他人可以实时感知到其他服务的状态,从而避免调用不可用的服务

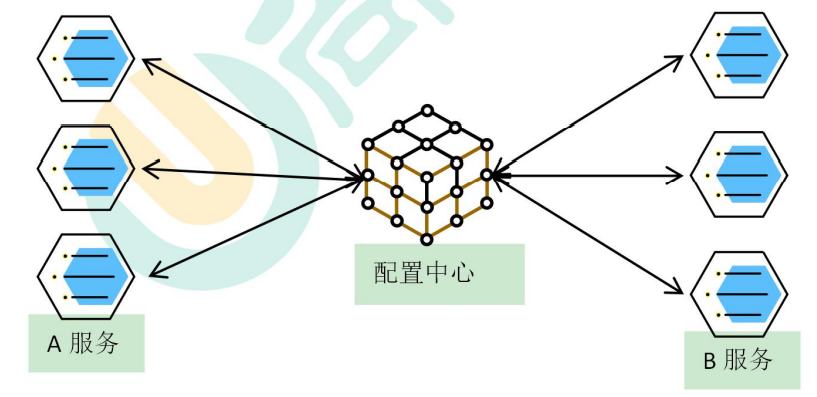

5.6配置中心

每一个服务最终都有大量的配置,并且每个服务器都可能部署在多台机器上。我们经常需要变更配置,我们可以让每个服务在配置中心获取自己的配置。

配置中心用来集中管理微服务的配置信息

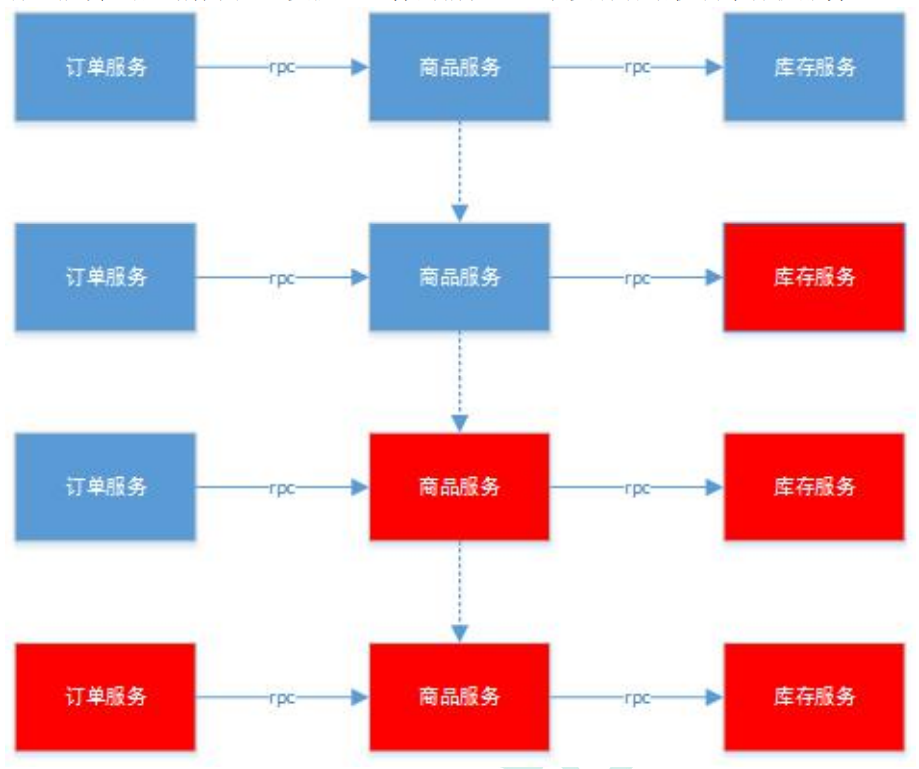

5.7服务熔断&服务降级

在微服务架构中,微服务之间通过网络进行通信,存在相互依赖,当其中一个服务不可用时,有可能会造成雪崩效应。要防止这样的情况,必须要有容错机制来保护服务

5.7.1服务熔断

设置服务的超时,当被调用的服务经常失败到达某个阈值,我们可以开启断路保护机制,后来的请求不再去调用这个服务。本地直接返回默认的数据

5.7.2服务降级

在运维期间,当系统处于高峰期,系统资源紧张,我们可以让非核心业务降级运行。

降级:某些服务不处理,或者简单处理【抛异常、返回null、调用Mock数据、调用Fallback处理逻辑】

5.8API网关

在微服务架构中,API Gateway作为整体架构的重要组件,它抽象了微服务中都需要的公共功能,同时提供了客户端负载均衡,服务自动熔断,灰度发布,统一认证,限流监控,日志统计等丰富的功能,帮助我们解决很多API管理难题。

6.虚拟机环境搭建

6.1创建虚拟机,安装docker

开始安装:

- 搭建gcc环境(gcc是编程语言译器)

yum -y install gcc

yum -y install gcc-c++- 安装需要的软件包

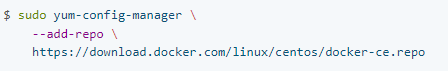

yum install -y yum-utils- 安装镜像仓库

官网上的是

但是因为docker的服务器是在国外,所以有时候从仓库中下载镜像的时候会连接被拒绝或者连接超时的情况,所以可以使用阿里云镜像仓库

yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo- 更新yum软件包索引

yum makecache fast- 安装docker引擎

yum install docker-ce docker-ce-cli containerd.io docker-compose-plugin- 启动docker,并设置docker开机自启

systemctl start docker

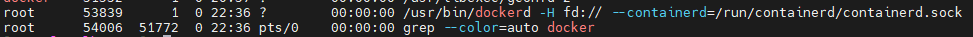

systemctl enable docker- 查看docker服务

- 查看docker版本信息

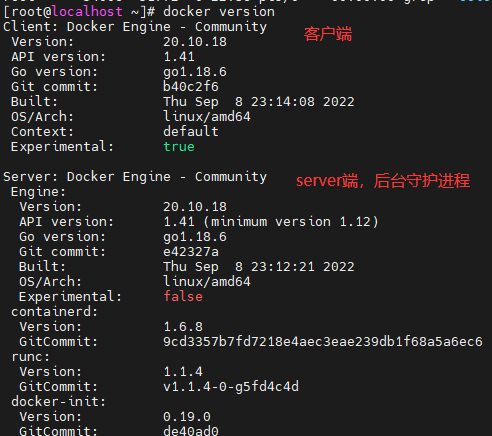

docker version

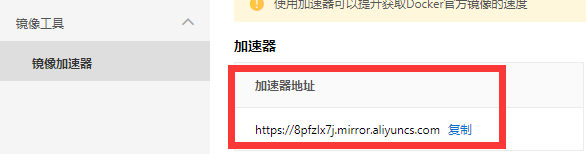

- 阿里云镜像加速配置

为了提高镜像的拉取、发布的速度,可以配置阿里云镜像加速

查看加速器地址

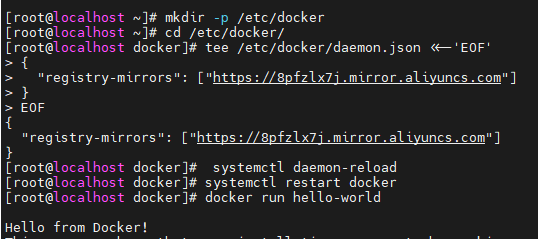

在CentOS下配置镜像加速器

mkdir -p /etc/docker

cd /etc/docker

tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["https://8pfzlx7j.mirror.aliyuncs.com"]

}

EOF

systemctl daemon-reload

systemctl restart docker

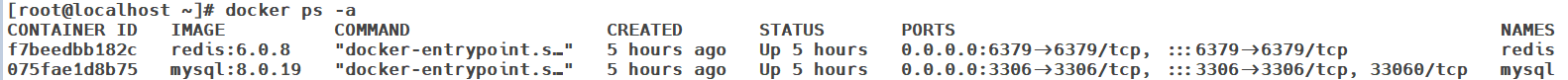

6.2docker安装mysql

- 拉取镜像

docker pull mysql:8.0.19- 创建容器实例

docker run -d -p 3306:3306 --privileged=true \

--restart=always \

-v /opt/mysql/log:/var/log/mysql \

-v /opt/mysql/data:/var/lib/mysql \

-v /opt/mysql/conf:/etc/mysql/conf.d \

-e MYSQL_ROOT_PASSWORD=root \

--name mysql \

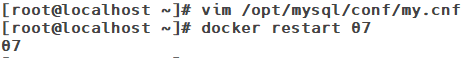

mysql:8.0.19- 在主机的配置文件目录下新建mysql的配置文件my.cnf

设置mysql字符编码为utf-8

[client]

default_character_set=utf8

[mysqld]

collation_server = utf8_general_ci

character_set_server = utf8- 重启mysql容器实例

docker restart 容器ID6.3docker安装redis

- 拉取redis镜像

docker pull redis:6.0.8获取redis的配置文件

is配置文件官网Redis configuration | Redis

创建存放redis配置文件的目录,创建redis.conf文件,写入配置信息

mkdir -p /opt/redis

vim redis.conf修改配置文件内容

- ==添加redis密码(requirepass)==

- ==修改bind为0.0.0.0(任何机器都能够访问)==

- ==为了避免和docker中的-d参数冲突,将后台启动设置为no(daemonize no)==

- ==关闭保护模式(protected-mode no)==

- ==开启AOF的持久化(appendonly yes)==

使用redis镜像创建容器实例

docker run -d -p 6379:6379 \ --restart=always \ --name redis --privileged=true \ -v /opt/redis/redis.conf:/etc/redis/redis.conf \ -v /opt/redis/data:/data \ redis:6.0.8

7.项目初始化

7.1初始化项目并推送到gitee

使用

spring初始化向导创建父工程将项目推送到

gitee创建新分支

develop

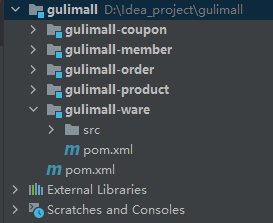

- 新建子模块,项目结构如下

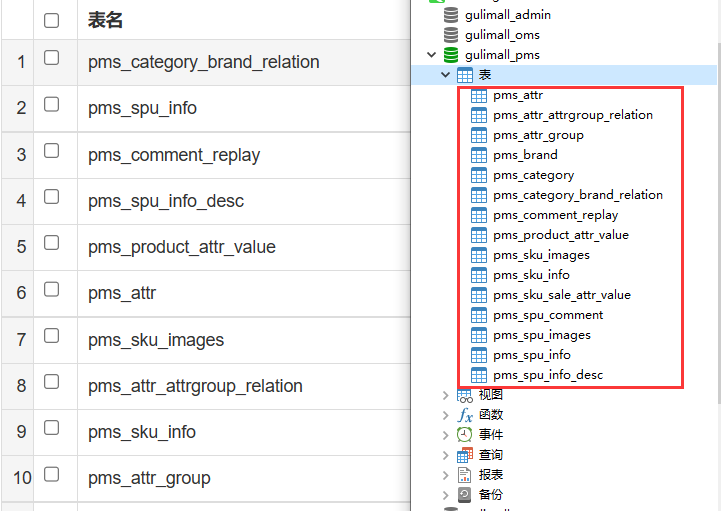

7.2创建数据库,创建表

- 创建数据库,导入对应得sql文件

8.人人开源项目环境部署

- gitee搜索人人开源,将下面两个项目clone到本地

删除两个文件当中的.git文件

renren-fast放到gulimall项目当中作为一个子模块,并创建数据库,导入sql文件

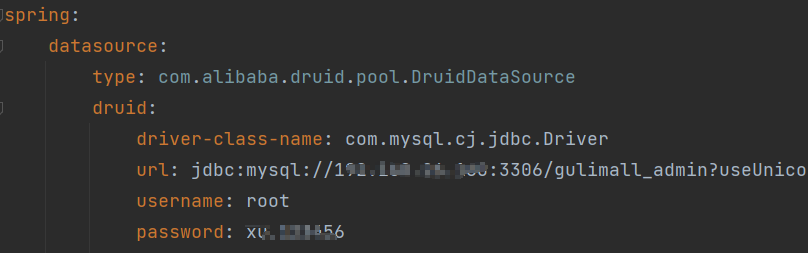

- 修改配置文件,修改数据库配置信息

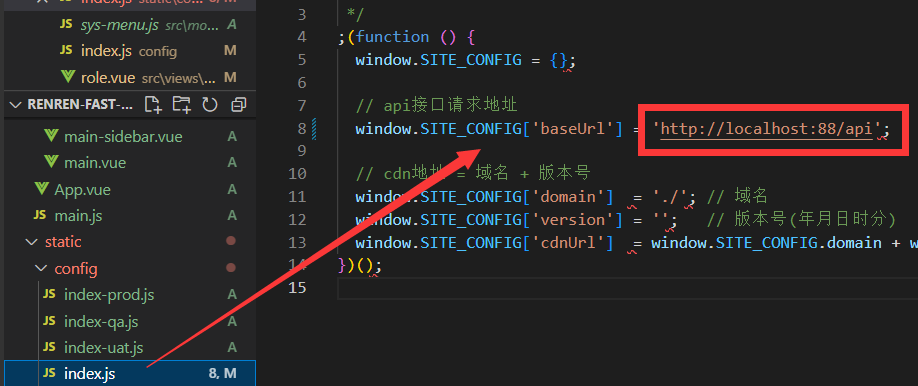

renren-fast-vue放到VS Code当中,并设置node.js环境

官网下载安装node.js, 并使用node -V检查版本

配置npm使用淘宝镜像

# 安装淘宝镜像

npm install -g cnpm --registry=https://registry.npm.taobao.org

cnpm install

# 启动服务

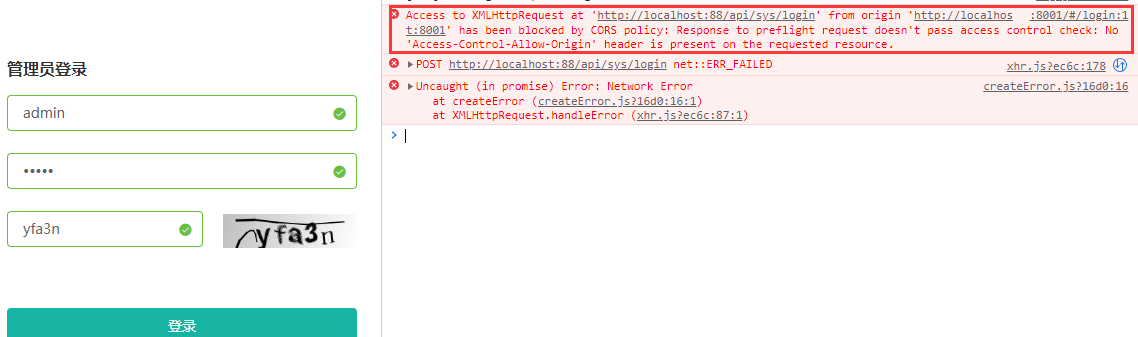

npm run dev出现的问题:

- npm run dev后出现node-sass报错最简单解决方法:

npm install node-sass@npm:sass --ignore-scripts- cnpm : 无法加载文件 C:\Users\xxx\AppData\Roaming\npm\cnpm.ps1,因为在此系统上禁止运行脚本

原因是因为:作用域都没有权限,需要赋给权限。

win+R,打开运行,输入powershell

Set-ExecutionPolicy RemoteSigned -Scope CurrentUser, 再输入A

Get-ExecutionPolicy -List,查看权限正常

再次执行npm命令正常- 关闭高版本的node安全校验

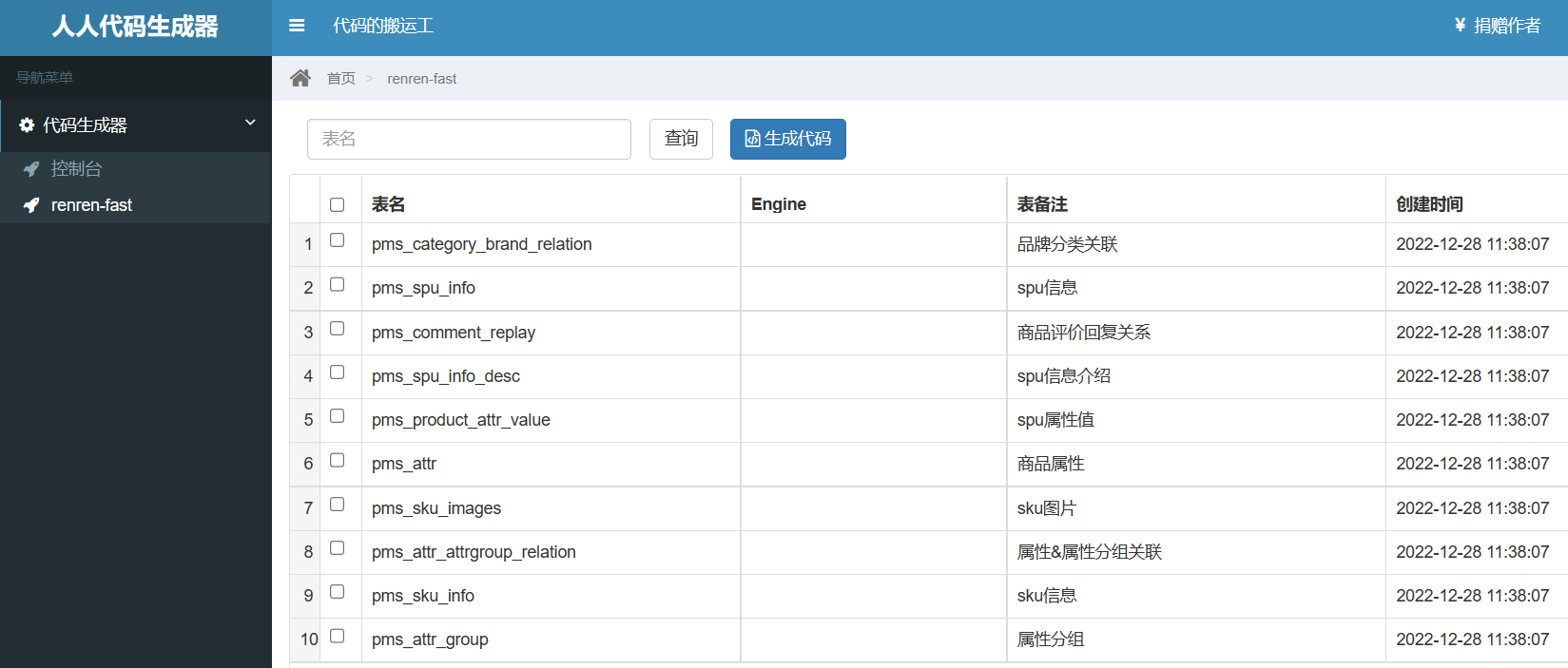

set NODE_OPTIONS=--openssl-legacy-provider9.人人开源代码生成器部署

克隆项目到本地,并将其作为

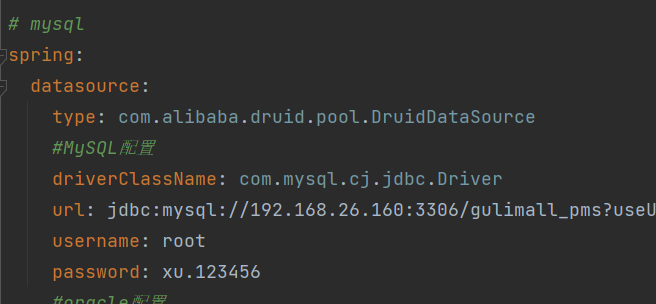

gulimall的子模块修改yaml配置文件,修改数据库配置信息

- 修改

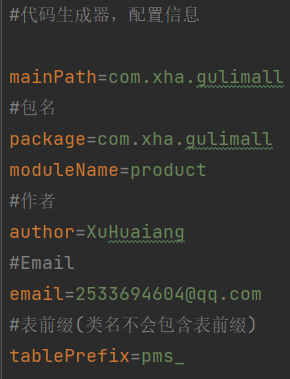

generator.propertise文件,设置包名等等

设置包名、模块名、表前缀等等

- 启动项目,访问80端口

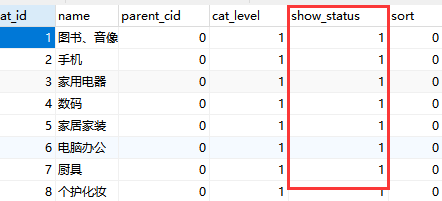

对应的数据库表名:

全选,生成对应业务文件,粘贴到项目中即可

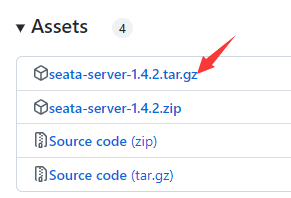

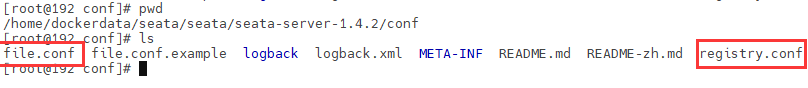

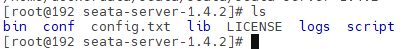

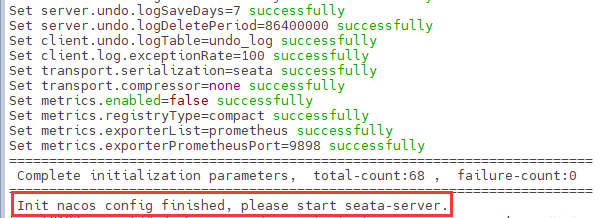

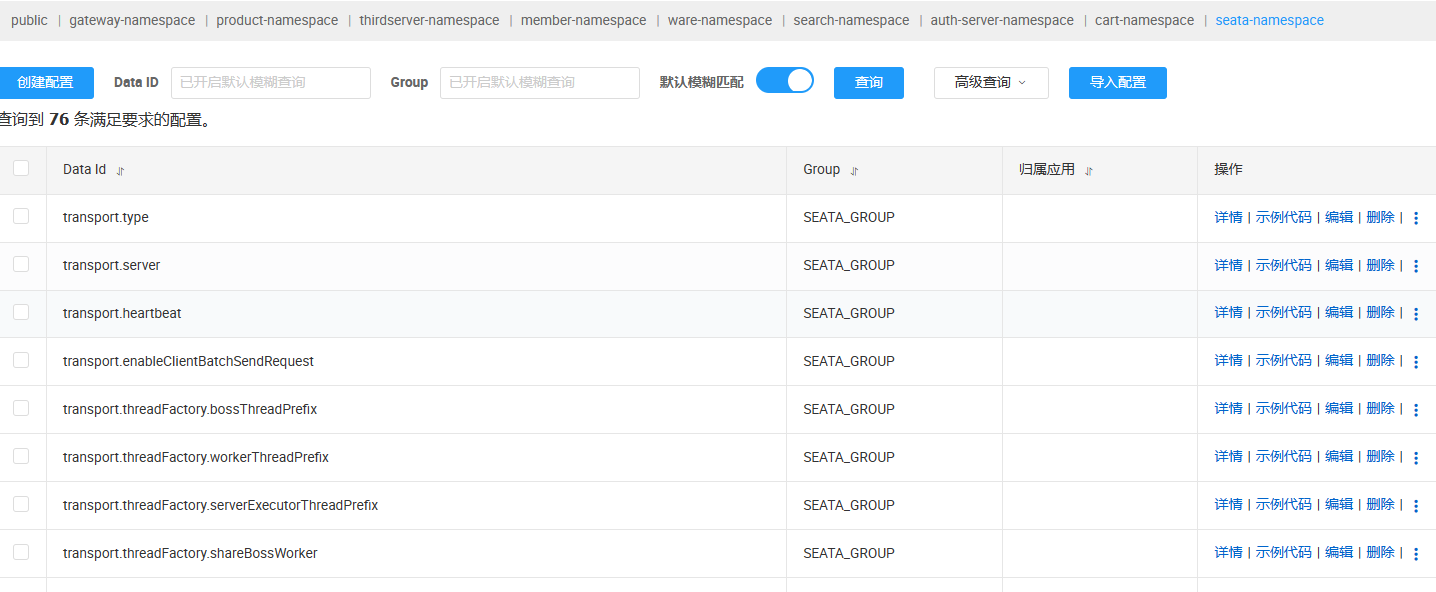

10.微服务-注册中心、配置中心、网关、服务调用、分布式事务seata、服务降级熔断

10.1网关、注册中心和配置中心架构图

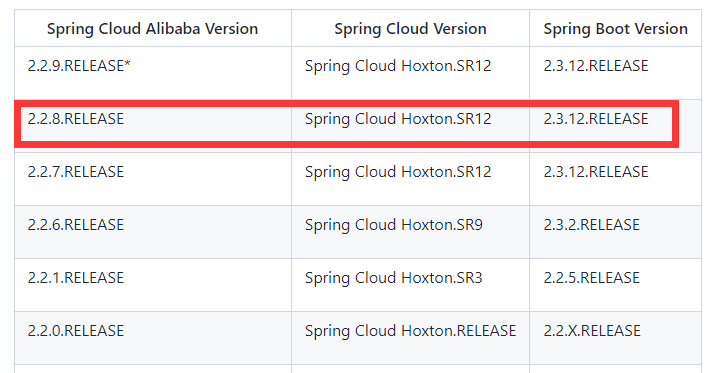

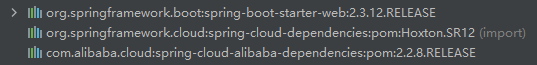

10.2SpringCloud、SpringCloudAlibaba、SpringBoot版本说明

详细的SpringCloud Alibabagithub官网版本说明https://github.com/alibaba/spring-cloud-alibaba/wiki/%E7%89%88%E6%9C%AC%E8%AF%B4%E6%98%8E

使用SpringCloud Alibabagithub官网的版本说明:

| 版本 | |

|---|---|

SpringBoot |

2.3.12.RELEASE |

SpringCloud |

Hoxton.SR12 |

SpringCloud Alibaba |

2.2.8.RELEASE |

10.3SpringCloud Alibaba和Nacos版本说明

详细的SpringCloud Alibabagithub官网版本说明https://github.com/alibaba/spring-cloud-alibaba/wiki/%E7%89%88%E6%9C%AC%E8%AF%B4%E6%98%8E

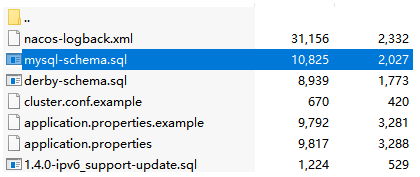

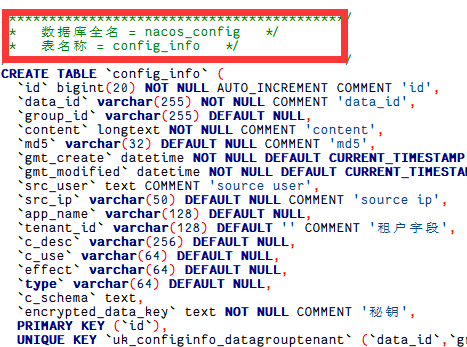

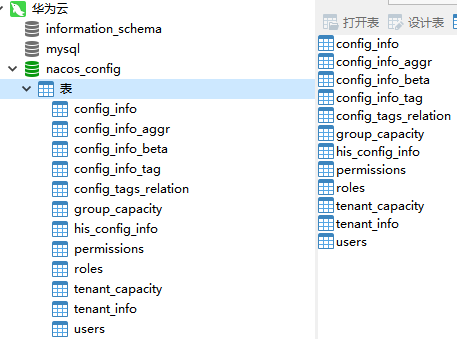

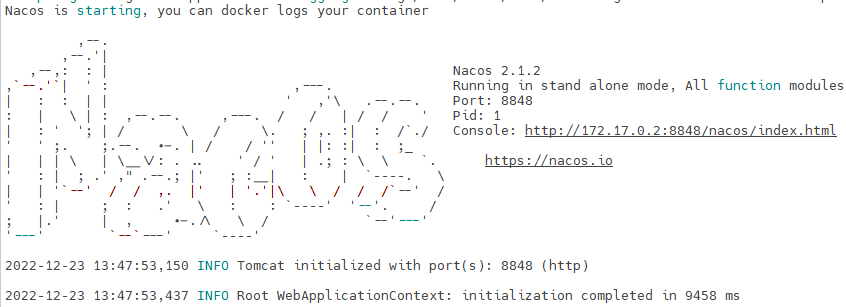

10.4Nacoc安装

- 拉取nacos镜像和MySQL镜像

docker pull nacos/nacos-server:v2.1.2

docker pull mysql:8.0.19- 在官网找到对应版本的sql文件

- 新建数据库

nacos_config

- 启动nacos容器实例

docker run -d -p 8848:8848 \

--restart=always \

-e MODE=standalone \

-e SPRING_DATASOURCE_PLATFORM=mysql \

-e MYSQL_SERVICE_HOST=192.168.26.160 \

-e MYSQL_SERVICE_PORT=3306 \

-e MYSQL_SERVICE_DB_NAME=nacos_config \

-e MYSQL_SERVICE_USER=root \

-e MYSQL_SERVICE_PASSWORD=xu.123456 \

--name nacos nacos/nacos-server:v2.1.2 查看容器的日志信息:

- 开放8848端口,重启防火墙

firewall-cmd --zone=public --add-port=8848/tcp --permanent

systemctl restart firewalld.service如果是云服务器记得开放对应的安全组规则

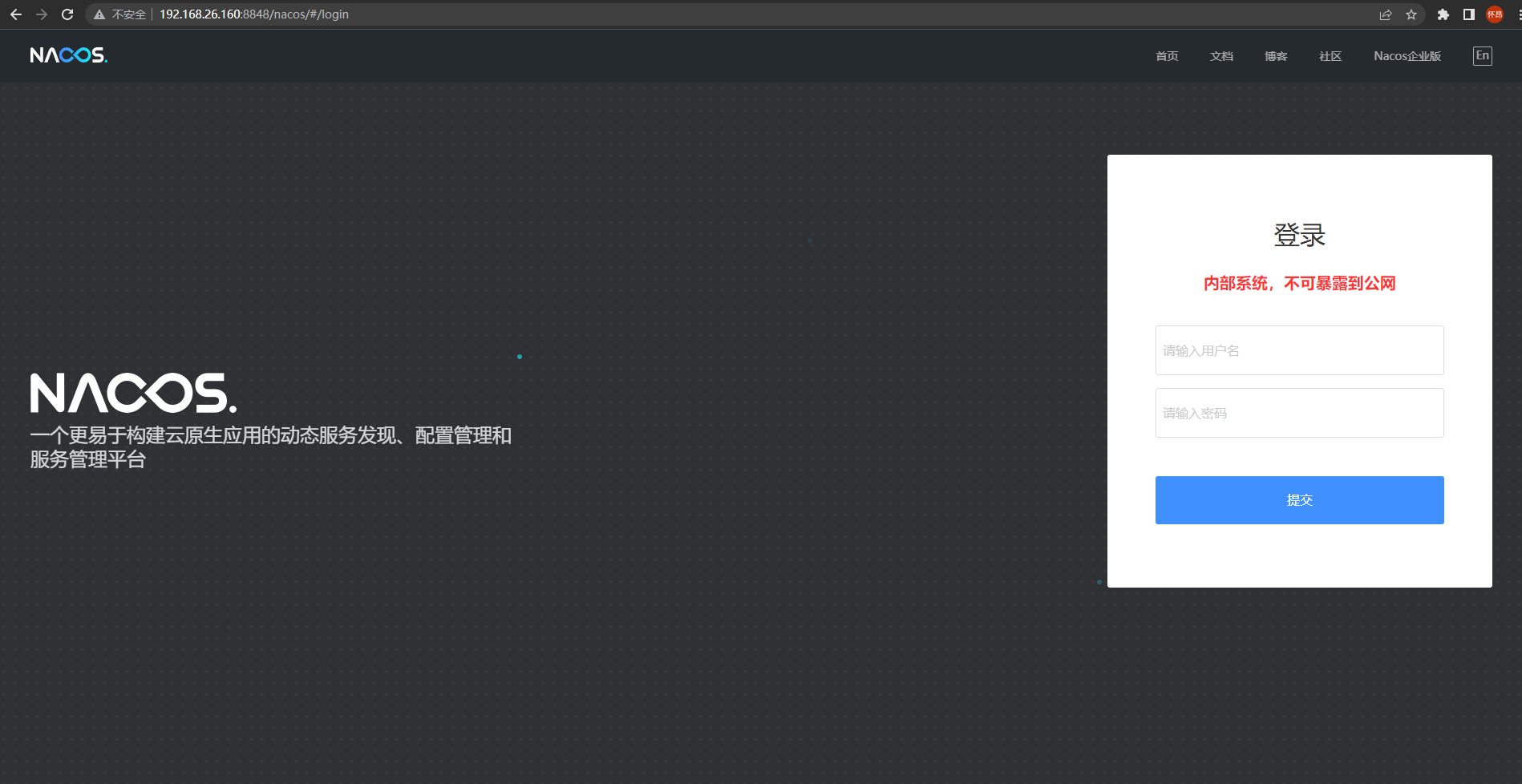

- 访问Nacos的UI界面

ip:8848/nacos

10.5Nacos注册中心

10.5.1将服务模块注册进Nacos

- 目前的配置文件内容

server:

port: 7000

# mysql配置

spring:

application:

name: gulimall-coupon

# nacos配置

cloud:

nacos:

discovery:

server-addr: 192.168.26.160:8848

datasource:

driver-class-name: com.mysql.cj.jdbc.Driver

url: jdbc:mysql://192.168.26.160:3306/gulimall_sms?useUnicode=true&characterEncoding=UTF-8&useSSL=false&serverTimezone=Asia/Shanghai

username: root

password: xu.123456

# mybatis-plus配置

mybatis-plus:

# mapper.xml文件位置

mapper-locations: classpath:/mapper/**/*.xml

# id自增

global-config:

db-config:

id-type: auto

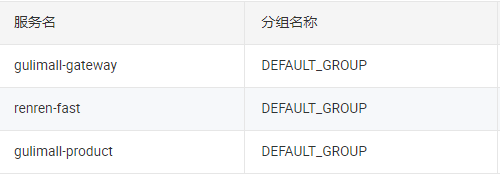

- 启动服务模块,将其注册进nacos

10.6OpenFeign服务调用

10.6.1OpenFeign配置

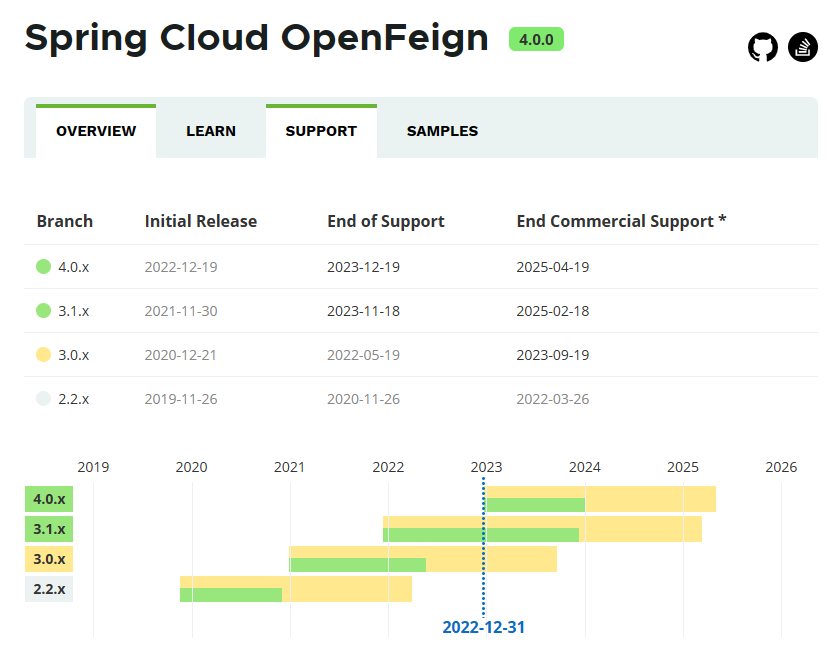

- openfeign版本支持时间

- 添加openfeign依赖

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-openfeign</artifactId>

<version>3.1.4</version>

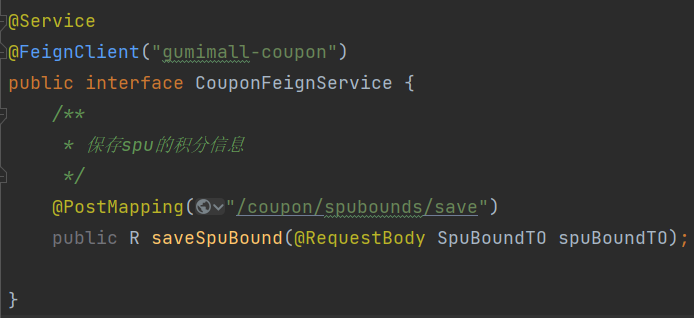

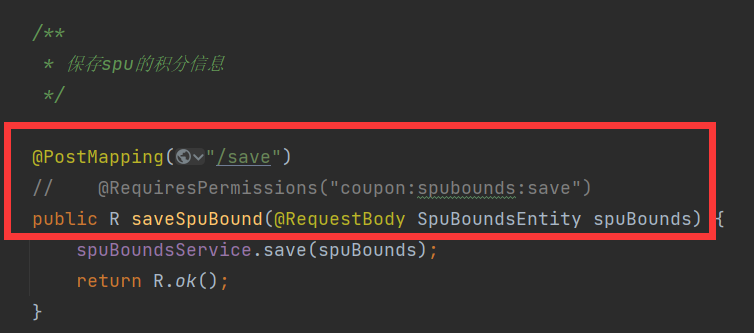

</dependency>- 在要调用其他服务的模块处添加对应的service接口调用服务

在启动类上添加@EnableFeignClients注解

使用@FeignClient注解标明要调用哪个模块

对应的被调用的服务模块接口

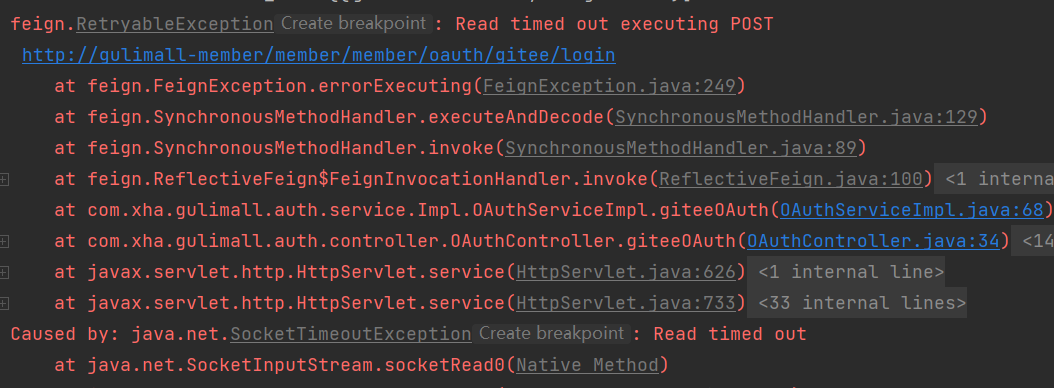

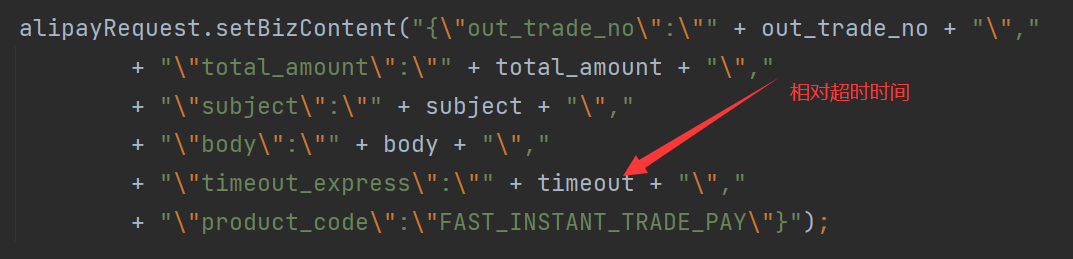

10.6.2OpenFeign超时控制

高版本的OpenFeign依赖的默认等待时间为60秒钟

如果有一个业务的逻辑流程过于复杂超过了60秒钟,客户端就会报错。

为了避免Openfeign的超时控制机制,就需要设置Fegin客户端的超时控制。

在配置文件当中进行配置:

feign:

client:

config:

default:

# 指的是建立连接所用的时间,适用于网络状态正常的情况下,两端连接所用的时间

ConnectTimeOut: 100000

# 指的是建立连接后从服务器读取可用资源所用的时间

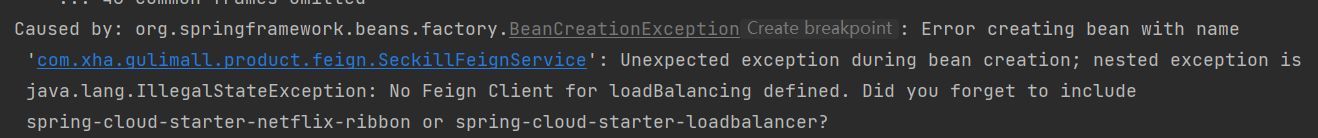

ReadTimeOut: 10000010.6.3Nacos排除netflix-ribbon使用loadbalancer

使用netflix-ribbon出现以下错误

排除netflix-ribbon使用loadbalancer

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

<exclusions>

<exclusion>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-ribbon</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-loadbalancer</artifactId>

</dependency>配置文件中关闭ribbon

spring:

cloud:

loadbalancer:

ribbon:

enabled: false10.7Nacos配置中心

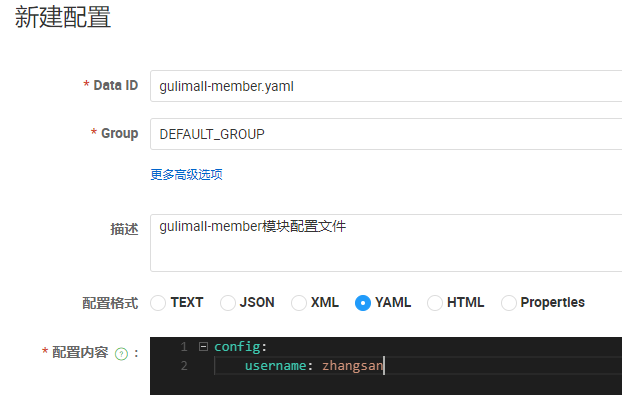

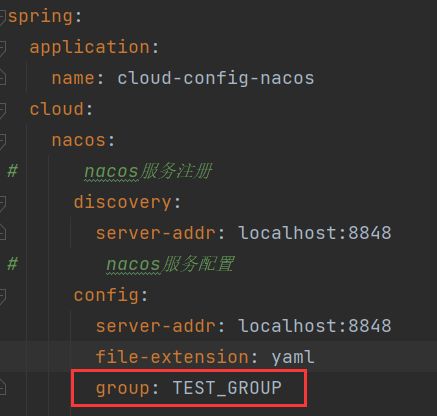

10.7.1Nacos配置中心基础配置

- 添加nacos-config依赖(和nacos-discovery的版本相同)

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-config</artifactId>

<version>2.1.0.RELEASE</version>

</dependency>- 添加

bootstrap.yaml文件,让其优先于application.yaml加载

bootstrap.yaml文件中主要是模块名和配置中心地址以及配置文件类型

spring:

application:

name: gulimall-member

# nacos配置中心地址

cloud:

nacos:

config:

server-addr: 192.168.26.160:8848

file-extension: yaml- 配置文件的命名方式

==Nacos中的配置管理dataid的组成格式及与SpringBoot配置文件中的匹配规则一致==

${prefix}-${spring.profiles.active}.${file-extension}prefix默认为spring.application.name的值,也可以通过配置项spring.cloud.nacos.config.prefix来配置。spring.profiles.active即为当前环境对应的 profile,详情可以参考 Spring Boot文档。 注意:当spring.profiles.active为空时,对应的连接符-也将不存在,dataId 的拼接格式变成${prefix}.${file-extension}file-exetension为配置内容的数据格式,可以通过配置项spring.cloud.nacos.config.file-extension来配置。目前只支持properties和yaml类型。

这里再application.yaml文件中并没有执行环境,所以文件名就是**模块名.yaml**

- 添加配置文件

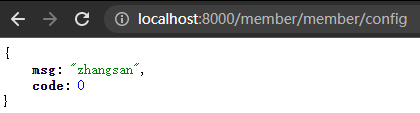

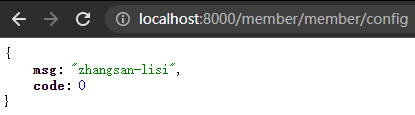

- 读取配置文件内容,并添加

@RefreshScope注解实现配置的刷新

更改配置文件的内容,直接刷新查看

10.7.2分类配置说明

10.7.2.1问题引入

问题1:

实际开发中,通常一个系统会准备

dev开发环境

test测试环境

prod生产环境。

如何保证指定环境启动时服务能正确读取到Nacos上相应环境的配置文件呢?

问题2:

一个大型分布式微服务系统会有很多微服务子项目,

每个微服务项目又都会有相应的开发环境、测试环境、预发环境、正式环境……

那怎么对这些微服务配置进行管理呢?

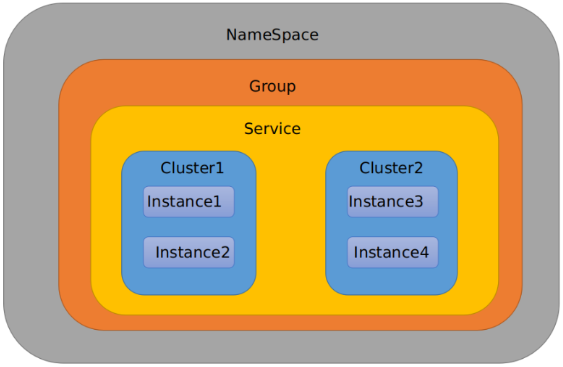

10.7.2.2Nacos中命名空间、Group和DataId

命名空间->组->服务->集群->实例,范围从大到小。

类似Java里面的package名和类名

最外层的namespace是可以用于区分部署环境的,Group和DataID逻辑上区分两个目标对象。

默认情况:

Namespace=public,Group=DEFAULT_GROUP, 默认Cluster是DEFAULT

- xxxxxxxxxx7 1public static void main(String[] args) {2 List

authors = getAuthors();3 authors.parallelStream()4 .map(author -> author.getAge())5 .mapToInt(age -> age + 10)6 .forEach(name -> System.out.println(name));7}java

比方说我们现在有三个环境:开发、测试、生产环境,我们就可以创建三个Namespace,不同的Namespace之间是隔离的。

- ==Group可以把不同的微服务划分到同一个分组里面去==

- ==Service就是微服务==

一个Service可以包含多个Cluster(集群),Nacos默认Cluster是DEFAULT,Cluster是对指定微服务的一个虚拟划分。

比方说为了容灾,将Service微服务分别部署在了杭州机房和广州机房,

这时就可以给杭州机房的Service微服务起一个集群名称(HZ),给广州机房的Service微服务起一个集群名称(GZ),还可以尽量让同一个机房的微服务互相调用,以提升性能。

- ==Instance,就是微服务的实例==。

10.7.2.3三种方案加载配置

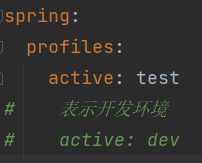

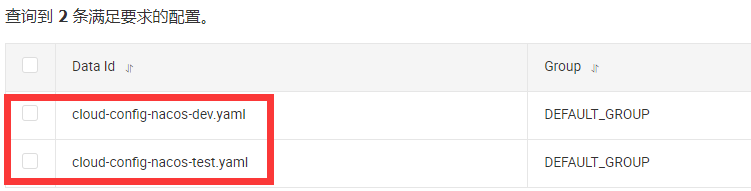

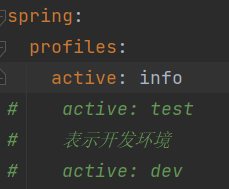

- DataID(相当于配置文件名)方案

通过spring.profile.active属性就能进行多环境下配置文件的读取

新建nacos配置:

重启模块,访问配置文件信息

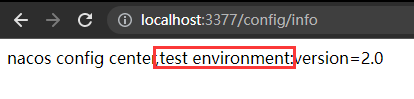

- Group方案

通过Group实现环境区分

新建两个分组,但是是两个相同的文件名

在配置文件中指定分组和当前环境:

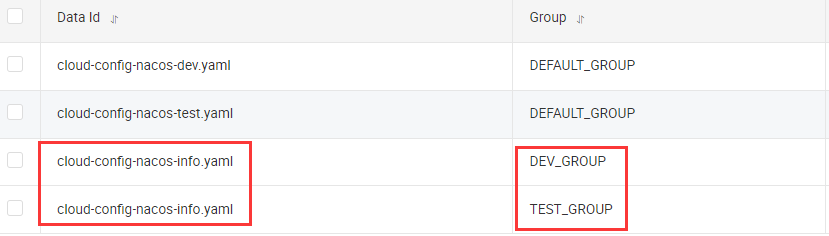

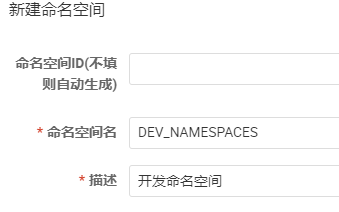

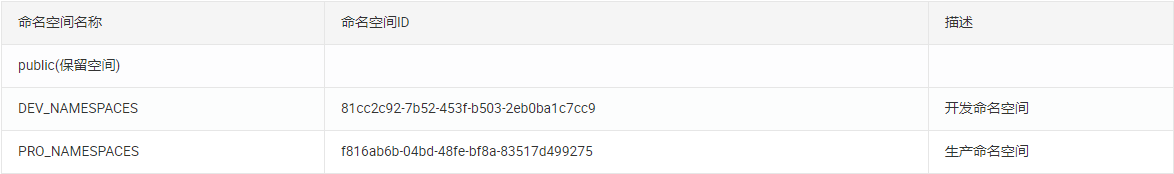

- Namespace方案

新建命名空间:

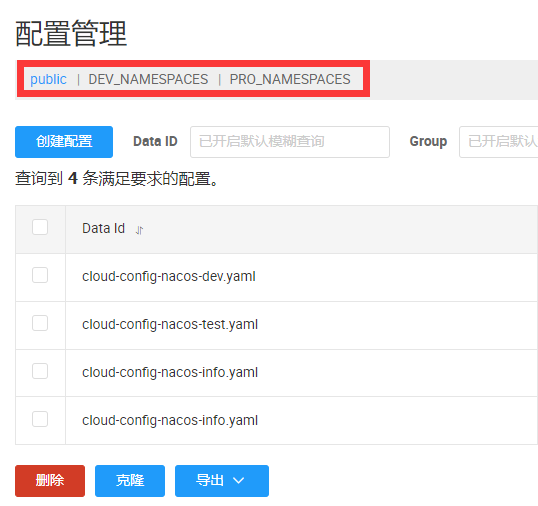

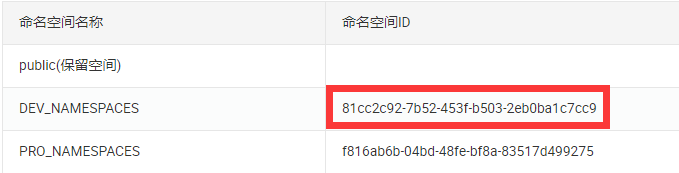

配置管理中显现的有命名空间:

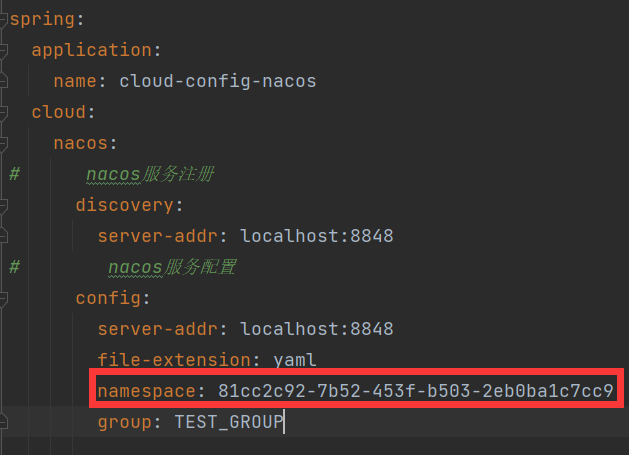

选中DEV_NAMESPACES命名空间,找到命名空间ID并配置到配置文件当中

在此命名空间下创建三个配置,文件名相同,分别位于不同的组

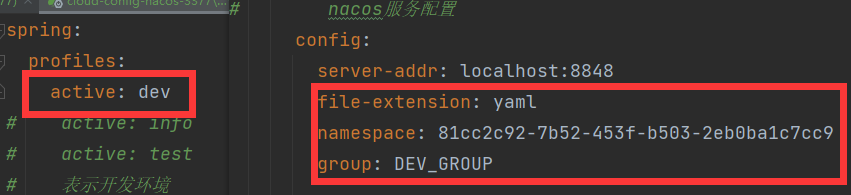

此时的配置文件

即查找此命名空间下的位于DEV_GROUP组中的profile为dev的yaml文件

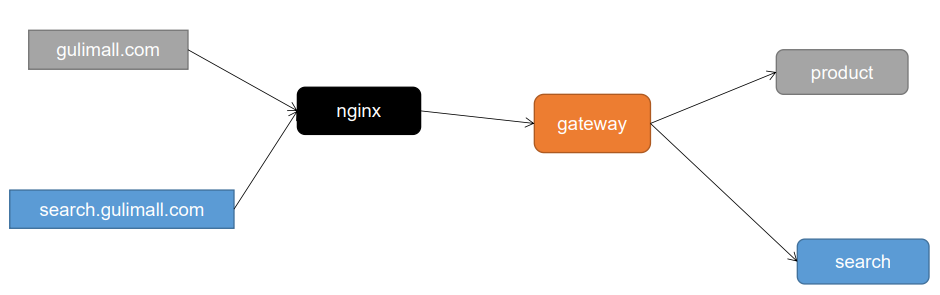

10.8SpringCloud Gateway(网关)

网关用来做统一的鉴权认证和限流工作。

10.8.1Gateway的3大核心概念

- Route(路由)

==路由是构建网关的基本模块,它由ID,目标URI,一系列的断言和过滤器组成,如果断言为true则匹配该路由==

- Predicate(断言)

参考的是Java8的java.util.function.Predicate

开发人员可以匹配HTTP请求中的所有内容(例如请求头或请求参数),==如果请求与断言相匹配则进行路由==

- Filter(过滤)

指的是Spring框架中GatewayFilter的实例,==使用过滤器,可以在请求被路由前或者之后对请求进行修改。==

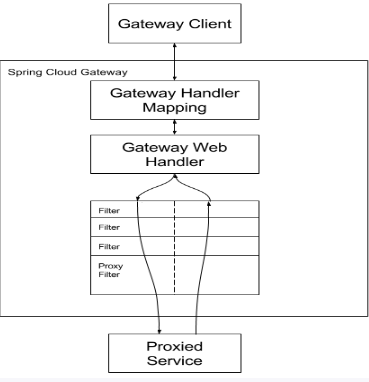

10.8.2Gateway的工作流程

核心逻辑为:

路由转发+执行过滤器链

客户端向 Spring Cloud Gateway 发出请求。然后在 Gateway Handler Mapping 中找到与请求相匹配的路由,将其发送到 Gateway Web Handler。

Handler 再通过指定的过滤器链来将请求发送到我们实际的服务执行业务逻辑,然后返回。过滤器之间用虚线分开是因为过滤器可能会在发送代理请求之前(“pre”)或之后(“post”)执行业务逻辑。

Filter在“pre”类型的过滤器可以做参数校验、权限校验、流量监控、日志输出、协议转换等,在“post”类型的过滤器中可以做响应内容、响应头的修改,日志的输出,流量监控等有着非常重要的作用。

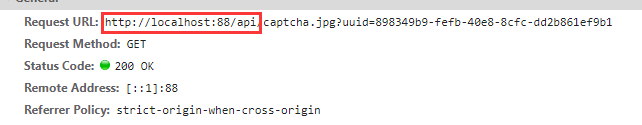

10.8.3网关配置

- 引入对应依赖

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-gateway</artifactId>

</dependency>- 在配置文件当中设置相应的路由规则

server:

port: 88

spring:

application:

name: gulimall-gateway

cloud:

nacos:

discovery:

server-addr: 192.168.26.160:8848

gateway:

routes:

# 根据Path断言,并过滤重写路径

# 路由到gulimall-member模块

# http://localhost:88/api/member/** -> http://localhost:8000/member/**

- id: member_route

uri: lb://gulimall-member

predicates:

- Path=/api/member/**

filters:

- RewritePath=/api/?(?<segment>.*), /$\{segment}

# 路由到gulimall-product模块

# http://localhost:88/api/product/** -> http://localhost:10000/product/**

- id: product_route

uri: lb://gulimall-product

predicates:

- Path=/api/product/**

filters:

- RewritePath=/api/?(?<segment>.*), /$\{segment}

# 路由到gulimall-ware模块

# http://localhost:88/api/ware/** -> http://localhost:11000/ware/**

- id: ware_route

uri: lb://gulimall-ware

predicates:

- Path=/api/ware/**

filters:

- RewritePath=/api/?(?<segment>.*), /$\{segment}

# 路由到gulimall-thirdserver 模块

- id: thirdserver_route

uri: lb://gulimall-thirdserver

predicates:

- Path=/api/thirdserver/**

filters:

- RewritePath=/api/?(?<segment>.*), /$\{segment}

# 路由到gulimall-coupon模块

# http://localhost:88/api/coupon -> http://localhost:7000/coupon/**

- id: coupon_route

uri: lb://gulimall-coupon

predicates:

- Path=/api/coupon/**

filters:

- RewritePath=/api/?(?<segment>.*), /$\{segment}

# 路由到renren-fast模块

# http://localhost:88/api/** -> http://localhost:8080/renren-fast/**

- id: admin_route

uri: lb://renren-fast

predicates:

- Path=/api/**

filters:

- RewritePath=/api/?(?<segment>.*), /renren-fast/$\{segment}

# 根据Host断言

# 根据Host(gulimall.com)路由到gulimall-product

- id: gulimall_host_route

uri: lb://gulimall-product

predicates:

- Host=gulimall.com,item.gulimall.com

# 根据Host(search.gulimall.com)路由到gulimall-search

- id: gulimall_search_route

uri: lb://gulimall-search

predicates:

- Host=search.gulimall.com

# 根据Host(auth.gulimall.com)路由到gulimall-search

- id: gulimall_auth_route

uri: lb://gulimall-auth-server

predicates:

- Host=auth.gulimall.com

# 根据Host(cart.gulimall.com)路由到gulimall-cart

- id: gulimall_cart_route

uri: lb://gulimall-cart

predicates:

- Host=cart.gulimall.com

# 根据Host(order.gulimall.com)路由到gulimall-order

- id: gulimall_order_route

uri: lb://gulimall-order

predicates:

- Host=order.gulimall.com

# 根据Host(member.gulimall.com)路由到gulimall-member

- id: gulimall_member_route

uri: lb://gulimall-member

predicates:

- Host=member.gulimall.com

# 根据Host(seckill .gulimall.com)路由到gulimall-seckill

- id: gulimall_seckill_route

uri: lb://gulimall-seckill

predicates:

- Host=seckill.gulimall.com

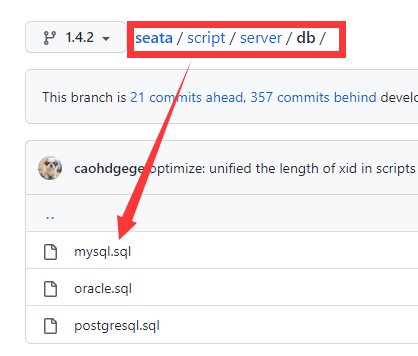

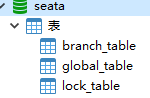

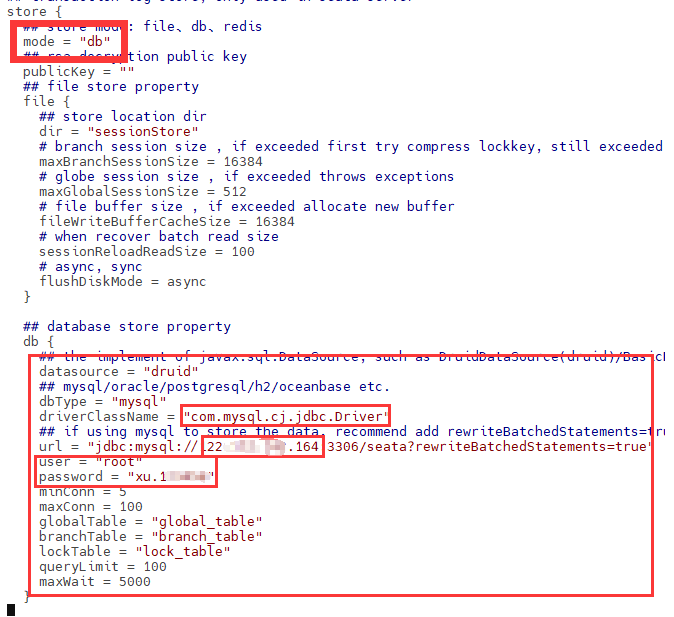

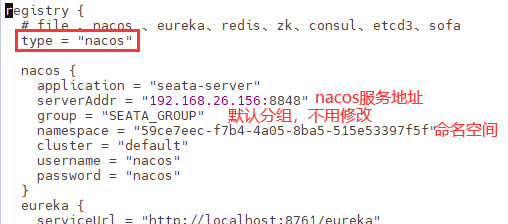

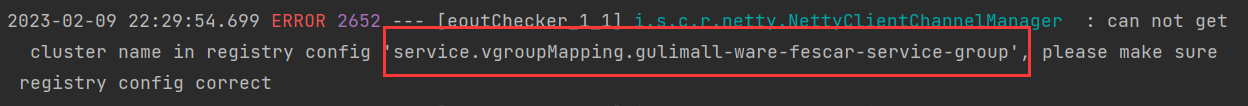

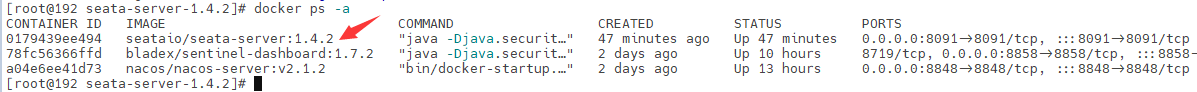

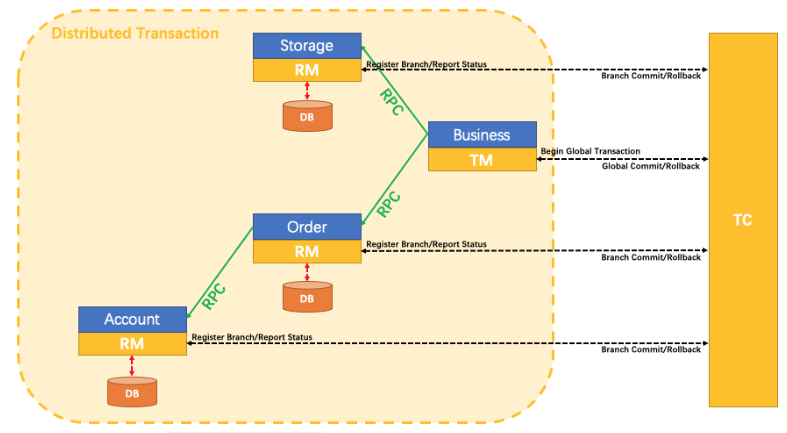

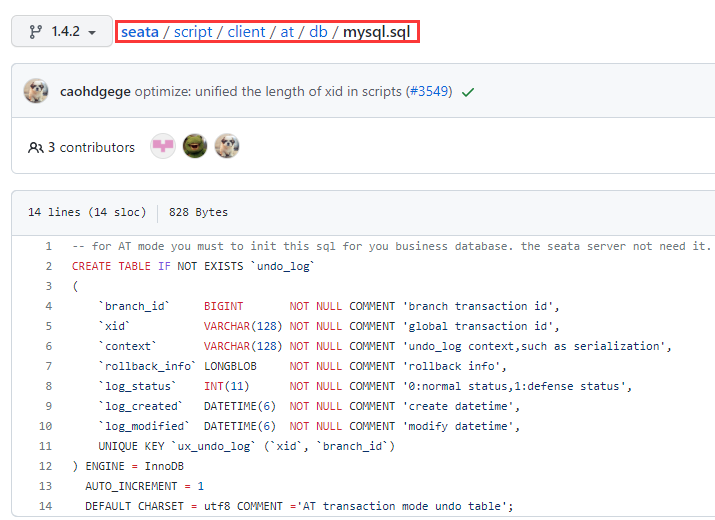

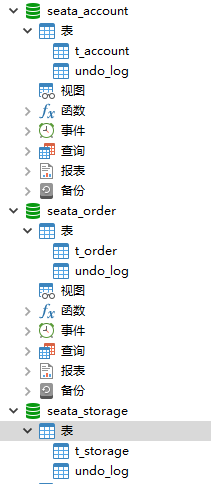

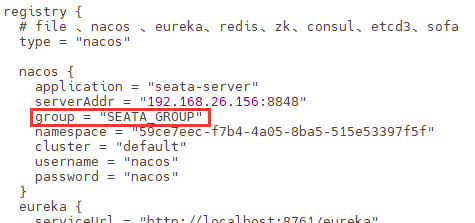

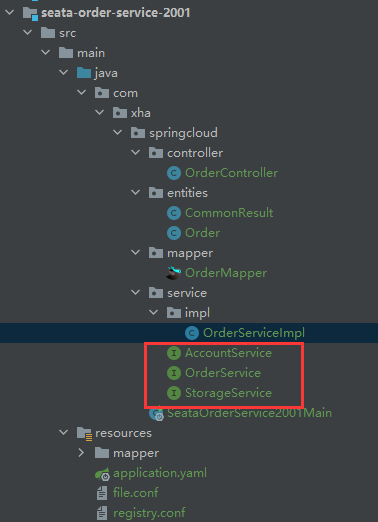

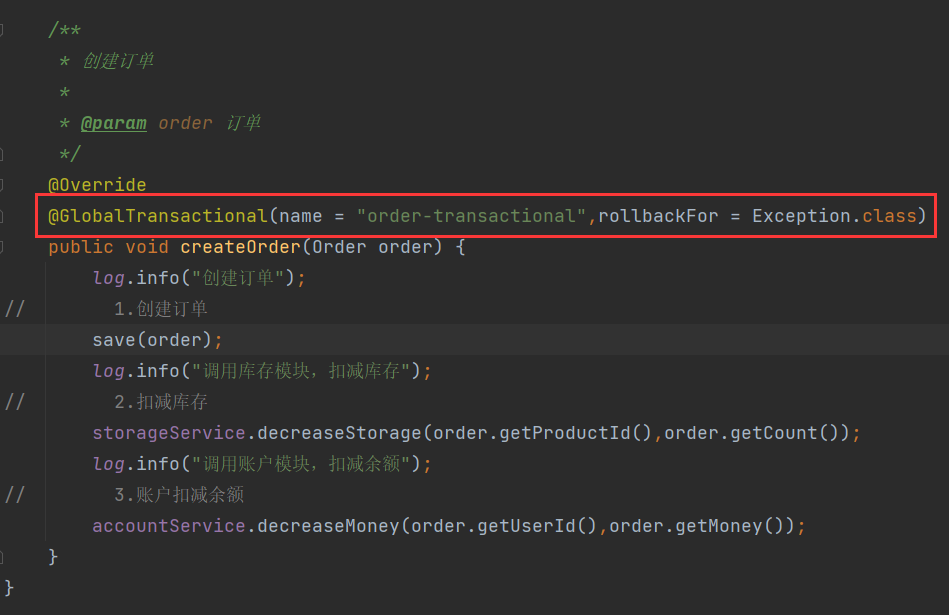

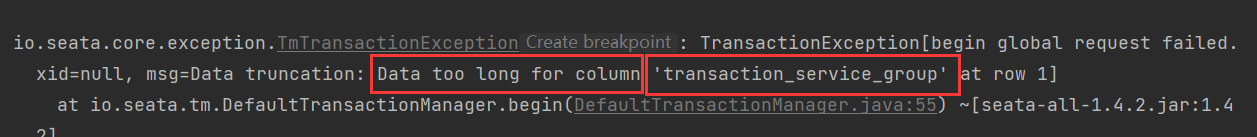

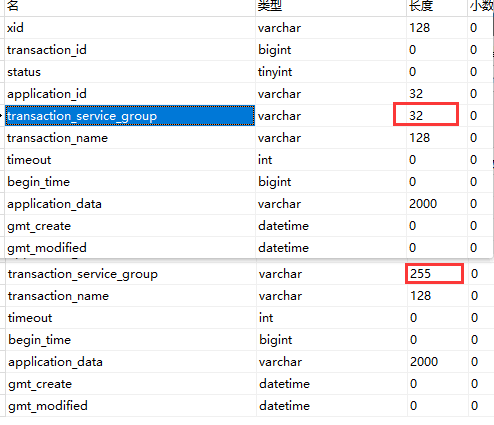

10.9seata处理分布式事务

10.10sentinel做服务降级、服务熔断、服务限流

10.10.1Sentinel简介

官网地址:https://sentinelguard.io/zh-cn/

Github地址:https://github.com/alibaba/Sentinel

随着微服务的流行,服务和服务之间的稳定性变得越来越重要。==Sentinel 是面向分布式、多语言异构化服务架构的流量治理组件,主要以流量为切入点,从流量路由、流量控制、流量整形、熔断降级、系统自适应过载保护、热点流量防护等多个维度来帮助开发者保障微服务的稳定性。==

即Sentinel就是面向云原生微服务的流量控制、熔断降级组件。

10.10.2Sentinel的功能

10.10.2.1流量控制

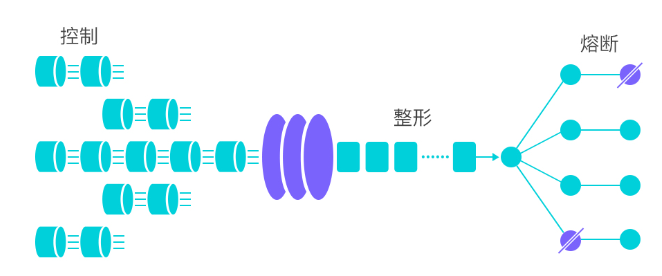

流量控制在网络传输中是一个常用的概念,它用于调整网络包的发送数据。然而,从系统稳定性角度考虑,在处理请求的速度上,也有非常多的讲究。任意时间到来的请求往往是随机不可控的,而系统的处理能力是有限的。我们需要根据系统的处理能力对流量进行控制。Sentinel 作为一个调配器,可以根据需要把随机的请求调整成合适的形状,如下图所示:

流量控制有以下几个角度:

- 资源的调用关系,例如资源的调用链路,资源和资源之间的关系;

- 运行指标,例如 QPS、线程池、系统负载等;

- 控制的效果,例如直接限流、冷启动、排队等。

Sentinel 的设计理念是让您自由选择控制的角度,并进行灵活组合,从而达到想要的效果。

10.10.2.2熔断降级

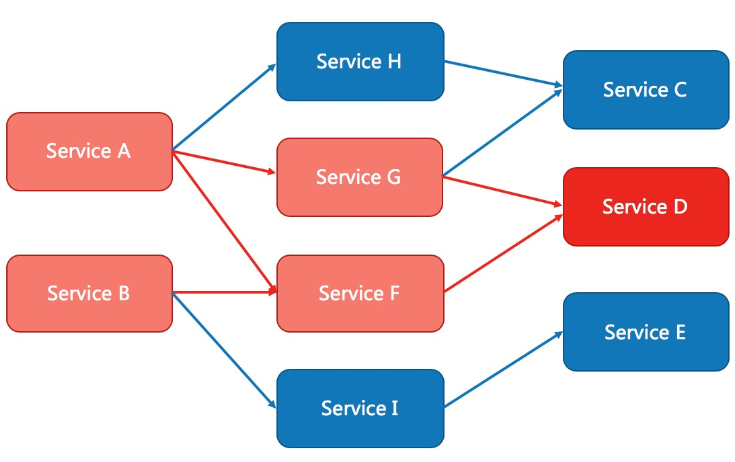

Sentinel熔断降级会在调用链路中某个资源出现不稳定状态时(例如调用超时或异常比例升高) , 对这个资源的调用进行限制让请求快速失败,避免影响到其它的资源而导致级联错误。

什么是熔断降级

除了流量控制以外,降低调用链路中的不稳定资源也是 Sentinel 的使命之一。由于调用关系的复杂性,如果调用链路中的某个资源出现了不稳定,最终会导致请求发生堆积。这个问题和 Hystrix 里面描述的问题是一样的。

==Sentinel 和 Hystrix 的原则是一致的: 当调用链路中某个资源出现不稳定,例如,表现为 timeout,异常比例升高的时候,则对这个资源的调用进行限制,并让请求快速失败,避免影响到其它的资源,最终产生雪崩的效果。==

熔断降级设计理念

在限制的手段上,Sentinel 和 Hystrix 采取了完全不一样的方法。

Hystrix 通过线程池的方式,来对依赖(在我们的概念中对应资源)进行了隔离。这样做的好处是资源和资源之间做到了最彻底的隔离。缺点是除了增加了线程切换的成本,还需要预先给各个资源做线程池大小的分配。

Sentinel 对这个问题采取了两种手段:

- 通过并发线程数进行限制

和资源池隔离的方法不同,Sentinel 通过限制资源并发线程的数量,来减少不稳定资源对其它资源的影响。这样不但没有线程切换的损耗,也不需要您预先分配线程池的大小。当某个资源出现不稳定的情况下,例如响应时间变长,对资源的直接影响就是会造成线程数的逐步堆积。当线程数在特定资源上堆积到一定的数量之后,对该资源的新请求就会被拒绝。堆积的线程完成任务后才开始继续接收请求。

- 通过响应时间对资源进行降级

除了对并发线程数进行控制以外,Sentinel 还可以通过响应时间来快速降级不稳定的资源。当依赖的资源出现响应时间过长后,所有对该资源的访问都会被直接拒绝,直到过了指定的时间窗口之后才重新恢复。

熔断降级策略

- 慢调用比例 (

SLOW_REQUEST_RATIO):选择以慢调用比例作为阈值,需要设置允许的慢调用 RT(即最大的响应时间),请求的响应时间大于该值则统计为慢调用。当单位统计时长(statIntervalMs)内请求数目大于设置的最小请求数目,并且慢调用的比例大于阈值,则接下来的熔断时长内请求会自动被熔断。经过熔断时长后熔断器会进入探测恢复状态(HALF-OPEN 状态),若接下来的一个请求响应时间小于设置的慢调用 RT 则结束熔断,若大于设置的慢调用 RT 则会再次被熔断。 - 异常比例 (

ERROR_RATIO):当单位统计时长(statIntervalMs)内请求数目大于设置的最小请求数目,并且异常的比例大于阈值,则接下来的熔断时长内请求会自动被熔断。经过熔断时长后熔断器会进入探测恢复状态(HALF-OPEN 状态),若接下来的一个请求成功完成(没有错误)则结束熔断,否则会再次被熔断。异常比率的阈值范围是[0.0, 1.0],代表 0% - 100%。 - 异常数 (

ERROR_COUNT):当单位统计时长内的异常数目超过阈值之后会自动进行熔断。经过熔断时长后熔断器会进入探测恢复状态(HALF-OPEN 状态),若接下来的一个请求成功完成(没有错误)则结束熔断,否则会再次被熔断。

10.10.3Sentinel使用说明

Sentinel 的使用可以分为两个部分:

- 核心库(Java 客户端):不依赖任何框架/库,能够运行于 Java 8 及以上的版本的运行时环境,同时对 Dubbo / Spring Cloud 等框架也有较好的支持(见 主流框架适配)。

- 控制台(Dashboard):Dashboard 主要负责管理推送规则、监控、管理机器信息等。

10.10.4Sentinel对Endpoint 支持

在使用 Endpoint 特性之前需要在 Maven 中添加 spring-boot-starter-actuator 依赖,并在配置中允许 Endpoints 的访问。

- Spring Boot 1.x 中添加配置

management.security.enabled=false。暴露的 endpoint 路径为/sentinel - Spring Boot 2.x 中添加配置

management.endpoints.web.exposure.include=*。暴露的 endpoint 路径为/actuator/sentinel

Sentinel Endpoint 里暴露的信息非常有用。包括当前应用的所有规则信息、日志目录、当前实例的 IP,Sentinel Dashboard 地址,Block Page,应用与 Sentinel Dashboard 的心跳频率等等信息。

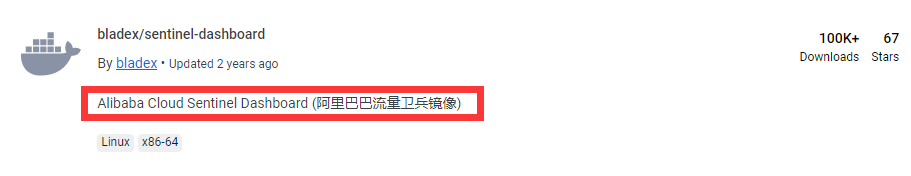

10.10.5docker安装Sentinel

- 来到Docker Hub查找镜像源

- 拉取镜像

docker pull bladex/sentinel-dashboard:1.7.2- 创建容器

docker run -d -p 8858:8858 --restart=always --name sentinel bladex/sentinel-dashboard:1.7.2- 开放端口,重启防火墙

firewall-cmd --zone=public --add-port=8858/tcp --permanent- 访问8858端口登录sentinel

10.10.6sentinel配置

- pom文件

添加springboot的监控系统—spring-boot-starter-actuator

<dependencies>

<!--SpringCloud ailibaba nacos -->

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

</dependency>

<!--SpringCloud ailibaba sentinel-datasource-nacos 后续做持久化用到-->

<dependency>

<groupId>com.alibaba.csp</groupId>

<artifactId>sentinel-datasource-nacos</artifactId>

</dependency>

<!--SpringCloud ailibaba sentinel -->

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-sentinel</artifactId>

</dependency>

<!--openfeign-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-openfeign</artifactId>

</dependency>

<!-- SpringBoot整合Web组件+actuator -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<dependency>

<groupId>cn.hutool</groupId>

<artifactId>hutool-all</artifactId>

<version>4.6.3</version>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

</dependencies>- yaml文件

将模块注册进nacos,使用sentinel做服务降级、服务熔断和服务限流

server:

port: 8401

spring:

application:

name: cloud-alibaba-sentinel

cloud:

nacos:

discovery:

#Nacos服务注册中心地址

server-addr: 192.168.26.149:8848

sentinel:

transport:

#配置Sentinel dashboard地址

dashboard: 192.168.26.149:8858

#sentinel监控服务,默认8719端口,假如被占用会自动从8719开始依次+1扫描,直至找到未被占用的端口

port: 8719

management:

endpoints:

web:

exposure:

include: '*'10.10.7自定义全局限流降级配置类

import cn.hutool.json.JSONUtil;

import com.alibaba.csp.sentinel.adapter.servlet.callback.UrlBlockHandler;

import com.alibaba.csp.sentinel.adapter.servlet.callback.WebCallbackManager;

import com.alibaba.csp.sentinel.slots.block.BlockException;

import com.xha.gulimall.common.enums.HttpCode;

import com.xha.gulimall.common.utils.R;

import org.springframework.context.annotation.Configuration;

import javax.servlet.http.HttpServletRequest;

import javax.servlet.http.HttpServletResponse;

import java.io.IOException;

@Configuration

public class SentinelConfig {

public SentinelConfig(){

WebCallbackManager.setUrlBlockHandler(new UrlBlockHandler() {

@Override

public void blocked(HttpServletRequest request, HttpServletResponse response, BlockException ex) throws IOException {

R error = R.error(HttpCode.TOO_MANY_REQUEST.getCode(), HttpCode.TOO_MANY_REQUEST.getMessage());

response.setCharacterEncoding("UTF-8");

response.setContentType("application/json");

response.getWriter().write(JSONUtil.toJsonStr(error));

}

});

}

}

10.10.8Sentinel对Feign 支持

Sentinel 适配了 Feign 组件。如果想使用,除了引入 spring-cloud-starter-alibaba-sentinel 的依赖外还需要 2 个步骤:

- 配置文件打开 Sentinel 对 Feign 的支持:

feign.sentinel.enabled=true

# 开启sentinel对openfeign的支持

feign:

sentinel:

enabled: true- 加入

spring-cloud-starter-openfeign依赖使 Sentinel starter 中的自动化配置类生效:

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-openfeign</artifactId>

</dependency>- 主启动类添加

EnableFeignClients注解 - 业务类

采用openfeign进行服务调用和服务降级

service层接口实现远程服务调用:

@FeignClient(value = "cloud-provider-alibaba-sentinel-ribbon",

fallback = PaymentServiceImpl.class)

public interface PaymentService {

@GetMapping("/paymenySQL/{id}")

public CommonResult<Payment> paymentSQL(@PathVariable Long id);

}接口实现类做服务熔断

@Component

public class PaymentServiceImpl implements PaymentService {

@Override

public CommonResult<Payment> paymentSQL(Long id) {

return new CommonResult<>(444,"服务熔断返回,没有该流水信息",new Payment(id, "errorSerial......"));

}

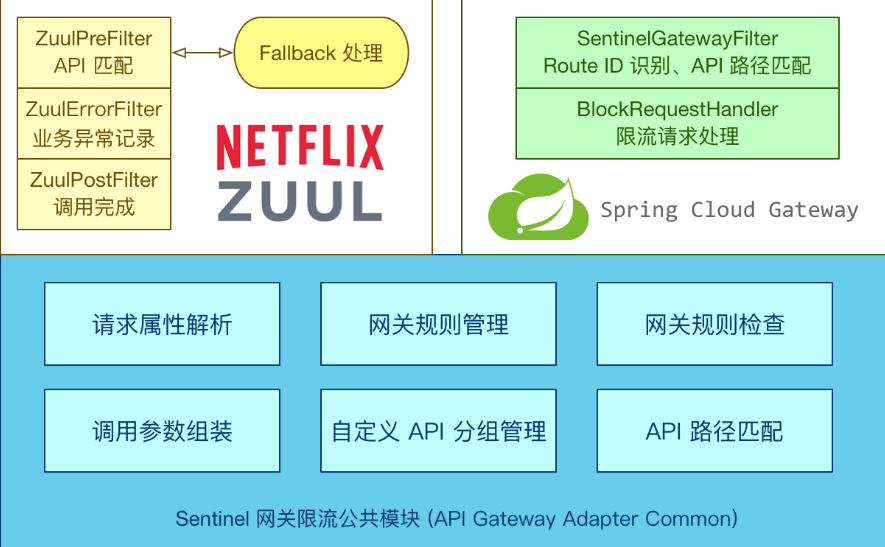

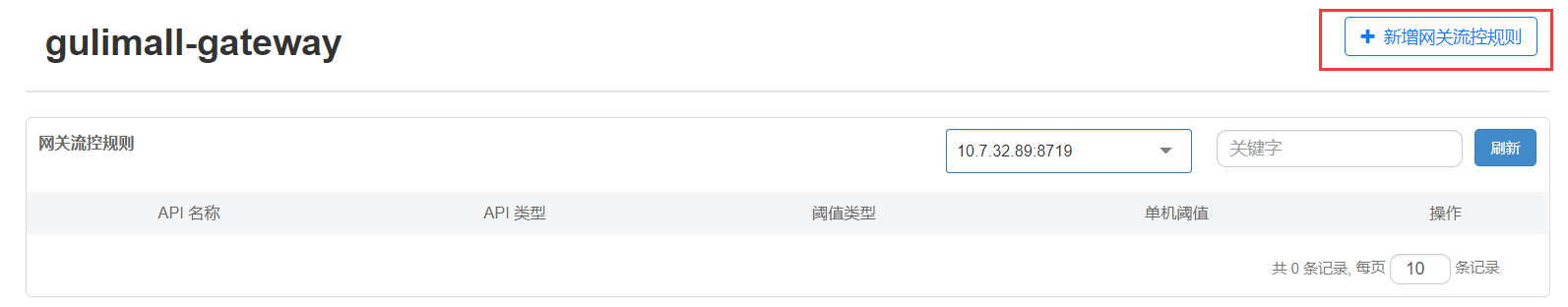

}10.10.9网关流控

- Sentinel 支持对 Spring Cloud Gateway、Zuul 等主流的 API Gateway 进行限流。

- 添加sentinel和gateway的整合依赖

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-alibaba-sentinel-gateway</artifactId>

<version>2.1.0.RELEASE</version>

</dependency>- 查看Sentinel控制台

新增网关流控规则

API名称对应的就是网关断言id

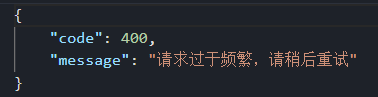

10.10.10自定义网关流控返回规则

import com.alibaba.csp.sentinel.adapter.gateway.sc.callback.BlockRequestHandler;

import com.alibaba.csp.sentinel.adapter.gateway.sc.callback.GatewayCallbackManager;

import org.springframework.context.annotation.Configuration;

import org.springframework.web.reactive.function.server.ServerResponse;

import org.springframework.web.server.ServerWebExchange;

import reactor.core.publisher.Mono;

@Configuration

public class SentinelGatewayConfig {

public SentinelGatewayConfig(){

GatewayCallbackManager.setBlockHandler(

new BlockRequestHandler() {

@Override

public Mono<ServerResponse> handleRequest(ServerWebExchange serverWebExchange, Throwable throwable) {

String response = "{\n" +

"\"code\":400,\n" +

"\"message\":\"请求过于频繁,请稍后重试\"\n" +

"}";

Mono<ServerResponse> monoResult = ServerResponse.ok().body(Mono.just(response), String.class);

return monoResult;

}

}

);

}

}

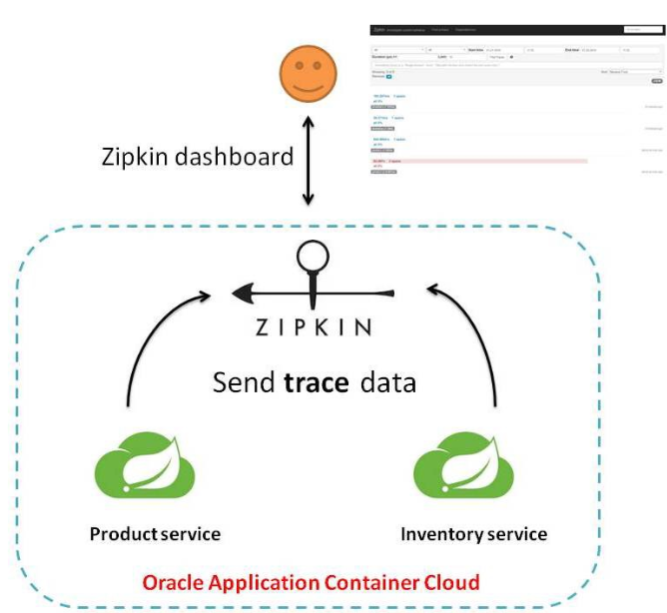

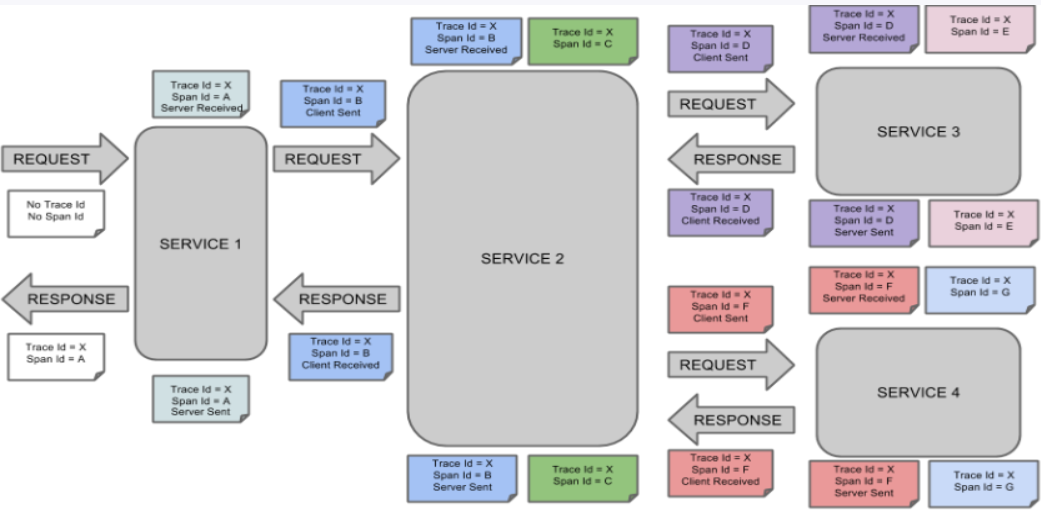

10.11Sleuth+ZipKin服务链路追踪

10.11.1问题引出

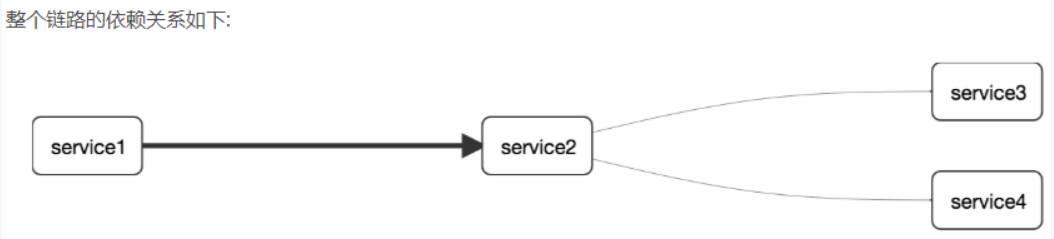

==在微服务框架中,一个由客户端发起的请求在后端系统中会经过多个不同的的服务节点调用来协同产生最后的请求结果。==每一个前端请求都会形成一条复杂的分布式服务调用链路,链路中的任何一环出现高延时或错误都会引起整个请求最后的失败。

。==

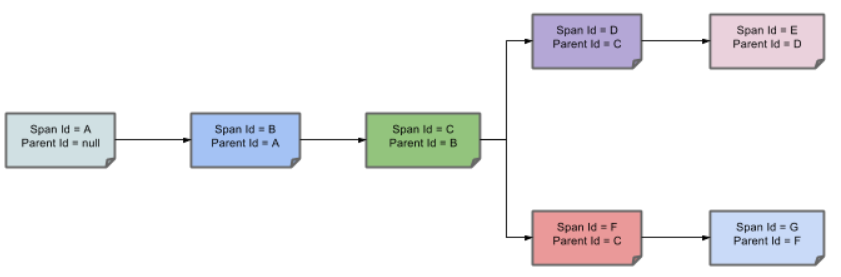

10.11.3完整调用链路

表示一请求链路,一条链路通过**Trace Id唯一标识,Span标识发起的请求信息,各span通过parent id 关联起来**

10.11.4链路追踪环境搭建

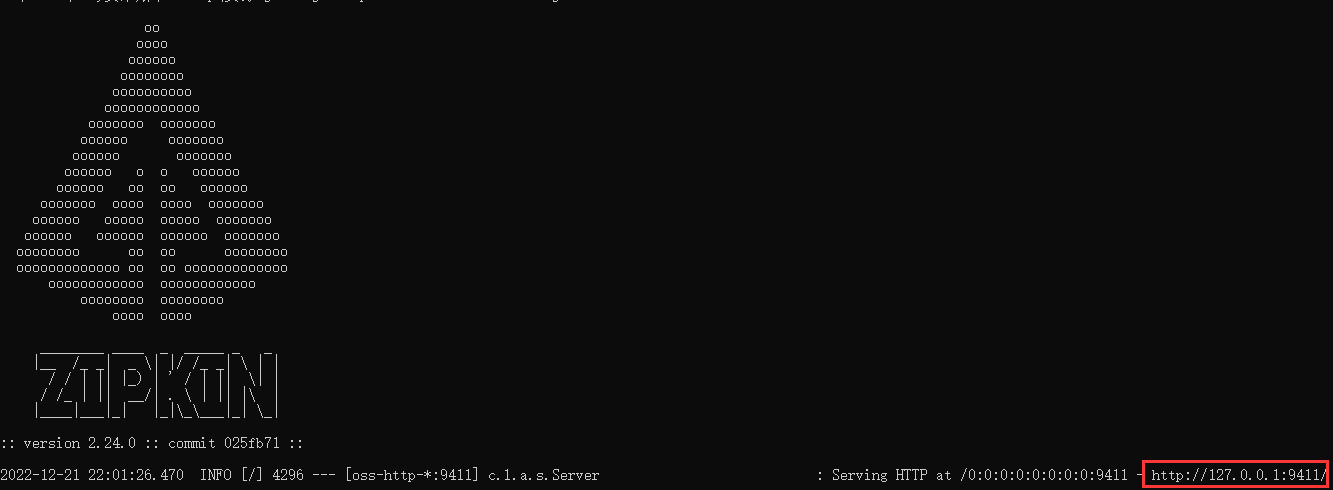

10.11.4.1本地方式启动

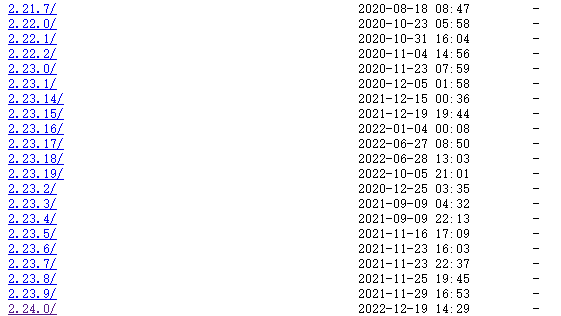

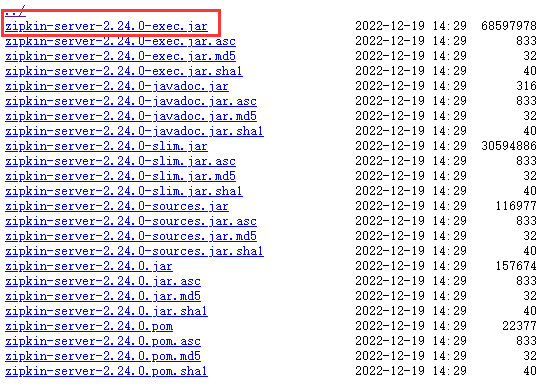

- 启动zipkin-server

SpingCloud从F版起已不需要自己构建ZIpkin Sever了,只需调用jar包即可

下载地址:https://repo1.maven.org/maven2/io/zipkin/zipkin-server/

本地启动zipkin:

java -jar jar包名

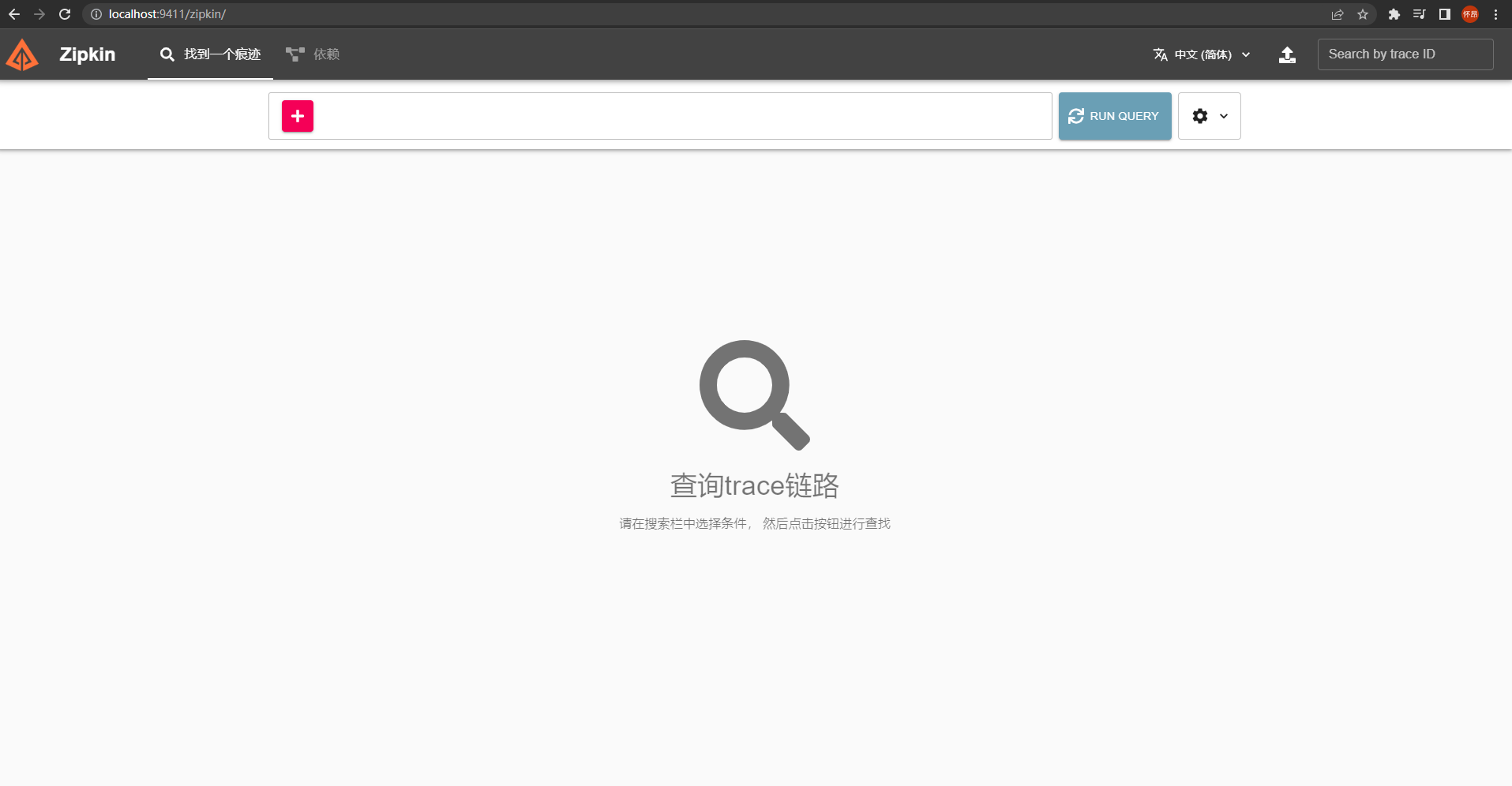

访问zipkin可视化界面

ip:9411/zipkin/

10.11.4.2docker安装zipkin

docker pull openzipkin/zipkin

docker run -d -p 9411:9411 openzipkin/zipkin

x1firewall-cmd --zone=public --add-port=8091/tcp --permanent

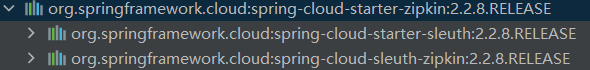

systemctl restart firewalld.service10.11.5SpringCloud整合Sleuth

- 引入对应依赖

<!--包含了sleuth+zipkin-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-zipkin</artifactId>

</dependency>

- 配置文件

# zipkin

zipkin:

base-url: http://192.168.26.160:9411/

# 关闭zipkin的服务发现

discovery-client-enabled: false

# 以http的方式传输数据

sender:

type: web

# sleuth采样器

sleuth:

sampler:

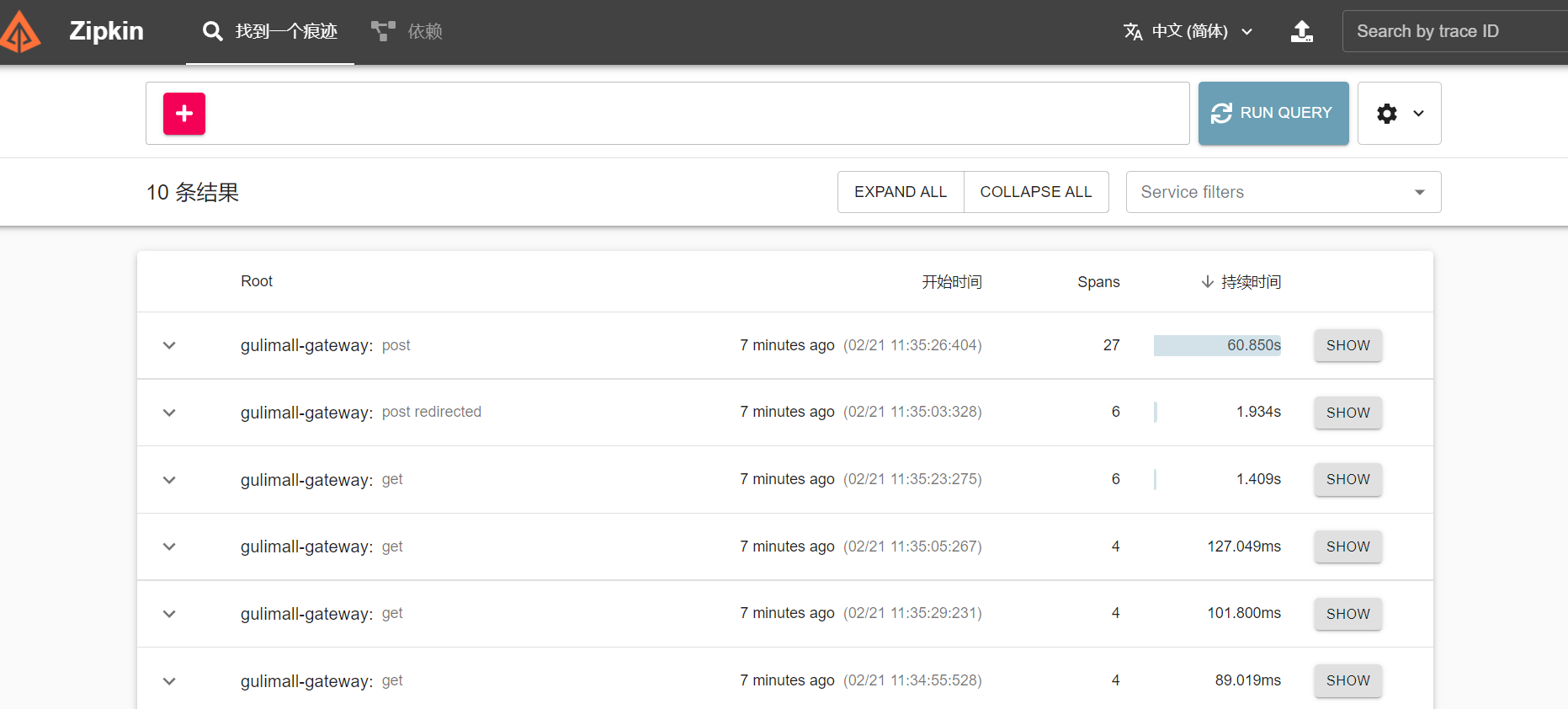

probability: 110.11.6链路追踪效果

- 开启各个服务,进行服务之间的调用,打开zipkin地址,查看服务调用情况

- 查看服务模块之间的依赖关系

11.相关概念

11.1SPU和SKU

SPU:Standard Product Unit(标准化产品单元) ==是商品信息聚合的最小单位,是一组可复用、易检索的标准化信息的集合,该集合描述了一 个产品的特性。==

如:iphoneX 是 SPU、MI 8 是 SPU iphoneX 64G 黑曜石 是 SKU

SKU:Stock Keeping Unit(库存量单位) ==即库存进出计量的基本单元,可以是以件,盒,托盘等为单位。SKU 这是对于大型连锁超市 DC(配送中心)物流管理的一个必要的方法。现在已经被引申为产品统一编号的简称,每种产品均对应有唯一的 SKU 号。==

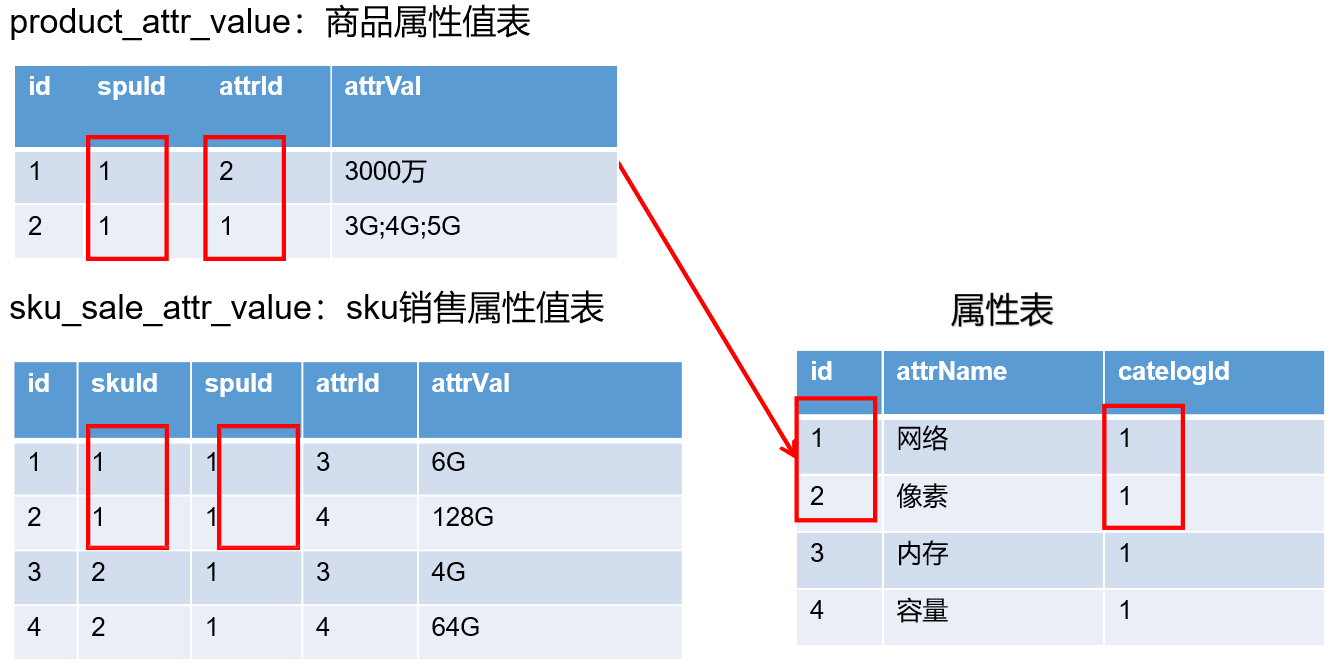

11.2SPU-SKU-属性表

11.3基本属性与销售属性

每个分类下的商品共享规格参数,与销售属性。只是有些商品不一定要用这个分类下全部的属性;

- 属性是以三级分类组织起来的

- 规格参数中有些是可以提供检索的

- 规格参数也是基本属性,他们具有自己的分组

- 属性的分组也是以三级分类组织起来的

- 属性名确定的,但是值是每一个商品不同来决定的

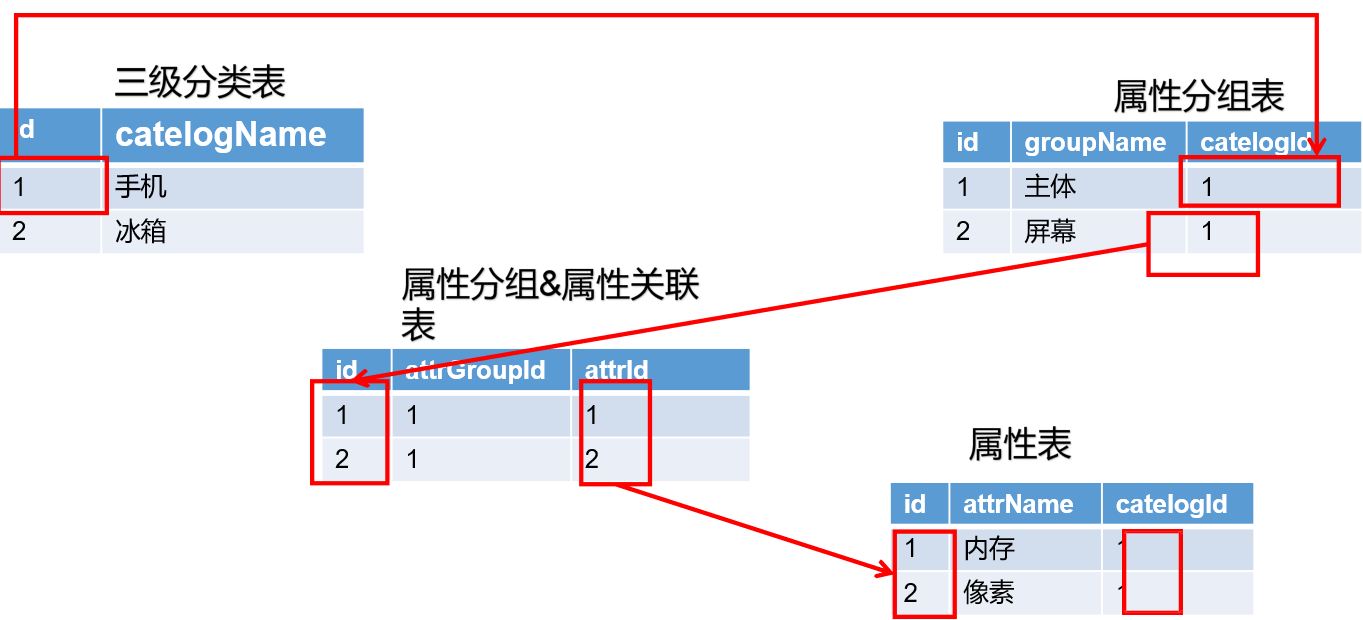

11.4三级分类-属性分组-销售属性关联关系

11.5Object 划分

- PO(persistant object) 持久对象

PO 就是对应数据库中某个表中的一条记录,多个记录可以用 PO 的集合。 PO 中应该不包含任何对数据库的操作。

- DO(Domain Object)领域对象

就是从现实世界中抽象出来的有形或无形的业务实体。

- TO(Transfer Object) 数据传输对象

不同的应用程序(模块)之间传输的对象

- DTO(Data Transfer Object)数据传输对象

这个概念来源于 J2EE 的设计模式,原来的目的是为了 EJB 的分布式应用提供粗粒度的 数据实体,以减 少分布式调用的次数,从而提高分布式调用的性能和降低网络负载,但在这 里,泛指用于展示层与服务层之间的数据传输对象。

- VO(viewobject) 视图对象

通常用于业务层之间的数据传递,和 PO 一样也是仅仅包含数据而已。但应是抽象出 的业务对象 , 可以和表对应 , 也可以不 , 这根据业务的需要 。用 new 关键字创建,由 GC 回收的。 View object:视图对象; 接受页面传递来的数据,封装对象将业务处理完成的对象,封装成页面要用的数据

- BO(business object) 业务对象

从业务模型的角度看 , 见 UML 元件领域模型中的领域对象。封装业务逻辑的 java 对 象 , 通过调用 DAO方法 , 结合 PO,VO 进行业务操作。business object: 业务对象 主要作 用是把业务逻辑封装为一个对象。这个对象可以包括一个或多个其它的对象。 比如一个简 历,有教育经历、工作经历、社会关系等等。 我们可以把教育经历对应一个 PO ,工作经 历对应一个 PO ,社会关系对应一个 PO 。 建立一个对应简历的 BO 对象处理简历,每 个 BO 包含这些 PO 。 这样处理业务逻辑时,我们就可以针对 BO 去处理。

- POJO(plain ordinary java object) 简单无规则 java 对象,传统意义的 java 对象

就是说在一些 Object/Relation Mapping 工具中,能够做到维护 数据库表记录的 persisent object 完全是个符合 Java Bean 规范的纯 Java 对象,没有增 加别的属性和方法。我的理解就是最基本的 java Bean ,只有属性字段及 setter 和 getter 方法!。 POJO 是 DO/DTO/BO/VO 的统称。

- DAO(data access object) 数据访问对象

是一个 sun 的一个标准 j2ee 设计模式, 这个模式中有个接口就是 DAO ,它负持久 层的操作。为业务层提供接口。此对象用于访问数据库。通常和 PO 结合使用, DAO 中包 含了各种数据库的操作方法。通过它的方法 , 结合 PO 对数据库进行相关的操作。夹在业 务逻辑与数据库资源中间。配合 VO, 提供数据库的 CRUD 操作

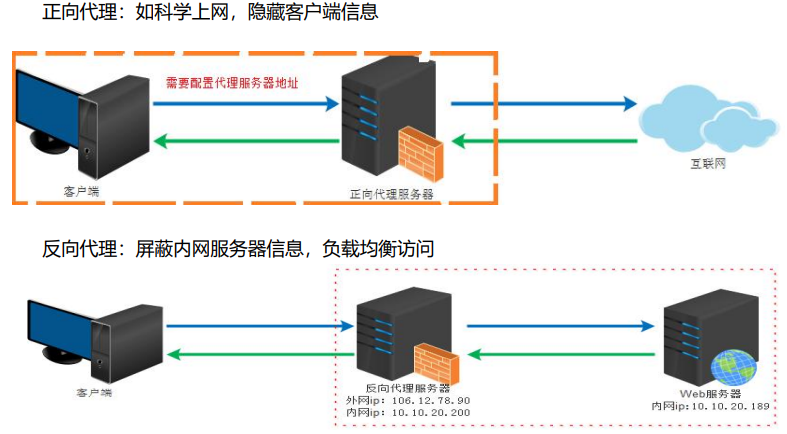

11.6正向代理与反向代理

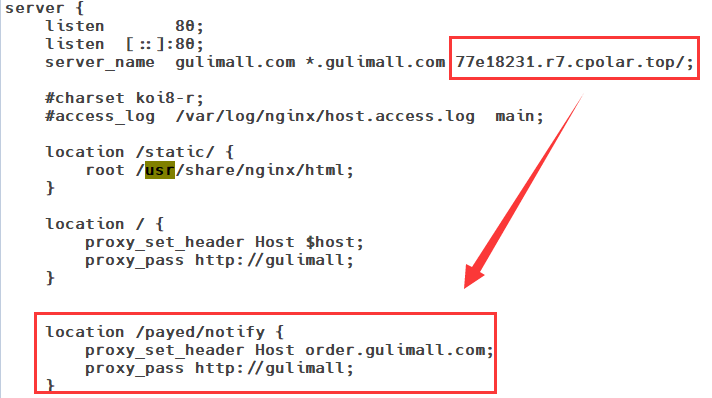

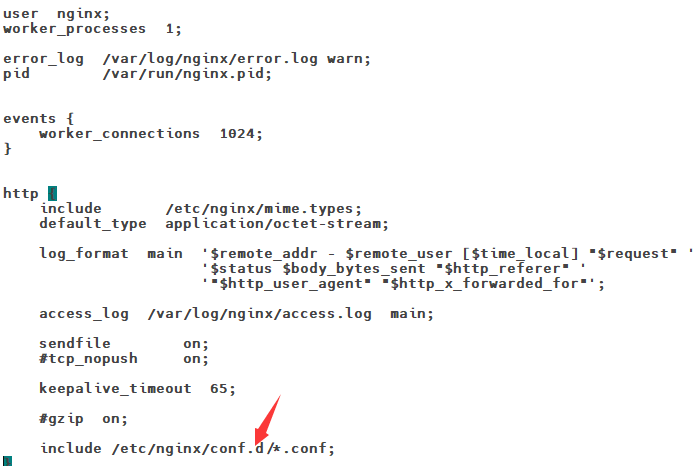

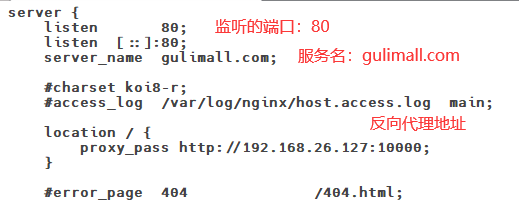

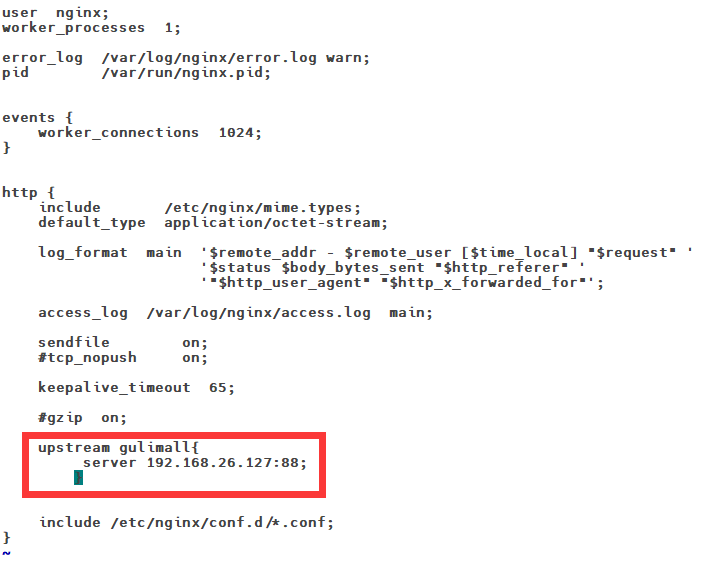

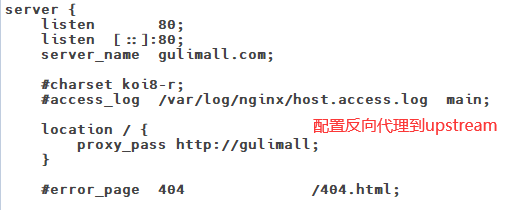

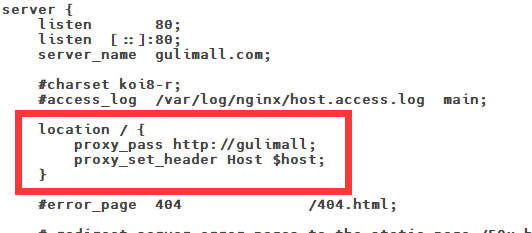

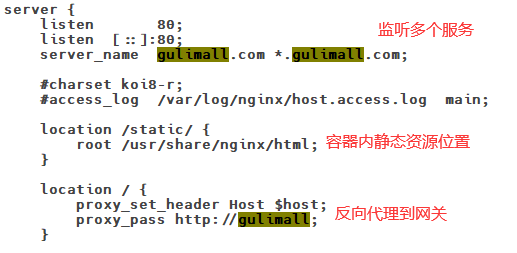

11.7Nginx配置文件

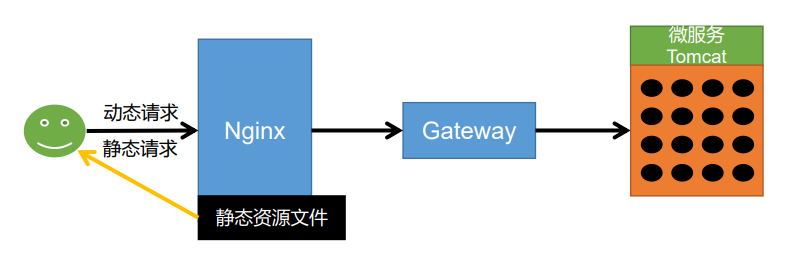

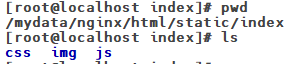

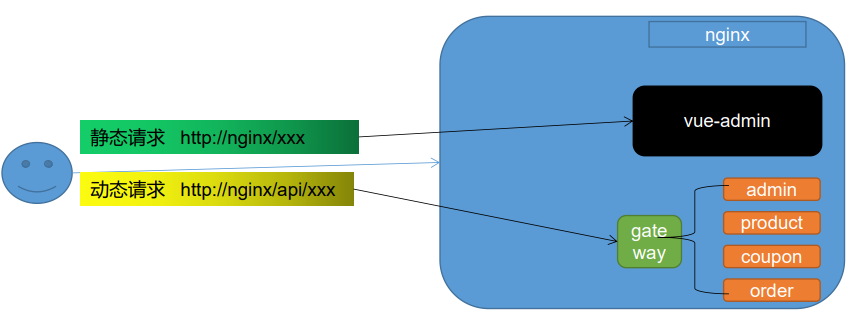

11.8Nginx动静分离

为了提供接口性能,提高响应速度,实现Nginx动静分离,Nginx直接返回静态资源:

- 将所有项目的静态资源都应该放在nginx里面

- 规则:/static/**所有请求都由nginx直接返回

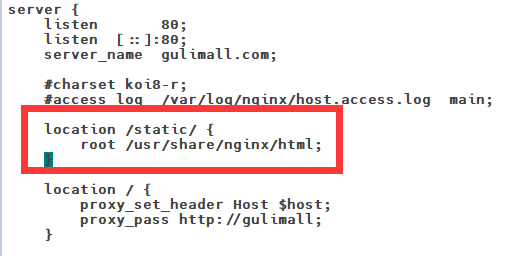

修改nginx中gulimall.conf的配置文件,添加静态资源路径:

location /static/ {

root /usr/share/nginx/html;

}

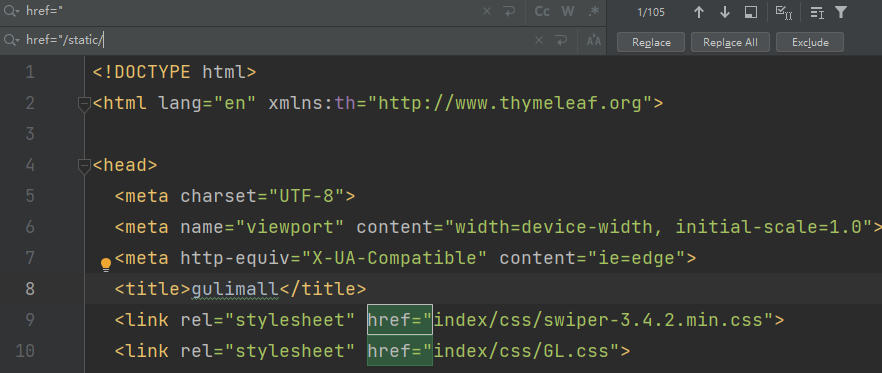

修改项目中静态资源的访问路径:

11.9性能测试指标

- 响应时间(Response Time: RT)

响应时间指用户从客户端发起一个请求开始,到客户端接收到从服务器端返回的响

应结束,整个过程所耗费的时间。 - HPS(Hits Per Second) :每秒点击次数,单位是次/秒。

- TPS(Transaction per Second):系统每秒处理交易数,单位是笔/秒。

- QPS(Query per Second):系统每秒处理查询次数,单位是次/秒。对于互联网业务中,如果某些业务有且仅有一个请求连接,那么 TPS=QPS=HPS,一般情况下用 TPS 来衡量整个业务流程,用 QPS 来衡量接口查询次数,用 HPS 来表示对服务器单击请求。

- 无论 TPS、QPS、HPS,此指标是衡量系统处理能力非常重要的指标,越大越好,根据经验,一般情况下:

金融行业:1000TPS50000TPS,不包括互联网化的活动100000TPS,不包括互联网化的活动

保险行业:100TPS

制造行业:10TPS5000TPS1000000TPS

互联网电子商务:10000TPS

互联网中型网站:1000TPS50000TPS10000TPS

互联网小型网站:500TPS - 最大响应时间(Max Response Time) 指用户发出请求或者指令到系统做出反应(响应)的最大时间。

- 最少响应时间(Mininum ResponseTime) 指用户发出请求或者指令到系统做出反应(响应)的最少时间。

- 90%响应时间(90% Response Time) 是指所有用户的响应时间进行排序,第 90%的响应时间。

- 从外部看,性能测试主要关注如下三个指标

- 吞吐量:==每秒钟系统能够处理的请求数、任务数。==

- 响应时间:==服务处理一个请求或一个任务的耗时。==

- 错误率:==一批请求中结果出错的请求所占比例。==

11.10SQL优化—添加索引

11.10.1什么是索引?

一个索引是存储的表中一个特定列的值数据结构(最常见的是B-Tree)。索引是在表的列上创建。所以,要记住的关键点是索引包含一个表中列的值,并且这些值存储在一个数据结构中。请记住记住这一点:**索引是一种数据结构 。**

11.10.2什么样的数据结构可以作为索引?

==B-Tree 是最常用的用于索引的数据结构。因为它们是时间复杂度低, 查找、删除、插入操作都可以可以在对数时间内完成。另外一个重要原因存储在B-Tree 中的数据是有序的。==数据库管理系统(RDBMS)通常决定索引应该用哪些数据结构。但是,在某些情况下,在创建索引时可以指定索引要使用的数据结构。

11.10.3索引是怎么提升性能的?

因为索引基本上是用来存储列值的数据结构,这使查找这些列值更加快速。如果索引使用最常用的数据结构-B-Tree那么其中的数据是有序的。有序的列值可以极大的提升性能。

11.11JVM

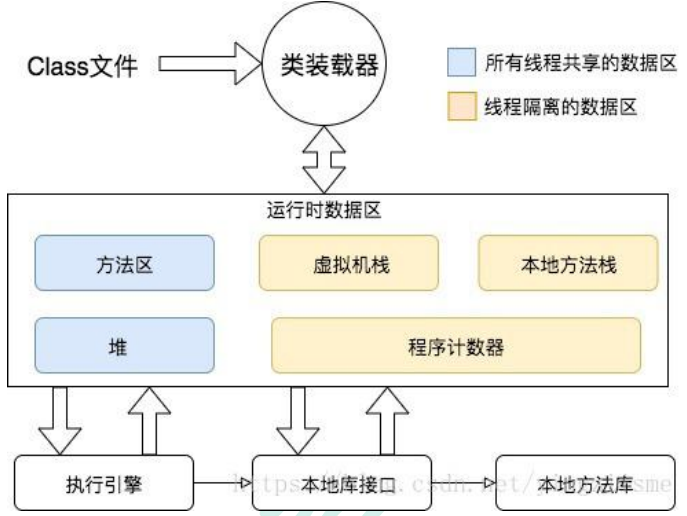

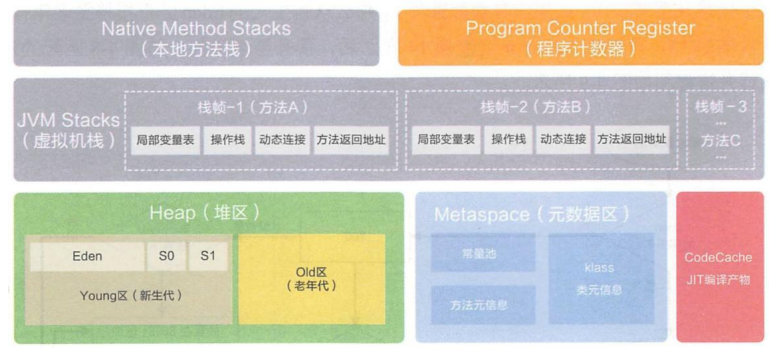

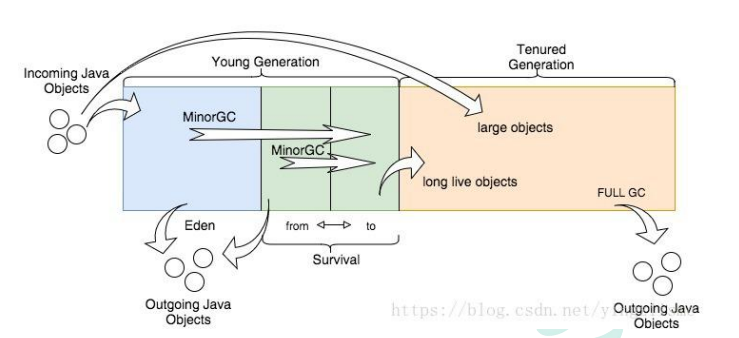

11.9.1JVM内存模型

JVM会将.java文件编译为.class文件

这里主要关注的**堆**

11.9.2 堆

所有的对象实例以及数组都要在堆上分配。**堆是垃圾收集器管理的主要区域**,也被称为“GC 堆”;也是我们优化最多考虑的地方。

堆可以细分为:

- 新生代

- Eden 空间

- From Survivor 空间

- To Survivor 空间

- 老年代

- 永久代/元空间

- java8 以前永久代,受 jvm 管理,java8 以后元空间,直接使用物理内存。因此, 默认情况下,元空间的大小仅受本地内存限制。

11.9.3jconsole和jvisualvm

Jdk 的两个小工具 jconsole、jvisualvm(升级版的 jconsole);通过命令行启动,可监控本地和 远程应用。远程应用需要配置

jvisualvm的功能:

- 监控内存泄露,跟踪垃圾回收,执行时内存、cpu 分析,线程分析…

线程状态:

运行:正在运行的

休眠:sleep

等待:wait

驻留:线程池里面的空闲线程

监视:阻塞的线程,正在等待锁

11.12Spring Cache

11.12.1Spring Cache简介

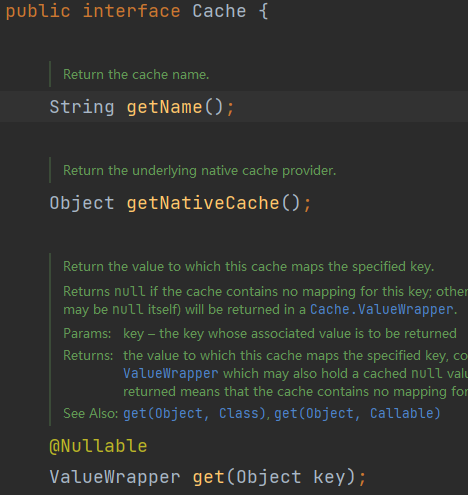

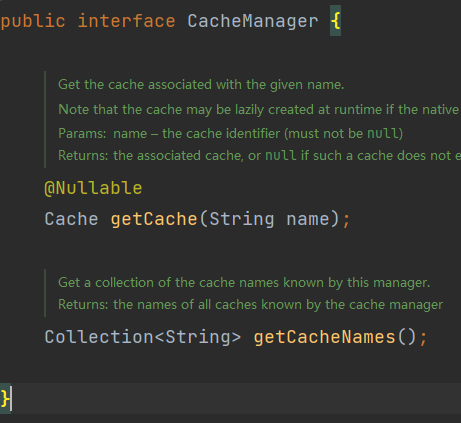

Spring 从 3.1 开始定义了

org.springframework.cache.Cache和org.springframework.cache.CacheManager接口来统一不同的缓存技术; 并支持使用 JCache(JSR-107)注解简化我们开发;

Cache接口:

CacheManager接口:

Cache 接口为缓存的组件规范定义,包含缓存的各种操作集合; Cache 接 口 下 Spring 提 供 了 各 种 xxxCache 的 实 现 ; 如 RedisCache , EhCacheCache , ConcurrentMapCache 等;

每次调用需要缓存功能的方法时,Spring 会检查指定参数的指定的目标方法是否已经被调用过;如果有就直接从缓存中获取方法调用后的结果,如果没有就调用方法并缓存结果后返回给用户。下次调用直接从缓存中获取。

使用 Spring 缓存抽象时我们需要关注以下两点;

- 确定方法需要被缓存以及他们的缓存策略

- 从缓存中读取之前缓存存储的数据

11.12.2配置Spring Cache

- 添加对应的依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-cache</artifactId>

</dependency>- 配置文件指定缓存类型

spring:

cache:

type: redis- 在主启动类/配置类开启缓存功能

在启动类/配置类添加@EnableCaching注解

11.12.3Spring Cache—基于声明式注释的缓存

对于缓存声明,Spring 的缓存抽象提供了一组 Java 注释:

@Cacheable:触发保存缓存。@CacheEvict:触发删除缓存。@CachePut:在不干扰方法执行的情况下更新缓存。@Caching:重新组合要应用于方法的多个缓存操作。@CacheConfig:在类级别共享一些与缓存相关的常见设置。

11.12.3.1@Cacheable

使用@Cacheable注解缓存数据时

需要指定要放到哪个名字的缓存【缓存的分区:按照业务类型分】

@Cacheable({category})- 代表当前方法的结果需要缓存,如果缓存中已经存在,对应的方法不再调用

- 如果缓存中没有就会调用方法,最后将方法结果放入缓存

默认行为

- 如果缓存中有,方法不用调用。

- key默认自动生成,缓存的名字::SimpleKey (自主生成的key值)。

- 缓存的value的值。默认使用jdk序列化机制ObjectOutPutStream,将序列化后的数据存到redis

- 默认ttl时间-1;

因为key是SpEL表达式类型,所以需要加单引号

/**

* 查询出所有的一级分类

*

* @return {@link List}<{@link CategoryEntity}>

*/

@Override

@Cacheable(value = "category",key = "'getFirstCategory'")

public List<CategoryEntity> getFirstCategory() {

LambdaQueryWrapper<CategoryEntity> queryWrapper = new LambdaQueryWrapper<>();

queryWrapper.eq(CategoryEntity::getParentCid, NumberConstants.TOP_LEVEL_CATEGORY);

List<CategoryEntity> firstCategory = categoryDao.selectList(queryWrapper);

return firstCategory;

}对于@Cacheable注解的默认行为,也可以自定义规则(自定义规则在11.12.4章节)

- 指定生成的缓存使用的key

- 将缓存数据保存为json格式

- 指定缓存数据的过期时间

11.12.3.2@CacheEvict

//按照分区名和key删除缓存

@CacheEvict(value = "category",key = "'getFirstCategory'")

//按照分区名删除该分区下的所有缓存

@CacheEvict(value = "category",allEntries = true)11.12.4SpringCache自定义配置

- 配置文件

spring:

# spring-cache指定缓存类型

cache:

type: redis

# 指定缓存的过期时间

redis:

time-to-live: 3600000

# 如果指定了前缀,就是用配置文件中的前缀,如果没有配置前缀就是用缓存名作为前缀

key-prefix: CACHE_

use-key-prefix: true

# 是否缓存空值,防止缓存穿透

cache-null-values: true- 配置类

import org.springframework.boot.autoconfigure.cache.CacheProperties;

import org.springframework.boot.context.properties.EnableConfigurationProperties;

import org.springframework.cache.annotation.EnableCaching;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.data.redis.cache.RedisCacheConfiguration;

import org.springframework.data.redis.serializer.GenericJackson2JsonRedisSerializer;

import org.springframework.data.redis.serializer.RedisSerializationContext;

import org.springframework.data.redis.serializer.StringRedisSerializer;

@EnableCaching

@Configuration

@EnableConfigurationProperties(CacheProperties.class)

public class SpringCacheConfig {

@Bean

RedisCacheConfiguration redisCacheConfiguration(CacheProperties cacheProperties){

// 1.首先创建RedisCacheConfiguration对象

RedisCacheConfiguration cacheConfig = RedisCacheConfiguration.defaultCacheConfig();

// 2.指定key的序列化器为String类型

cacheConfig = cacheConfig

.serializeKeysWith(RedisSerializationContext.SerializationPair.fromSerializer(new StringRedisSerializer()));

// 3.指定value的序列化器为Json类型

cacheConfig = cacheConfig

.serializeValuesWith(RedisSerializationContext.SerializationPair.fromSerializer(new GenericJackson2JsonRedisSerializer()));

// 4.CacheProperties的作用就是读取配置文件中的配置,将配置文件中的所有配置都生效

CacheProperties.Redis redisProperties = cacheProperties.getRedis();

if (redisProperties.getTimeToLive() != null){

cacheConfig = cacheConfig.entryTtl(redisProperties.getTimeToLive());

}

if (redisProperties.getKeyPrefix() != null){

cacheConfig = cacheConfig.prefixKeysWith(redisProperties.getKeyPrefix());

}

if (!redisProperties.isUseKeyPrefix()){

cacheConfig = cacheConfig.disableKeyPrefix();

}

if (!redisProperties.isCacheNullValues()){

cacheConfig = cacheConfig.disableCachingNullValues();

}

return cacheConfig;

}

}

11.12.5SpringCache的不足

- 读模式

- 缓存穿透:查询的是一个空数据。解决:缓存空数据:cache-null-values=true

- 缓存击穿:一个高并发访问的key失效问题。解决:加锁,默认是无锁的sync = true

- 缓存雪崩:大量的key同时过期。解决:加随机时间spring.cache.redis.time-to-live: 3600000

- 写模式

- 读写加锁

- 读多写多,直接查询数据库

11.13异步

11.13.1初始化线程的4种方式

- 继承 Thread

- 实现 Runnable 接口

- 实现 Callable 接口 + FutureTask (可以拿到返回结果,可以处理异常)

- 线程池

对于以上初始化线程的方式:

- 方式 1 和方式 2:主进程无法获取线程的运算结果。不适合当前场景

- 方式 3:主进程可以获取线程的运算结果,但是不利于控制服务器中的线程资源。可以导致服务器资源耗尽。

- 方式 4:通过如下两种方式初始化线程池

Executors.newFiexedThreadPool(3);

//或者

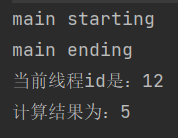

new ThreadPoolExecutor(corePoolSize, maximumPoolSize, keepAliveTime, TimeUnit unit, workQueue, threadFactory, handler);11.13.2线程实现方式测试

- 继承Thread类实现

public class ThreadTest {

public static void main(String[] args) {

System.out.println("main starting");

Thread01 thread01 = new Thread01();

thread01.start();

}

public static class Thread01 extends Thread {

public void run() {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

}

}

}- 实现Runnable接口实现

public class ThreadTest {

public static void main(String[] args) {

System.out.println("main starting");

Runable01 runable01 = new Runable01();

new Thread(runable01).start();

}

public static class Runable01 implements Runnable {

@Override

public void run() {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

}

}

}- 实现 Callable 接口 + FutureTask实现

public class ThreadTest {

public static void main(String[] args) {

System.out.println("main starting");

FutureTask<Integer> futureTask = new FutureTask<>(new Callable01());

new Thread(futureTask).start();

System.out.println("main ending");

}

public static class Callable01 implements Callable<Integer> {

@Override

public Integer call() throws Exception {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

}

}

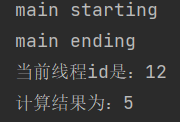

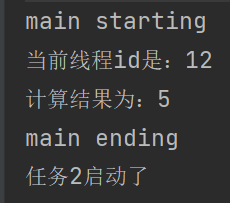

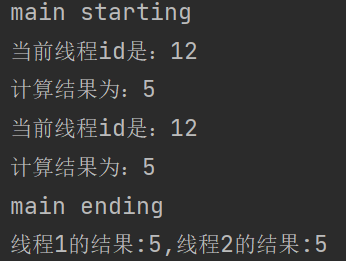

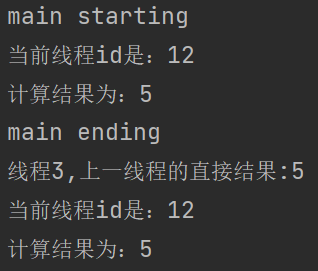

}对于方式1、方式2、方式3的执行结果都是相同的:

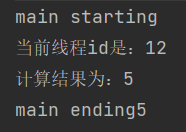

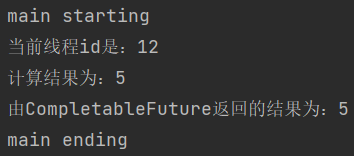

但是对于方式3,因为实现 Callable 接口 + FutureTask能够获得返回值,在获取返回值的时候,其就是一个阻塞式的线程:

public class ThreadTest {

public static void main(String[] args) {

System.out.println("main starting");

FutureTask<Integer> futureTask = new FutureTask<>(new Callable01());

new Thread(futureTask).start();

Integer result = null;

try {

//获取到异步响应结果

result = futureTask.get();

} catch (Exception e) {

e.printStackTrace();

}

System.out.println("main ending");

}

public static class Callable01 implements Callable<Integer> {

@Override

public Integer call() throws Exception {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

}

}

}

对于以上三种创建线程的方式,我们都不采用,而是采用线程池的方式来创建线程

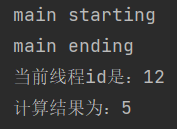

11.13.3线程池实现

采用Executors来创建线程池:

其中submit方法可以传Runable接口和Callable接口

public class ThreadTest {

// 创建线程池

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) {

System.out.println("main starting");

executorService.submit(new Runable01());

System.out.println("main ending");

}

public static class Thread01 extends Thread {

public void run() {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

}

}

public static class Runable01 implements Runnable {

@Override

public void run() {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

}

}

public static class Callable01 implements Callable<Integer> {

@Override

public Integer call() throws Exception {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

}

}

}

11.13.4线程池详解

- 创建线程池的方式

- Executors.newFiexedThreadPool(3)

- new ThreadPoolExecutor(corePoolSize, maximumPoolSize, keepAliveTime, TimeUnit unit, workQueue, threadFactory, handler);

- ThreadPoolExecutor方法的参数

public ThreadPoolExecutor(int corePoolSize,

int maximumPoolSize,

long keepAliveTime,

TimeUnit unit,

BlockingQueue<Runnable> workQueue,

ThreadFactory threadFactory,

RejectedExecutionHandler handler)

- int corePoolSize:核心线程数,线程会一直存在。

- int maximumPoolSize:最大线程数,控制资源。

- long keepAliveTime:存活时间,如果当前线程数量大于corePoolSize指定的线程数,并且已超过存活时间,就会释放除核心线程数之外的空闲线程。

- TimeUnit unit:时间单位

- BlockingQueue

workQueue:阻塞队列。该队列是当核心线程没有空闲时,再来的请求放入队列中先保存任务。 - ThreadFactory threadFactory:线程的创建工厂。

- RejectedExecutionHandler handler:如果队列满了,按照拒绝策略拒绝执行任务。

- ThreadPoolExecutor方法执行流程

- 线程池创建,准备好 core 数量的核心线程,准备接受任务。新的任务进来,用 core 准备好的空闲线程执行。

- core 满了,就将再进来的任务放入阻塞队列中。空闲的 core 就会自己去阻塞队列获取任务执行 。

- 阻塞队列满了,就直接开新线程执行,最大只能开到 max 指定的数量。

- max 都执行好了。Max-core 数量空闲的线程会在 keepAliveTime 指定的时间后自动销毁。最终保持到 core 大小。

- 如果线程数开到了 max 的数量,还有新任务进来,就会使用 reject 指定的拒绝策略进行处理。

- 所有的线程创建都是由指定的 factory 创建的。

面试题:

一个线程池 core 7,max 20 ,queue:50,100 并发进来怎么分配的

7个被核心线程数执行,50个放入阻塞队列,开启新的线程执行,到达最大线程数时执行13个,大于最大线程数的30个被拒绝策略拒绝。

- ThreadPoolExecutor线程池配置

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import java.util.concurrent.Executors;

import java.util.concurrent.LinkedBlockingDeque;

import java.util.concurrent.ThreadPoolExecutor;

import java.util.concurrent.TimeUnit;

/**

* 线程配置

*

* @author Xu Huaiang

* @date 2023/02/02

*/

@Configuration

public class ThreadConfig {

@Bean

public ThreadPoolExecutor threadPoolExecutor(ThreadPoolConfigProperties threadPool) {

return new ThreadPoolExecutor(

threadPool.getCoreSize(),

threadPool.getMaxSize(),

threadPool.getKeepAliveTime(),

TimeUnit.SECONDS,

new LinkedBlockingDeque<>(100000),

Executors.defaultThreadFactory(),

new ThreadPoolExecutor.AbortPolicy()

);

}

}/**

* 线程池配置属性

*

* @author Xu Huaiang

* @date 2023/02/02

*/

@Data

@Component

@ConfigurationProperties(prefix = "gulimall.thread")

public class ThreadPoolConfigProperties {

private Integer coreSize;

private Integer maxSize;

private Integer keepAliveTime;

}#线程池配置

gulimall:

thread:

core-size: 20

max-size: 200

keep-alive-time: 1011.13.5常见的四种线程池

- newCachedThreadPool

创建一个可缓存线程池,如果线程池长度超过处理需要,可灵活回收空闲线程,若无可回收,则新建线程。

- newFixedThreadPool

创建一个定长线程池,可控制线程最大并发数,超出的线程会在队列中等待。

- newScheduledThreadPool

创建一个定长线程池,支持定时及周期性任务执行。

newSingleThreadExecutor

创建一个单线程化的线程池,它只会用唯一的工作线程来执行任务,保证所有任务 按照指定顺序(FIFO, LIFO, 优先级)执行。

11.13.6为什么要使用线程池

- 降低资源的消耗

通过重复利用已经创建好的线程降低线程的创建和销毁带来的损耗

- 提高响应速度

因为线程池中的线程数没有超过线程池的最大上限时,有的线程处于等待分配任务的状态,当任务来时无 需创建新的线程就能执行。

提高线程的可管理性

线程池会根据当前系统特点对池内的线程进行优化处理,减少创建和销毁线程带来 的系统开销。无限的 创建和销毁线程不仅消耗系统资源,还降低系统的稳定性,使 用线程池进行统一分配

11.14CompletableFuture异步编排

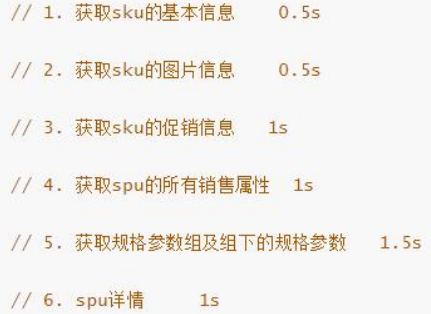

11.14.1业务场景

查询商品详情页的逻辑比较复杂,有些数据还需要远程调用,必然需要花费更多的时间。

假如商品详情页的每个查询,需要如下标注的时间才能完成 那么,用户需要 5.5s 后才能看到商品详情页的内容。很显然是不能接受的。 如果有多个线程同时完成这 6 步操作,也许只需要 1.5s 即可完成响应

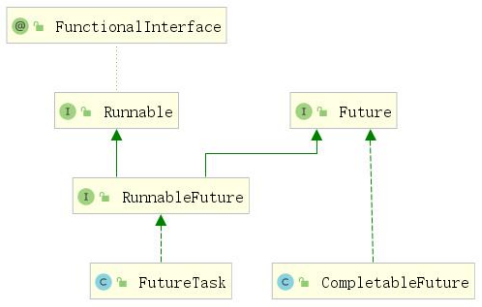

11.14.2CompletableFuture概述

CompletableFuture,提供了非常强大的 Future 的扩展功能,可以帮助我们简化异步编程的复杂性,提供了函数式编程的能力,可以通过回调的方式处理计算结果,并且提供了转换和组合 CompletableFuture 的方法。 CompletableFuture 类实现了 Future 接口,所以你还是可以像以前一样通过get方法阻塞或 者轮询的方式获得结果,但是这种方式不推荐使用。

CompletableFuture 和 FutureTask 同属于 Future 接口的实现类,都可以获取线程的执行结果。

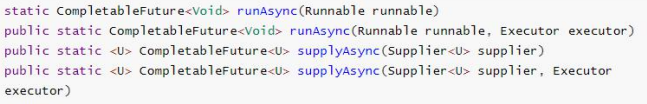

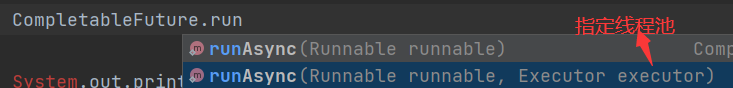

11.14.3创建异步对象

CompletableFuture 提供了四个静态方法来创建一个异步操作。

1、runXxxx 都是没有返回结果的,supplyXxx 都是可以获取返回结果的

2、可以传入自定义的线程池,否则就用默认的线程池;

测试runAsync()

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Void> completableFuture = CompletableFuture.runAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

}, executorService);

System.out.println("main ending");

}

测试supplyAsync()

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Integer> completableFuture = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

}, executorService);

System.out.println("由CompletableFuture返回的结果为:" + completableFuture.get());

System.out.println("main ending");

}

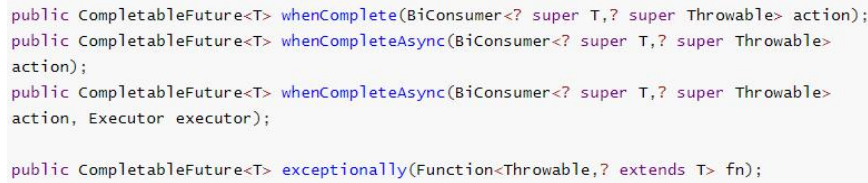

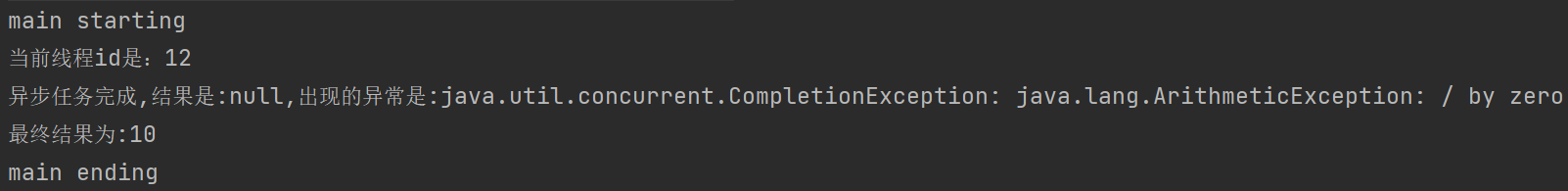

11.14.4计算完成时的回调

whenComplete 可以处理正常和异常的计算结果,

exceptionally 处理异常情况。

whenComplete 和 whenCompleteAsync 的区别:

- whenComplete:是执行当前任务的线程执行继续执行 whenComplete 的任务。

- whenCompleteAsync:是执行把 whenCompleteAsync 这个任务继续提交给线程池 来进行执行。

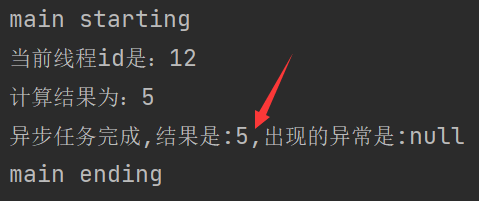

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Integer> completableFuture = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

}, executorService).whenComplete((result,exception) -> {

// 获取到结果和异常信息

System.out.println("异步任务完成,结果是:" + result + ",出现的异常是:" + exception);

}).exceptionally(throwable -> {

// 感知异常,返回结果

return 10;

});

System.out.println("main ending");

}

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Integer> completableFuture = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 0;

System.out.println("计算结果为:" + i);

return i;

}, executorService).whenComplete((result,exception) -> {

// 获取到结果和异常信息

System.out.println("异步任务完成,结果是:" + result + ",出现的异常是:" + exception);

}).exceptionally(throwable -> {

// 感知异常,返回结果

return 10;

});

System.out.println("最终结果为:" + completableFuture.get());

System.out.println("main ending");

}

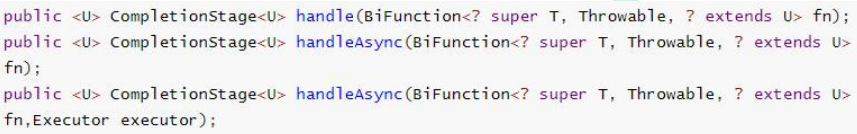

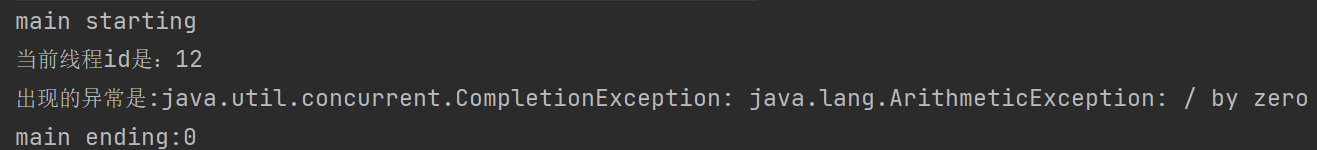

11.14.5Handle方法

和 complete 一样,可对结果做最后的处理(可处理异常),可改变返回值。

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Serializable> completableFuture = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 0;

System.out.println("计算结果为:" + i);

return i;

}, executorService).handle((result, exception) -> {

if (!Objects.isNull(result)) {

return result * 2;

}

if (!Objects.isNull(exception)) {

System.out.println("出现的异常是:" + exception);

}

return 0;

});

System.out.println("main ending:" + completableFuture.get());

}

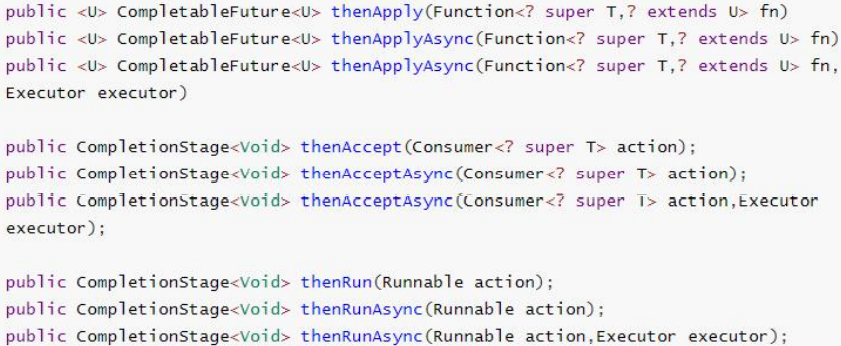

11.14.6线程串行化

线程串行化就是下一个线程需要等待上一个线程的执行结果并进行处理,而将两个或多个线程串行执行。

- thenApply 方法:当一个线程依赖另一个线程时,获取上一个任务返回的结果,并返回当前任务的返回值。

- thenAccept 方法:消费处理结果。接收任务的处理结果,并消费处理,无返回结果。

- thenRun 方法:只要上面的任务执行完成,就开始执行 thenRun,只是处理完任务后,执行 thenRun 的后续操作

- 带有 Async 默认是异步执行的。同之前。

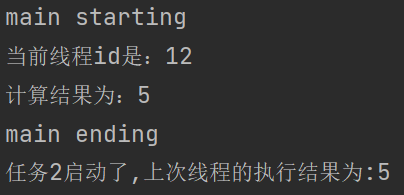

thenRunAsync不能获取执行结果

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Void> completableFuture = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

}, executorService).thenRunAsync(() -> {

System.out.println("任务2启动了");

}, executorService);

System.out.println("main ending");

}

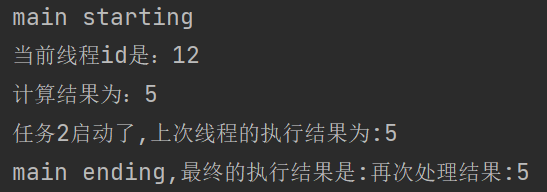

thenAcceptAsync可以获取到上一次的执行结果,但是没有返回值

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Void> completableFuture = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

}, executorService).thenAcceptAsync((result) -> {

System.out.println("任务2启动了,上次线程的执行结果为:" + result);

}, executorService);

System.out.println("main ending");

}

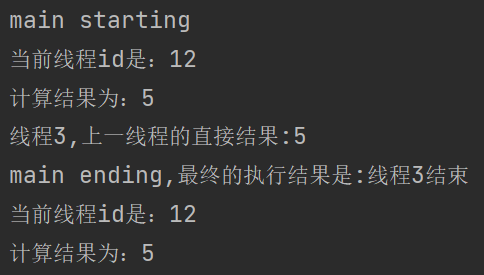

thenApplyAsync可以获取到上一次的执行结果,并且有返回值

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<String> completableFuture = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

}, executorService).thenApplyAsync((result) -> {

System.out.println("任务2启动了,上次线程的执行结果为:" + result);

return "再次处理结果:" + result;

}, executorService);

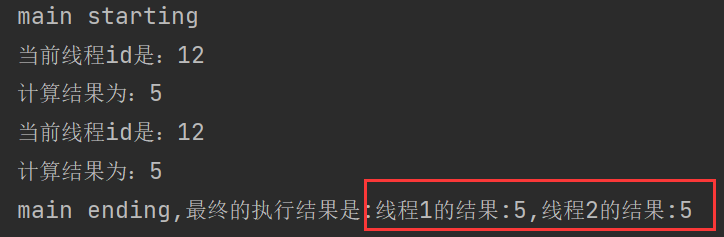

System.out.println("main ending,最终的执行结果是:" + completableFuture.get());

}

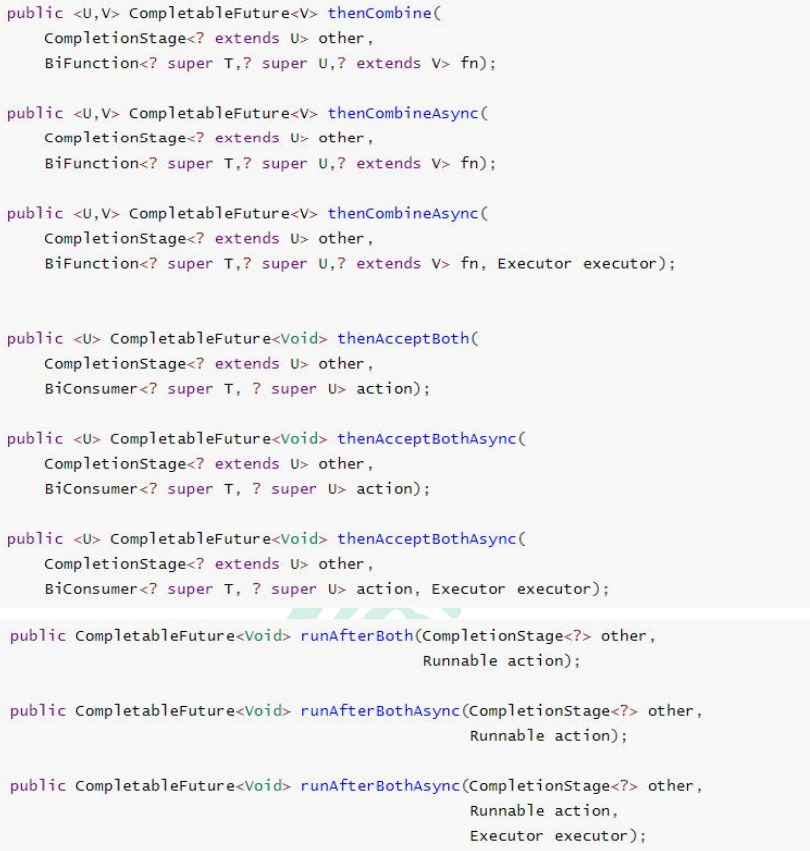

11.14.7两两任务组合—都要完成

- thenCombine:组合两个 future,获取两个 future 的执行结果,并返回当前任务的返回值

- thenAcceptBoth:组合两个 future,获取两个 future 任务的执行结果,然后处理任务,没有返回值。

- runAfterBoth:组合两个 future,不需要获取 future 的结果,只需两个 future 处理完任务后, 处理该任务。

thenAcceptBothAsync(组合两个 future,获取两个 future 任务的返回结果,然后处理任务,没有返回值)

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Object> thread01 = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

});

CompletableFuture<Object> thread02 = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

});

thread01.thenAcceptBothAsync(thread02,(t1,t2) -> {

System.out.println("线程1的结果:" + t1 + ",线程2的结果:" + t2);

},executorService);

System.out.println("main ending");

}

thenCombine:组合两个 future,获取两个 future 的执行结果,并返回当前任务的返回值

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Object> thread01 = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

});

CompletableFuture<Object> thread02 = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

});

CompletableFuture<String> completableFuture = thread01.thenCombineAsync(thread02, (t1, t2) -> {

return "线程1的结果:" + t1 + ",线程2的结果:" + t2;

}, executorService);

System.out.println("main ending,最终的执行结果是:" + completableFuture.get());

}

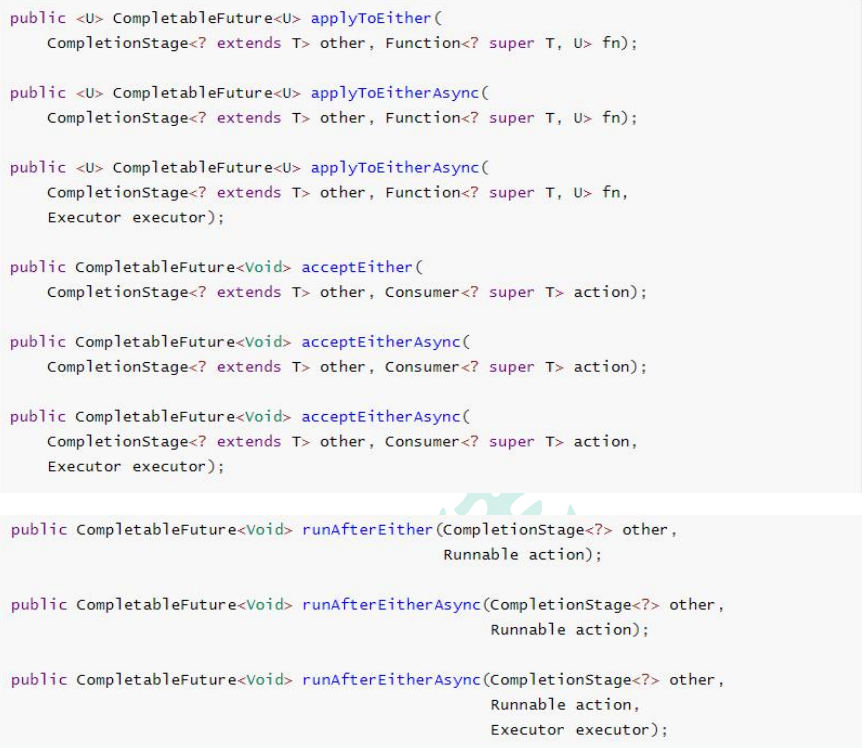

11.14.8两两任务组合—一个完成

runAfterEitherAsync:不获取到上一次的执行结果,并且没有返回值acceptEitherAsync:获取到上一次的执行结果,但是没有返回值applyToEitherAsync:获取到上一次的执行结果,并且有返回值

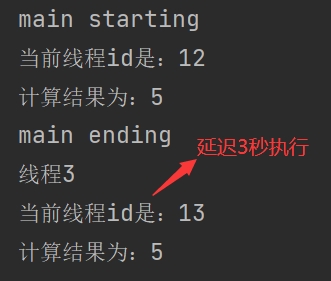

runAfterEitherAsync

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Object> thread01 = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

});

CompletableFuture<Object> thread02 = CompletableFuture.supplyAsync(() -> {

int i = 0;

try {

Thread.sleep(3000);

System.out.println("当前线程id是:" + Thread.currentThread().getId());

i = 10 / 2;

System.out.println("计算结果为:" + i);

} catch (InterruptedException e) {

e.printStackTrace();

}

return i;

});

thread01.runAfterEitherAsync(thread02,() -> {

System.out.println("线程3");

},executorService);

System.out.println("main ending");

}

acceptEitherAsync

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Object> thread01 = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

});

CompletableFuture<Object> thread02 = CompletableFuture.supplyAsync(() -> {

int i = 0;

try {

Thread.sleep(3000);

System.out.println("当前线程id是:" + Thread.currentThread().getId());

i = 10 / 2;

System.out.println("计算结果为:" + i);

} catch (InterruptedException e) {

e.printStackTrace();

}

return i;

});

CompletableFuture<Void> stringCompletableFuture = thread01.acceptEitherAsync(thread02, (result) -> {

System.out.println("线程3,上一线程的直接结果:" + result);

}, executorService);

System.out.println("main ending");

}

applyToEitherAsync

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Object> thread01 = CompletableFuture.supplyAsync(() -> {

System.out.println("当前线程id是:" + Thread.currentThread().getId());

int i = 10 / 2;

System.out.println("计算结果为:" + i);

return i;

});

CompletableFuture<Object> thread02 = CompletableFuture.supplyAsync(() -> {

int i = 0;

try {

Thread.sleep(3000);

System.out.println("当前线程id是:" + Thread.currentThread().getId());

i = 10 / 2;

System.out.println("计算结果为:" + i);

} catch (InterruptedException e) {

e.printStackTrace();

}

return i;

});

CompletableFuture<String> stringCompletableFuture = thread01.applyToEitherAsync(thread02, (result) -> {

System.out.println("线程3,上一线程的直接结果:" + result);

return "线程3结束";

}, executorService);

System.out.println("main ending,最终的执行结果是:" + stringCompletableFuture.get());

}

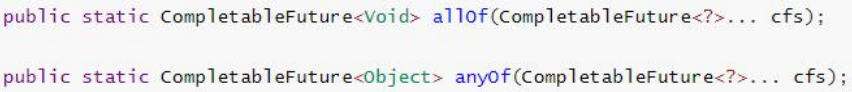

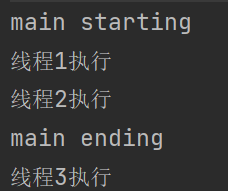

11.14.9多任务组合

allOf:等待所有任务完成

anyOf:只要有一个任务完成

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Void> thread01 = CompletableFuture.runAsync(() -> {

System.out.println("线程1执行");

}, executorService);

CompletableFuture<Void> thread02 = CompletableFuture.runAsync(() -> {

System.out.println("线程2执行");

}, executorService);

CompletableFuture<Void> thread03 = CompletableFuture.runAsync(() -> {

try {

Thread.sleep(3000);

System.out.println("线程3执行");

} catch (InterruptedException e) {

e.printStackTrace();

}

}, executorService);

//未等待线程完成

CompletableFuture.anyOf(thread01, thread02, thread03).get();

System.out.println("main ending");

}

private static ExecutorService executorService = Executors.newFixedThreadPool(10);

public static void main(String[] args) throws ExecutionException, InterruptedException {

System.out.println("main starting");

CompletableFuture<Void> thread01 = CompletableFuture.runAsync(() -> {

System.out.println("线程1执行");

}, executorService);

CompletableFuture<Void> thread02 = CompletableFuture.runAsync(() -> {

System.out.println("线程2执行");

}, executorService);

CompletableFuture<Void> thread03 = CompletableFuture.runAsync(() -> {

try {

Thread.sleep(3000);

System.out.println("线程3执行");

} catch (InterruptedException e) {

e.printStackTrace();

}

}, executorService);

//等待所有线程完成

CompletableFuture.allOf(thread01, thread02, thread03).get();

System.out.println("main ending");

}

11.14.10项目实战

/**

* 根据skuID获取到sku的详细信息

*

* @param skuId sku id

* @return {@link SkuItemVO}

*/

@Override

public SkuItemVO getSkuItemInfo(Long skuId) throws ExecutionException, InterruptedException {

SkuItemVO skuItemVO = new SkuItemVO();

CompletableFuture<SkuInfoEntity> infoFuture = CompletableFuture.supplyAsync(() -> {

// 1.获取到sku的基本信息 pms_sku_info

SkuInfoEntity skuInfo = getById(skuId);

skuItemVO.setSkuInfoEntity(skuInfo);

return skuInfo;

}, threadPoolExecutor);

// 2.以下三个任务都依赖于infoFuture的执行结果

// 3.获取spu的介绍

CompletableFuture<Void> descFuture = infoFuture.thenAcceptAsync((result) -> {

SpuInfoDescEntity spuInfoDescEntity = spuInfoDescService.getById(result.getSpuId());

skuItemVO.setDesp(spuInfoDescEntity);

}, threadPoolExecutor);

// 4.获取spu的基本属性信息

CompletableFuture<Void> baseAttrFuture = infoFuture.thenAcceptAsync((result) -> {

List<SpuItemAttrGroupVO> spuItemAttrGroupVOS = attrGroupService

.getAttrGroupWithAttrsBySpuId(result.getSpuId());

skuItemVO.setGroupVos(spuItemAttrGroupVOS);

}, threadPoolExecutor);

// 5.获取到spu的销售属性组合

CompletableFuture<Void> saleAttrFuture = infoFuture.thenAcceptAsync((result) -> {

List<SkuItemSaleAttrVO> saleAttrVOS =

skuSaleAttrValueService.getSaleAttrBySpuId(result.getSpuId());

skuItemVO.setSaleAttr(saleAttrVOS);

}, threadPoolExecutor);

// 6.获取到sku的图片信息 pms_sku_images

CompletableFuture<Void> imageFuture = CompletableFuture.runAsync(() -> {

List<SkuImagesEntity> skuImageInfo = skuImagesService.getSkuImageInfo(skuId);

skuItemVO.setImages(skuImageInfo);

});

// 等待所有任务完成

CompletableFuture

.allOf(descFuture,baseAttrFuture,saleAttrFuture,imageFuture)

.get();

return skuItemVO;

}11.15MD5&MD5盐值加密

MD5(Message Digest algorithm 5)信息摘要算法

特点:

不可逆

压缩性:任意长度的数据,算出的MD5值长度都是固定的。

容易计算:从原数据计算出MD5值很容易。

抗修改性:对原数据进行任何改动,哪怕只修改1个字节,所得到的MD5值都有很大区别。

强抗碰撞:想找到两个不同的数据,使它们具有相同的MD5值,是非常困难的。

MD5加盐:

- 通过生成随机数与MD5生成字符串进行组合

- 数据库同时存储MD5值与salt值。验证正确性时使用salt进行MD5即可

对加过的盐值的密码进行MD5加密,将加密后的密码和盐值放入到数据库。即使破解数据库,也不能根据加密后的密码穷举出原密码,这是因为MD5的抗修改性。

11.16社交登录

11.16.1OAuth2.0

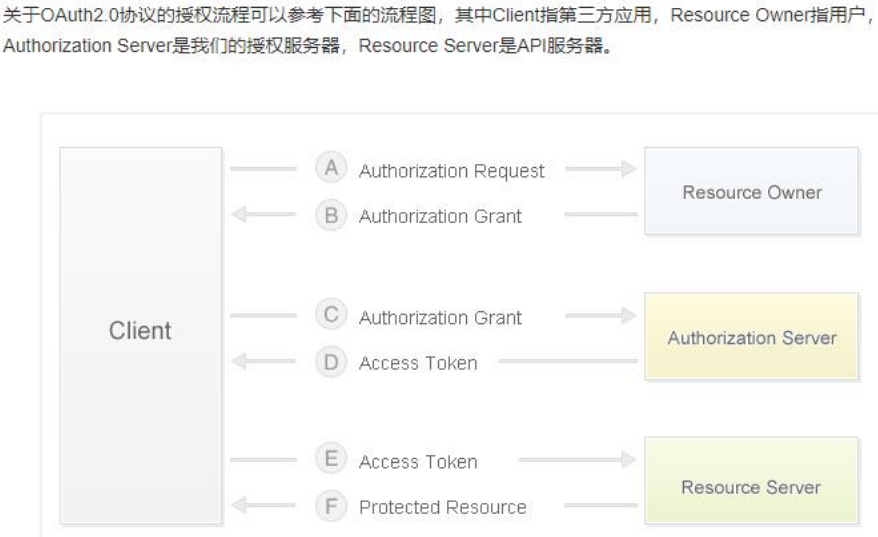

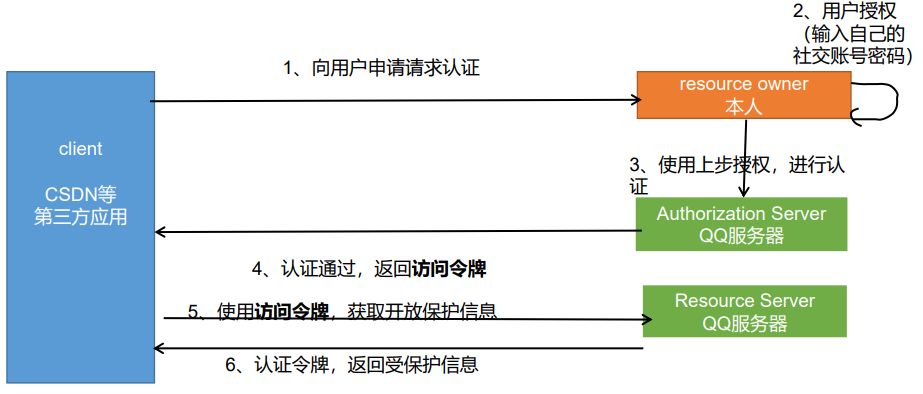

- OAuth: **OAuth(开放授权)是一个开放标准**,允许用户授权第三方网站访问他们存储在另外的服务提供者上的信息,而不需要将用户名和密码提供给第三方网站或分享他们数据的所有内容。

- OAuth2.0:对于用户相关的 OpenAPI(例如获取用户信息,动态同步,照片,日志,分 享等),为了保护用户数据的安全和隐私,第三方网站访问用户数据前都需要显式的向用户征求授权。

- 官方版流程:

步骤如下:

(A)用户打开客户端以后,客户端要求用户给予授权。

(B)用户同意给予客户端授权。

(C)客户端使用上一步获得的授权(code码),向认证服务器申请令牌(access_token)。

(D)认证服务器对客户端进行认证以后,确认无误,同意发放令牌。

(E)客户端使用令牌,向资源服务器申请获取资源。

(F)资源服务器确认令牌无误,同意向客户端开放资源。

11.16.2实现gitee登录

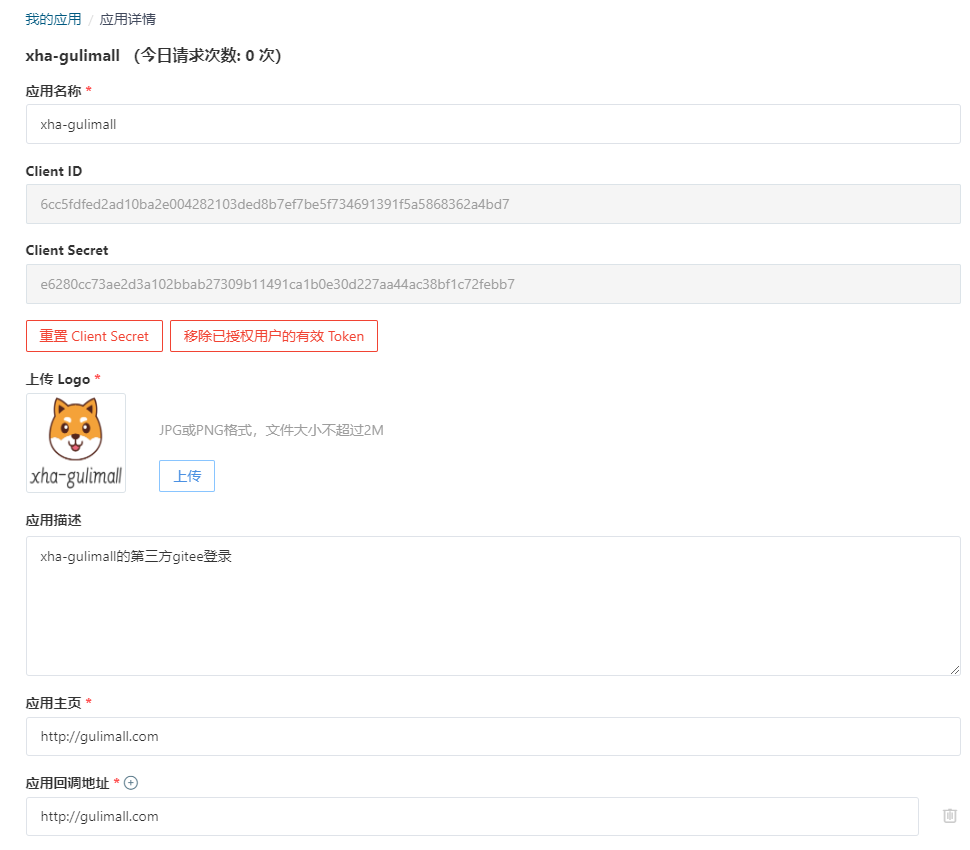

11.16.3.1创建应用

- 选择第三方应用

- 创建应用

11.16.3.2查看OAuth文档说明

授权码模式

应用通过 浏览器 或 Webview 将用户引导到码云三方认证页面上( GET请求 )

https://gitee.com/oauth/authorize?client_id={client_id}&redirect_uri={redirect_uri}&response_type=code用户对应用进行授权

注意: 如果之前已经授权过的需要跳过授权页面,需要在上面第一步的 URL 加上 scope 参数,且 scope 的值需要和用户上次授权的勾选的一致。如用户在上次授权了user_info、projects以及pull_requests。则步骤A 中 GET 请求应为:https://gitee.com/oauth/authorize?client_id={client_id}&redirect_uri={redirect_uri}&response_type=code&scope=user_info%20projects%20pull_requests码云认证服务器通过回调地址{redirect_uri}将 用户授权码 传递给 应用服务器 或者直接在 Webview 中跳转到携带 用户授权码的回调地址上,Webview 直接获取code即可({redirect_uri}?code=abc&state=xyz)

应用服务器 或 Webview 使用 access_token API 向 码云认证服务器发送post请求传入 用户授权码 以及 回调地址( POST请求 )**注:请求过程建议将 client_secret 放在 Body 中传值,以保证数据安全。

https://gitee.com/oauth/token?grant_type=authorization_code&code={code}&client_id={client_id}&redirect_uri={redirect_uri}&client_secret={client_secret}码云认证服务器返回 access_token

应用通过 access_token 访问 Open API 使用用户数据。当 access_token 过期后(有效期为一天),你可以通过以下 refresh_token 方式重新获取 access_token( POST请求 )

https://gitee.com/oauth/token?grant_type=refresh_token&refresh_token={refresh_token}注意:如果获取 access_token 返回 403,可能是没有设置User-Agent的原因。

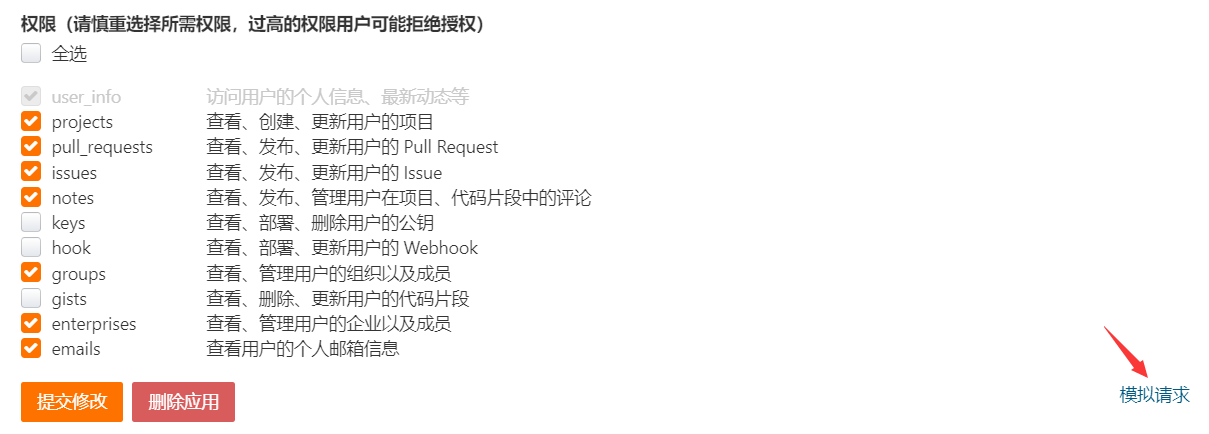

11.16.3.3步骤演示

- 登录账号,访问授权页面,获取到code码

这里采用gitee应用中的模拟请求的方式:

- 同意授权后,页面跳转到应用回调地址,回调地址后携带code

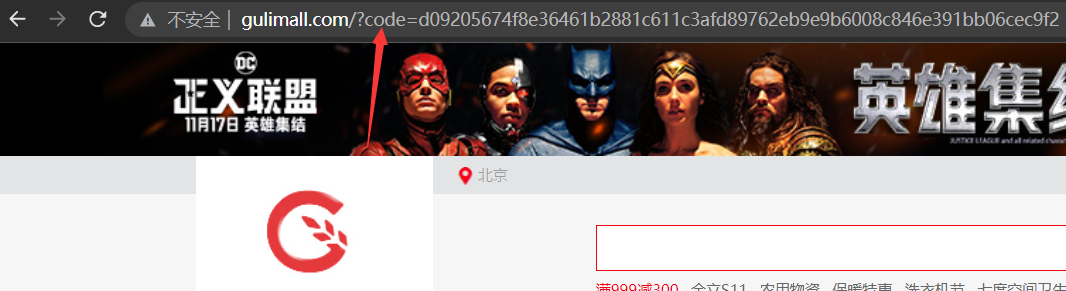

- 发送post请求,携带

code、client_id、redirect_url、client_secret,获取到access_token

==code码只能使用一次,使用一次后失效。而获取到的access_token的有效期为一天,当然也可以通过新的code码来获取新的access_token。==

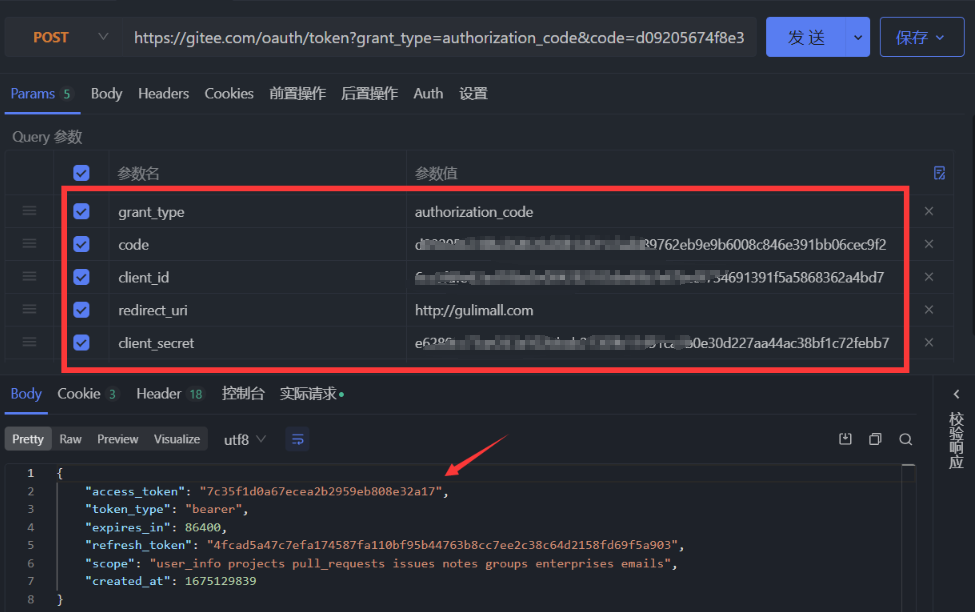

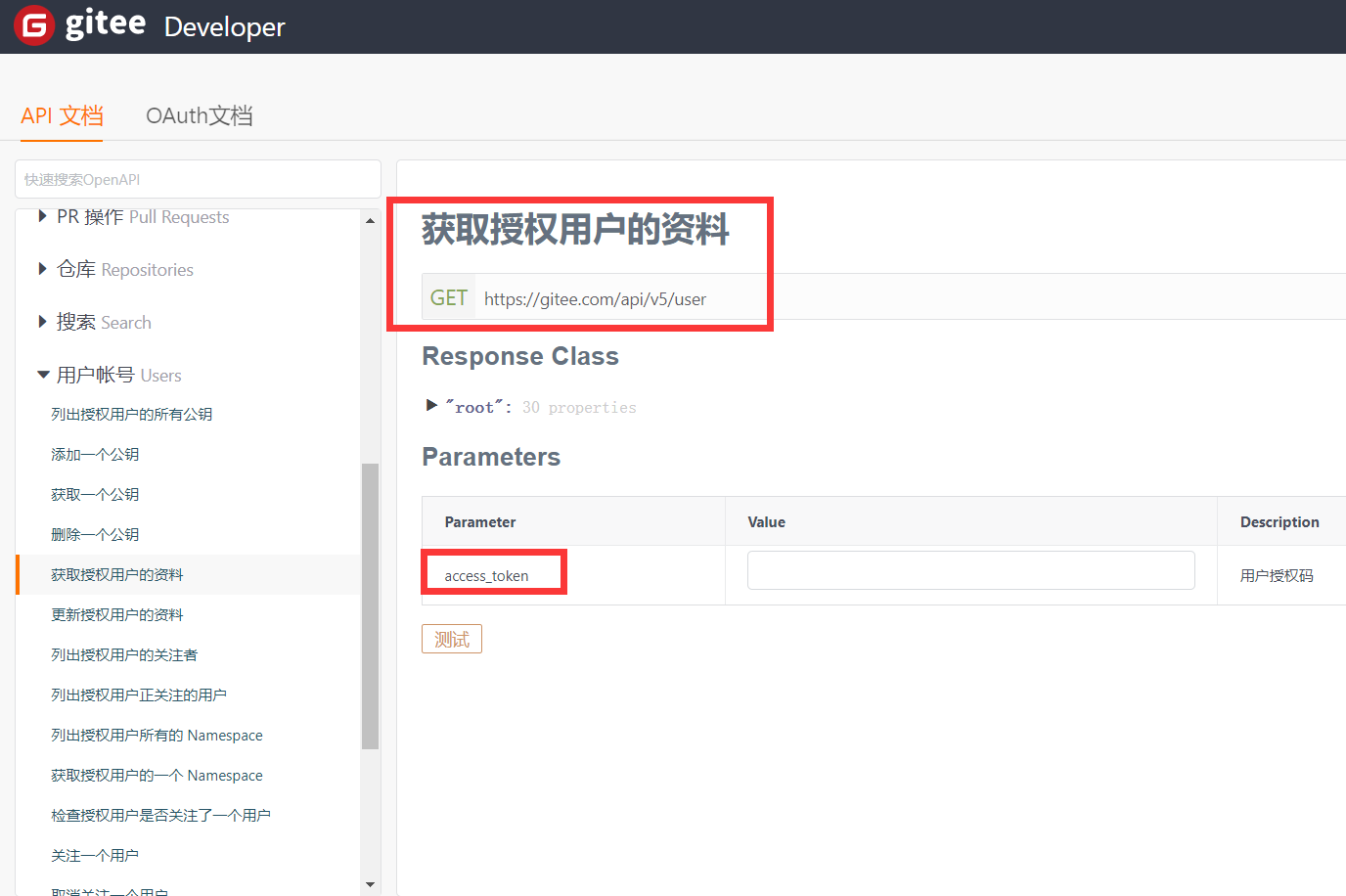

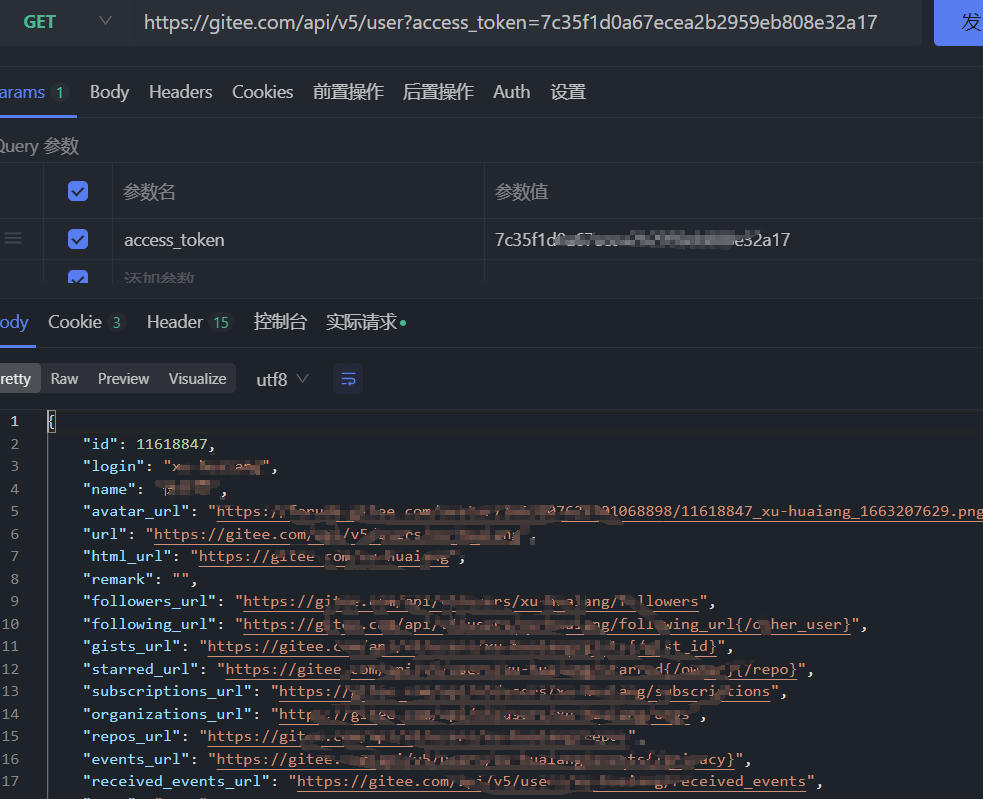

- 根据gitee的API文档找到对应请求,携带token获取到数据

11.16.3.4具体业务实现

- gulimall-auth-server模块

在gulimall-auth-server模块当中,

首先获取到用户授权后得到的

code,然后再使用code获取到

access_token,最后再调用

gulimall-member服务完成用户注册/登录。

/**

* gitee oauth

*

* @param code 代码

* @return {@link String}

*/

@Override

public String giteeOAuth(String code) {

Map<String, String> querys = new HashMap<>();

querys.put("grant_type", grant_type);

querys.put("code", code);

querys.put("client_id", client_id);

querys.put("redirect_uri", redirect_uri);

querys.put("client_secret", client_secret);

try {

// 1.根据code码获取access_toekn

HttpResponse response = HttpUtils.doPost(

host, path, "post", new HashMap<String, String>(), querys, new HashMap<String, String>());

if (response.getStatusLine().getStatusCode() == HttpCode.STATUS_NORMAL.getCode()) {

// 2.获取到了access_token

// 3.通过EntityUtils将HttpEntity对象转为json数据

String httpEntityStr = EntityUtils.toString(response.getEntity());

// 4.将json数据转为GiteeResponseEntity对象

GiteeResponseTO giteeResponseTO = JSONUtil.toBean(httpEntityStr, GiteeResponseTO.class);

// 5.调用member服务,用户注册或者登录

R oauthResult = memberFeign.userOAuthGiteeLogin(giteeResponseTO);

if (oauthResult.getCode() == 0){

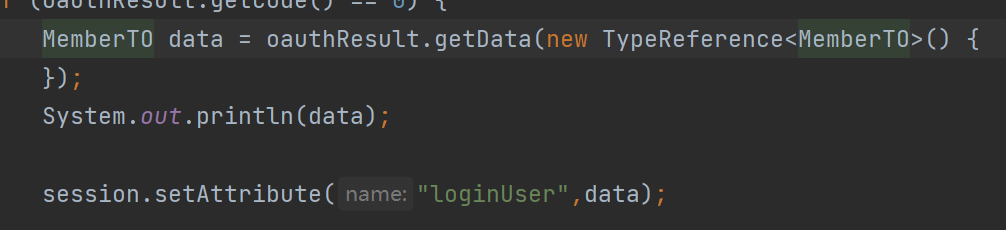

MemberTO data = oauthResult.getData(new TypeReference<MemberTO>() {

});

System.out.println(data);

// TODO 使用SpringSession处理数据共享问题

}else{

// 第三方认证登录失败

return "redirect:http://auth.gulimall.com/login.html";

}

} else {

return "redirect:http://auth.gulimall.com/login.html";

}

} catch (Exception e) {

e.printStackTrace();

}

return "redirect:http://gulimall.com";

}- gulimall-member模块

在gulimall-member模块当中

- 首先根据

access_toekn获取到用户的详细信息 - 根据gitee所提供的id判断当前用户是否存在

- 如果不存在就注册,将

access_token存入缓存,设置过期时间(默认为86400,即24小时) - 如果存在就更新缓存中的

access_token的过期时间

/**

* Gitee第三方用户登录

*

* @return {@link R}

*/

@Override

public MemberEntity userOAuthGiteeLogin(GiteeResponseTO giteeResponseTO) {

// 1.判断当前第三方用户是否已经注册过

// 1.1根据token查询用户id

Map<String, String> querys = new HashMap<>();

querys.put("access_token", giteeResponseTO.getAccess_token());

MemberEntity member = null;

try {

HttpResponse response = HttpUtils.doGet(host, path, "get", new HashMap<String, String>(), querys);

String userInfo = EntityUtils.toString(response.getEntity());

// 将用户信息转为GiteeUserInfo对象

GiteeUserInfo giteeUserInfo = JSONUtil.toBean(userInfo, GiteeUserInfo.class);

// 根据gitee提供的唯一id查询当前用户是否存在

LambdaQueryWrapper<MemberEntity> queryWrapper = new LambdaQueryWrapper<>();

queryWrapper.eq(MemberEntity::getThirdId, giteeUserInfo.getId());

member = getOne(queryWrapper);

if (Objects.isNull(member)) {

// 当前用户为首次登录,先注册

MemberEntity memberEntity = new MemberEntity();

memberEntity.setThirdId(String.valueOf(giteeUserInfo.getId()))

.setSourceType(UserOriginName.GITEE)

.setLevelId(MemberEnums.GENERAL_MEMBER.getLevel())

.setUsername(giteeUserInfo.getLogin())

.setEmail(giteeUserInfo.getEmail())

.setHeader(giteeUserInfo.getAvatar_url());

save(memberEntity);

// 将当前的access_token和expire_in存入缓存

stringRedisTemplate.opsForValue().set(

CacheConstants.GITEE_LOGIN_ACCESS_TOKEN_CACHE + memberEntity.getThirdId(),

giteeResponseTO.getAccess_token(),

NumberConstants.ACCESS_TOKEN_EXPIRE_TIME,

TimeUnit.SECONDS);

member = memberEntity;

}else{

// 重制当前用户对应缓存中的access_token的超时时间

stringRedisTemplate.opsForValue().set(

CacheConstants.GITEE_LOGIN_ACCESS_TOKEN_CACHE + member.getThirdId(),

giteeResponseTO.getAccess_token(),

NumberConstants.ACCESS_TOKEN_EXPIRE_TIME,

TimeUnit.SECONDS);

}

} catch (Exception e) {

e.printStackTrace();

}

return member;

}11.17SpringSession

11.17.1四大域对象

- ApplicationContext

- PageContext

- Request

- Session

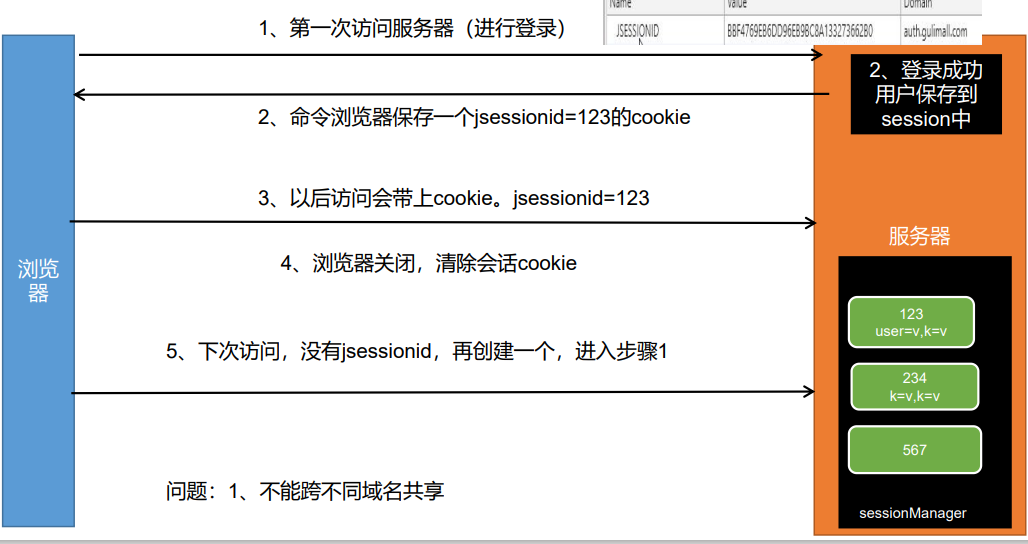

11.17.2Session工作原理

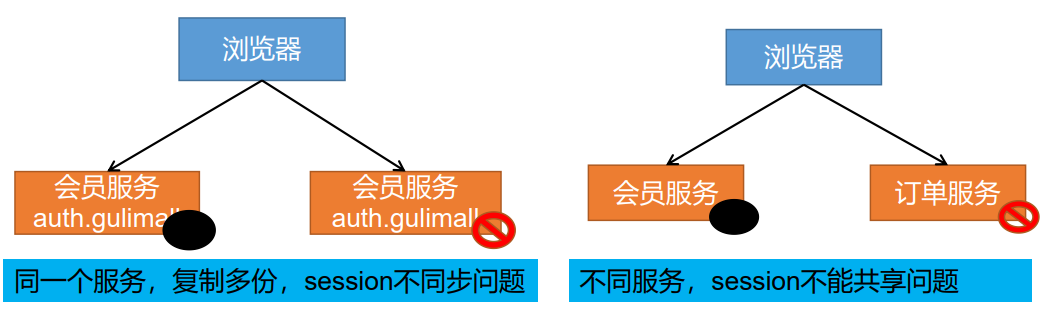

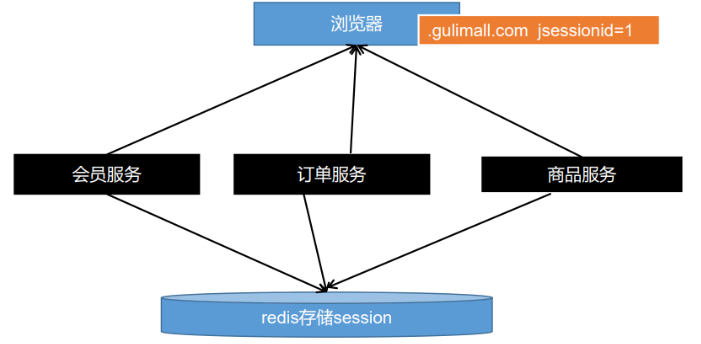

11.17.3Session共享问题—分布式下session共享问题

11.17.4Session共享问题的解决方案

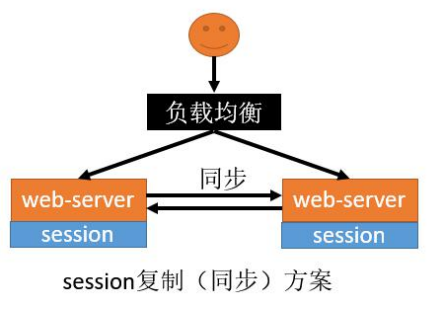

11.17.4.1Session复制

优点

- web-server(Tomcat)原生支持,只需要修改配置 文件

缺点

- session同步需要数据传输,占用大量网络带宽,降 低了服务器群的业务处理能力

- 任意一台web-server保存的数据都是所有web- server的session总和,受到内存限制无法水平扩展更多的web-server

- 大型分布式集群情况下,由于所有web-server都全量保存数据,所以此方案不可取。

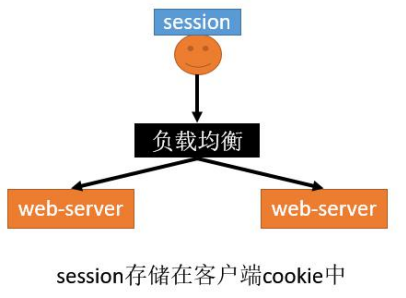

11.17.4.2客户端存储

- 优点

- 服务器不需存储session,用户保存自己的 session信息到cookie中。节省服务端资源。

- 缺点

- 每次http请求,携带用户在cookie中的完整信息, 浪费网络带宽

- session数据放在cookie中,cookie有长度限制 4K,不能保存大量信息

- session数据放在cookie中,存在泄漏、篡改、 窃取等安全隐患。

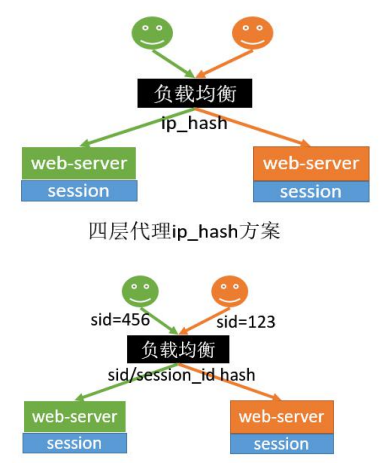

11.17.4.3Hash一致性

优点

只需要改nginx配置,不需要修改应用代码

负载均衡,只要hash属性的值分布是均匀的,多台 web-server的负载是均衡的

可以支持web-server水平扩展(session同步法是不行 的,受内存限制)

缺点

- session还是存在web-server中的,所以web-server重 启可能导致部分session丢失,影响业务,如部分用户需要重新登录

- 如果web-server水平扩展,rehash后session重新分布, 也会有一部分用户路由不到正确的session

- 但是以上缺点问题也不是很大,因为session本来都是有有 效期的。所以这两种反向代理的方式可以使用

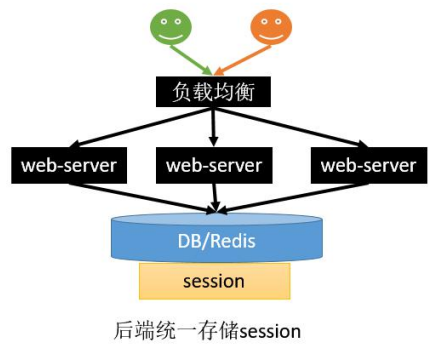

11.17.4.4统一存储

- 优点

- 没有安全隐患

- 可以水平扩展,数据库/缓存水平切分即可

- web-server重启或者扩容都不会有 session丢失

- 缺点

- 增加了一次网络调用,并且需要修改应用代码;如将所有的getSession方法替换为从Redis查数据的方式。redis获取数据比内存慢很多。

11.17.4.5子域Session共享

jsessionid这个cookie默认是当前系统域名的。当我们分拆服务,不同域名部署的时候,我们可以使用 如下解决方案;

11.17.5SpringSession整合

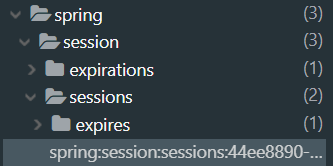

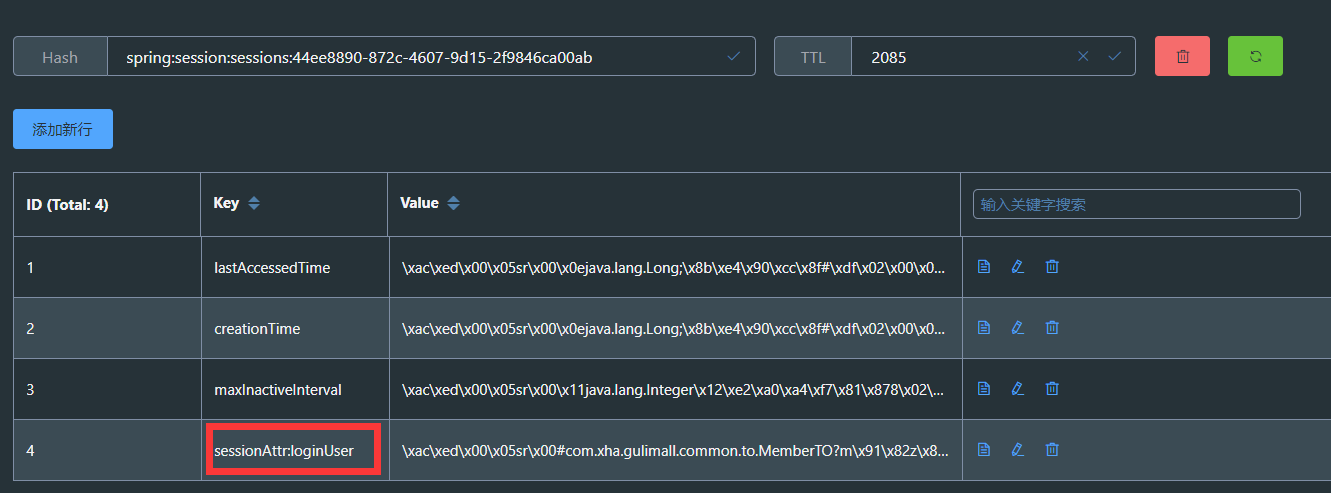

111.17.5.1将数据存入redis

- 引入对应的依赖

<dependency>

<groupId>org.springframework.session</groupId>

<artifactId>spring-session-data-redis</artifactId>

<version>2.3.3.RELEASE</version>

</dependency>- 添加spring session对应的缓存配置、session的过期时间以及redis的连接信息

server:

servlet:

session:

timeout: 30m

spring:

session:

store-type: redis

redis:

host: 192.168.26.160

port: 6379 在主类上添加

@EnableRedisHttpSession注解开始SpringSession创建session对象,向session域中存放数据

注意:存入的对应不应该使用jdk默认的序列化机制ObjectOutPutStream,而是要对应的实体类实现Serializable序列化接口

- 查看缓存数据

11.17.5.2实现Cookie的序列化器和Redis的序列化器

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.data.redis.serializer.GenericJackson2JsonRedisSerializer;

import org.springframework.data.redis.serializer.RedisSerializer;

import org.springframework.session.web.http.CookieSerializer;

import org.springframework.session.web.http.DefaultCookieSerializer;

@Configuration

public class SpringSessionConfig {

//Cookie的序列化器

@Bean

public CookieSerializer cookieSerializer(){

DefaultCookieSerializer cookieSerializer = new DefaultCookieSerializer();

// 设置Session的作用域,放大作用域到父域

cookieSerializer.setDomainName("gulimall.com");

return cookieSerializer;

}

//Redis的序列化器

@Bean

public RedisSerializer<Object> springSessionDefaultRedisSerializer(){

return new GenericJackson2JsonRedisSerializer();

}

}测试结果:

11.18单点登录

11.18.1单点登录概述

单点登录的英文名叫做:Single Sign On(简称SSO),==指在同一帐号平台下的多个应用系统中,用户只需登录一次,即可访问所有相互信任的系统。简而言之,多个系统,统一登陆。==

为什么需要做单点登录系统呢?在一些互联网公司中,公司旗下可能会有多个子系统,每个登陆实现统一管理,多个账户信息统一管理 SSO单点登陆认证授权系统。比如阿里系的淘宝和天猫,显而易见这是两个系统,但是在使用过程中,只要你登录了淘宝,同时也意味着登录了天猫,如果每个子系统都需要登录认证,用户早就疯了,所以我们要解决的问题就是,用户只需要登录一次就可以访问所有相互信任的应用系统。

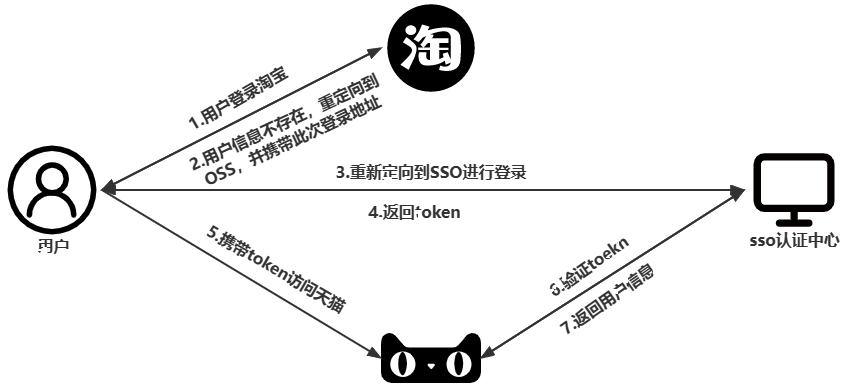

11.18.2单点登录原理

==sso需要一个独立的认证中心==,所有子系统都通过认证中心的登录入口进行登录,==登录时带上自己的地址,子系统只接受认证中心的授权,授权通过令牌(token)实现,sso认证中心验证用户的用户名密码正确,创建全局会话和token,token作为参数发送给各个子系统,子系统拿到token,即得到了授权==,可以借此创建局部会话,局部会话登录方式与单系统的登录方式相同。

11.18.3单点登录的实现方案

Cookies,Session同步,分布式Session,目前的大型网站都是采用分布式Session的方式。

11.18.4单点登录框架—xxl-sso

11.18.4.1框架说明

gitee官网:https://gitee.com/xuxueli0323/xxl-sso?_from=gitee_search

XXL-SSO 是一个分布式单点登录框架。只需要登录一次就可以访问所有相互信任的应用系统。 拥有”轻量级、分布式、跨域、Cookie+Token均支持、Web+APP均支持”等特性。现已开放源代码,开箱即用。

11.18.4.2xxl-sso框架的使用

- 在官网克隆项目到本地

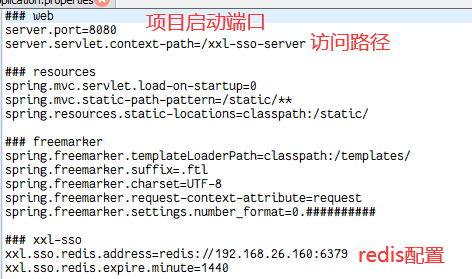

- 修改服务端配置文件信息

- 修改客户端的配置文件

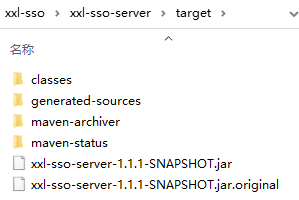

- 在项目根目录下使用maven命令打包

mvn clean package -Dmaven.skip.test=true

- 启动服务端:在xxl-sso目录下启动jar包

java -jar xxl-sso-server-1.1.1-SNAPSHOT.jar

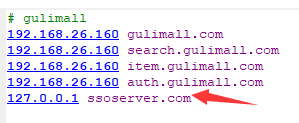

- 将域名

ssoserver.com映射到本地

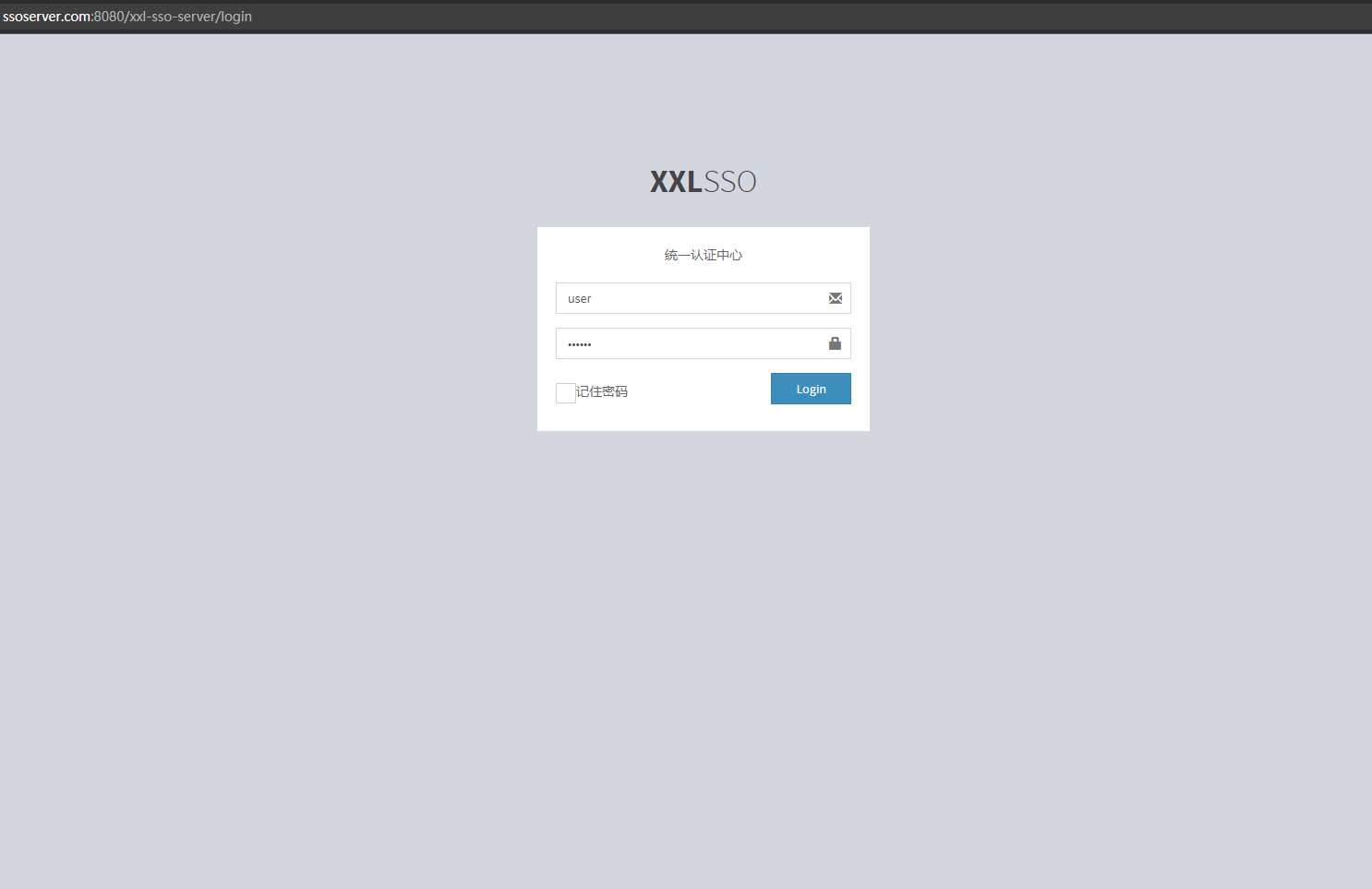

- 访问xxl-sso项目服务端地址

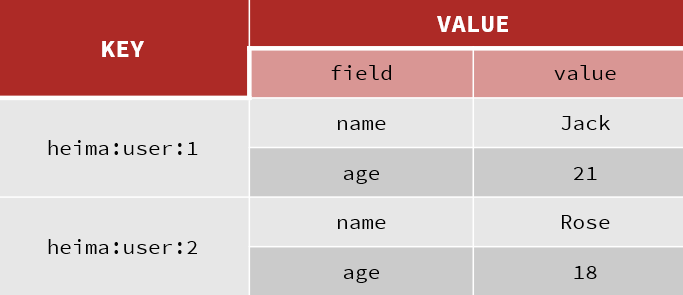

11.19购物车数据结构(Hash)

Redis hash 是一个键值对集合。

==Redis hash是一个string类型的field和value的映射表,hash特别适合用于存储对象。==

类似Java里面的Map<String,Object>

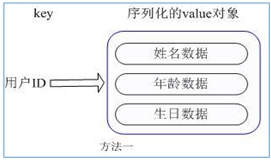

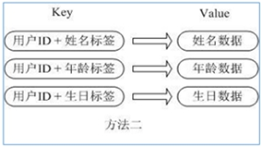

用户ID为查找的key,存储的value用户对象包含姓名,年龄,生日等信息,如果用普通的key/value结构来存储

主要有以下2种存储方式:

方式1:

每次修改用户的某个属性需要先反序列化改好后再序列化回去。开销较大。

方式2:

用户ID数据冗余

采用Hash的方式进行实现:

通过 key(用户ID) + field(属性标签) 就可以操作对应属性数据了,既不需要重复存储数据,也不会带来序列化和并发修改控制的问题

所以最终购物车的数据结构如下:

Map<String k1,Map<String k2,CartItemInfo>>

k1:标识每一个用户的购物车

k2:购物项的商品sku_id

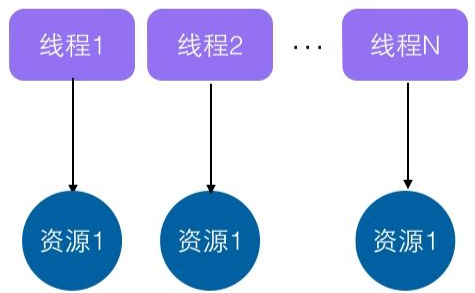

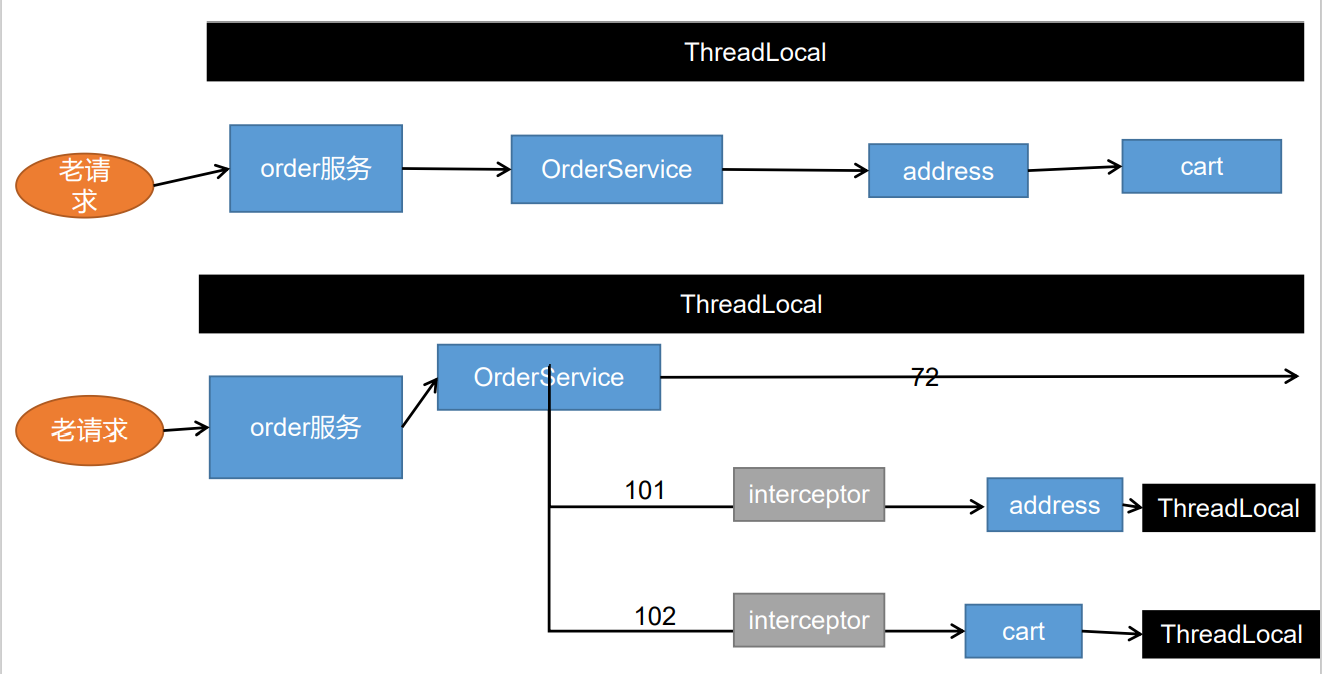

11.20ThreadLocal

11.20.1ThreadLocal概述

**一个ThreadLocal在一个线程中是共享数据的,在不同线程之间又是隔离的**(每个线程都只能看到自己线程的值)。如下图:

每个Thread对象都有一个ThreadLocalMap,当创建一个ThreadLocal的时候,就会将该ThreadLocal对象添加到该Map中,其中键就是ThreadLocal,值可以是任意类型。

11.20.2ThreadLocal的作用

==实现线程范围内的局部变量,即ThreadLocal在一个线程中是共享的,在不同线程之间是隔离的。==

11.20.3ThreadLocal的原理

==ThreadLocal存入值时使用当前ThreadLocal实例作为key(并不是以当前线程对象作为key),存入当前线程对象中的Map中去。==

11.20.4具体实现

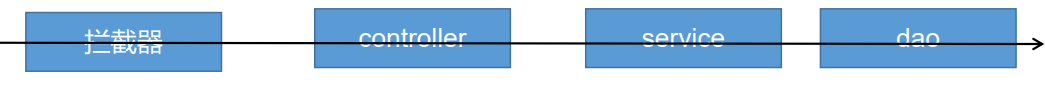

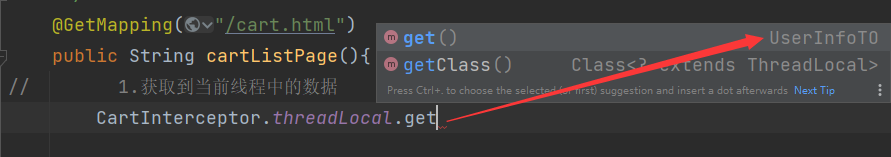

业务实现逻辑:

在用户访问购物车页面时,首先经过拦截器,在拦截器中判断当前是否有登录的用户,并将信息封装为

UserInfoTO对象。在拦截器中创建

ThreadLocal,将封装好的UserInfoTo对象放入当前线程,以便供Controller获取。

11.21SpringBoot整合RabbitMQ

11.21.1添加依赖和配置

- 添加对应的依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-amqp</artifactId>

<version>${amqp-version}</version>

</dependency>- 在配置文件当中配置rabbitmq

spring:

rabbitmq:

host: 192.168.26.160

port: 5672

username: guest

password: guest- 在主类上添加

@EnableRabbit注解,开启RabbitMQ的相关功能(监听消息)

11.21.2MQ的开发流程

自动配置

- RabbitAutoConfiguration

- 自动配置了连接工厂

- RabbitProperties封装RabbitMQ的配置

- RabbitTemplate用于MQ的发送和接收消息

- @EnableRabbit + @RabbitListener 结合实现监听消息队列的内容

- AmqpAdmin:RabbitMQ系统管理功能

- AmqpAdmin:创建和删除Queue, Exchange, Binding(不仅可以通过配置类的方式创建queue、exchange、binding,也可以通过AMqpAdmin类来创建)

参数介绍:

1、name: 队列的名称;

2、actualName: 队列的真实名称,默认用name参数,如果name为空,则根据规则生成一个;

3、durable: 是否持久化;

4、exclusive: 是否独享、排外的;

5、autoDelete: 是否自动删除;

6、目前存在一个问题那就是将数据存在Mq中的数据为String的时候是可以正常的进行获取,同时也可以再Mq中正常的显示,不过如果是对象就需要进行序列化,存放后可以正常的进行显示数据,不过后端获取数据后没有办法进行对应的监听反序列化为对象,需要自己进行配置,或者将对象先进行转Json字符串,然后进行获取的时候进行先Json转对象操作。

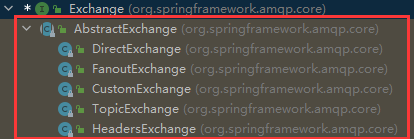

11.21.3Exchange接口

Exchange接口时创建交换机对象的接口,其实现类就就是创建对应的交换机:

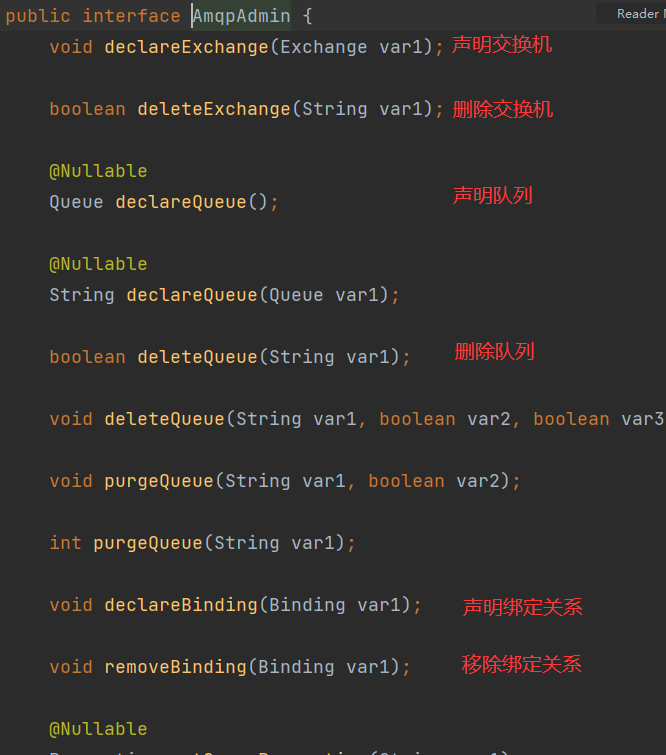

11.21.4AmqpAdmin接口

11.21.3.1AmqpAdmin概述

==AmqpAdmin是一个接口。是Rabbitmq的系统管理功能,能够创建、删除Queue, Exchange, Binding==

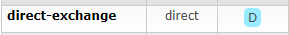

11.21.3.2声明交换机

DirectExchange参数说明:

String name:交换机名称

boolean durable:是否持久化

boolean autoDelete:是否自动删除

Map<String, Object> arguments:参数集合

/**

* 创建交换机

*/

@Test

void createExchange() {

DirectExchange directExchange = new DirectExchange("direct-exchange",true,false);

amqpAdmin.declareExchange(directExchange);

}

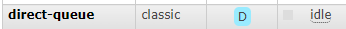

11.21.3.3声明队列

Queue参数说明:

String name:队列名称

boolean durable:是否持久化

boolean exclusive:是否排它(true表示当前队列是一个排他队列,只能被一条被声明的连接使用,其他队列不可用。)

boolean autoDelete:是否自动删除

@Nullable Map<String, Object> arguments:参数列表

/**

* 创建队列

*/

@Test

void createQueue(){

Queue queue = new Queue("direct-queue",true,false,false);

amqpAdmin.declareQueue(queue);

}

11.21.3.4创建绑定

Binding参数说明:

String destination:目的地(队列/交换机 的名称)

Binding.DestinationType destinationType:目的地类型(可以是交换机、队列)

String exchange:交换机名称

String routingKey:路由键

@Nullable Map<String, Object> arguments:参数列表

/**

* 创建绑定

*/

@Test

void createBinding() {

Binding binding = new Binding("direct-queue",

Binding.DestinationType.QUEUE,

"direct-exchange", "hello.rabbitmq",

null);

amqpAdmin.declareBinding(binding);

}

11.21.5RabbitTemplate

11.21.5.1RabbitTemplate简介

RabbitTemplate:==消息模板。这是spring整合rabbit提供的消息模板。是进行发送和接受消息的关键类。==

11.21.5.2convertAndSend方法

convertAndSend()和Send()的区别在于其可以发送任意类型的数据,而Send()只能接受Message类型的数据。

convertAndSend方法参数说明:

String exchange:交换机

String routingKey:路由键

Object message:发送的消息对象

MessagePostProcessor messagePostProcessor:信息处理器

@Nullable CorrelationData correlationData:相关性数据

/**

* 发送消息

*/

@Test

void sendMessage() {

rabbitTemplate.convertAndSend("direct-exchange",

"hello.rabbitmq",

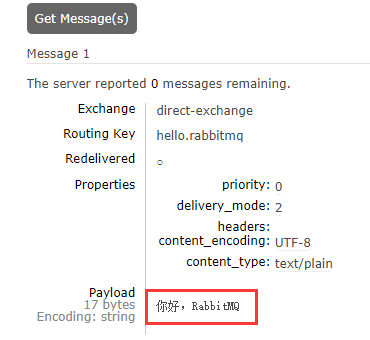

"你好,RabbitMQ");

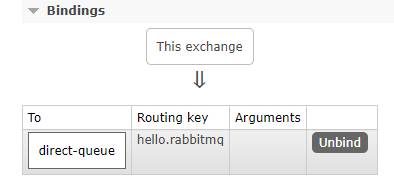

}由交换机通过routingKey向对应的队列中发送消息:

11.21.6MessageCoverter接口

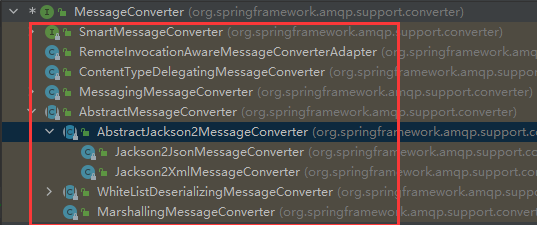

在通过RabbitTemplate发送消息的时候,消息可以是实体类对象,但是需要将对象进行序列化。但是默认的是使用JDK的默认序列方式,可以通过MessageCoverter对消息对象进行序列化。

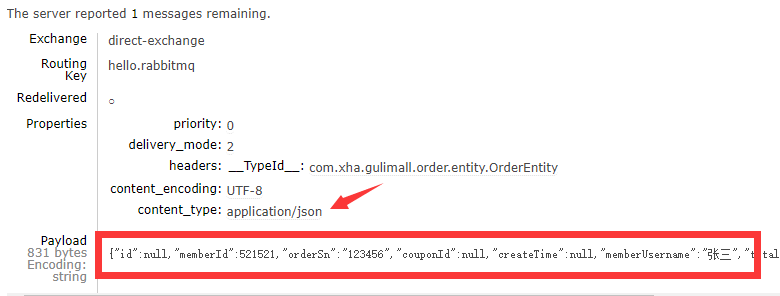

MessageCoverter接口的实现类有如下:

可以采用MessageConverter的实现类进行序列化和反序列化

@Configuration

public class RabbitMQMessageConfig {

@Bean

public MessageConverter messageConverter(){

return new Jackson2JsonMessageConverter();

}

}/**

* 发送消息

*/

@Test

void sendMessage() {

OrderEntity orderEntity = new OrderEntity();

orderEntity.setMemberId(521521L);

orderEntity.setOrderSn("123456");

orderEntity.setMemberUsername("张三");

rabbitTemplate.convertAndSend("direct-exchange",

"hello.rabbitmq",

orderEntity);

}消息类型为JSON类型

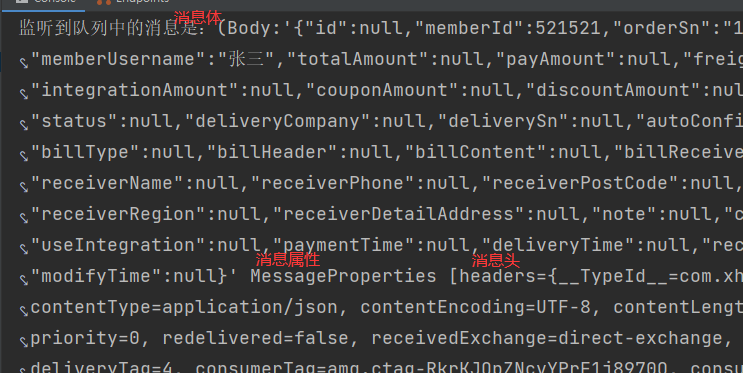

11.21.7@RabbitListener注解

==@RabbitListener注解标注在类上或方法上,作用是监听指定的队列。==其实现需要有@EnableRabbit注解提供的功能支持。

在方法上添加@RabbitListener注解,监听direct-queue队列当中的消息。

/**

* 接收消息

*/

@RabbitListener(queues = {"direct-queue"})

public void receiveMessage(Object message, OrderEntity orderEntity, Channel channel){

System.out.println("监听到队列中的消息是:" + message + "消息体对象:" + orderEntity);

} 在11.21.6章节的测试中,再次向direct-queue队列当中发送消息的时候,@RabbitListener会立即监听到队列中的消息。默认的消息类型是:class org.springframework.amqp.core.Message

当前方法中的参数说明:

- Object message:表示接收到的消息,消息类型为

class org.springframework.amqp.core.Message- OrderEntity orderEntity:如果是对象类型的消息体,则可以直接使用对象类型进行接收。

- Channel channel:当前信道

消息对象

对象类型:

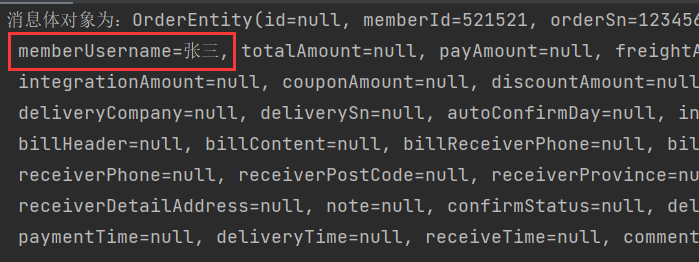

11.21.8@RabbitHandler注解

@RabbitHandler注解标注在方法上,其需要和@RabbitListener注解一起使用。

@RabbitListener注解标注在类上,表示需要监听哪些方法,

@RabbitHandler注解用于重构方法,重载区分不同的消息。

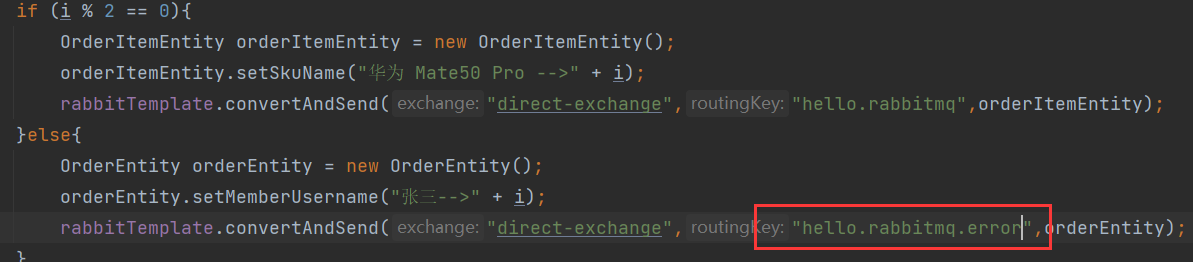

发送不同对象类型的消息

@GetMapping("/sendmessge")

public void sendMessage(){

for (int i = 0; i < 10; i++) {

if (i % 2 == 0){

OrderItemEntity orderItemEntity = new OrderItemEntity();

orderItemEntity.setSkuName("华为 Mate50 Pro -->" + i);

rabbitTemplate.convertAndSend("direct-exchange","hello.rabbitmq",orderItemEntity);

}else{

OrderEntity orderEntity = new OrderEntity();

orderEntity.setMemberUsername("张三-->" + i);

rabbitTemplate.convertAndSend("direct-exchange","hello.rabbitmq",orderEntity);

}

}

}@RabbitListener注解用于监听指定队列中的消息,@RabbitHandler注解用于重构方法,接受不同对象类型的消息

@Service

@RabbitListener(queues = {"direct-queue"})

public class RabbitServiceImpl {

/**

* 接收消息

*/

@RabbitHandler

public void receiveMessage1(OrderItemEntity orderItemEntity){

System.out.println("消息体对象:" + orderItemEntity);

}

/**

* 接收消息

*/

@RabbitHandler

public void receiveMessage2(OrderEntity orderEntity){

System.out.println("消息体对象:" + orderEntity);

}

}

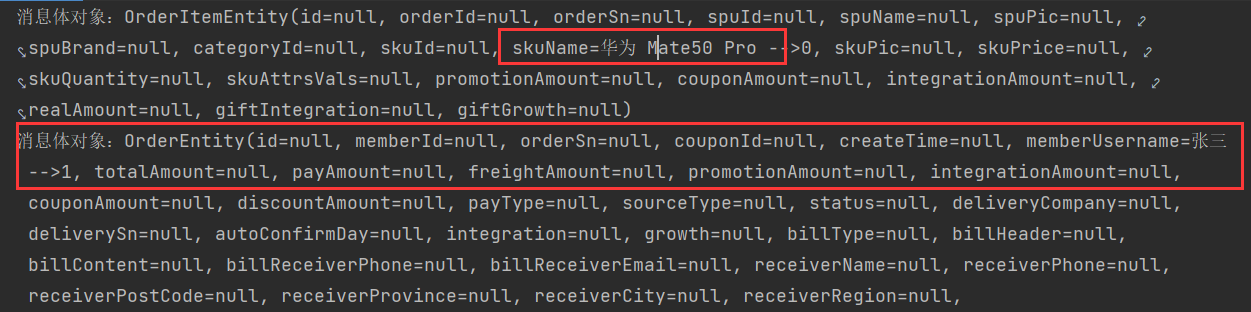

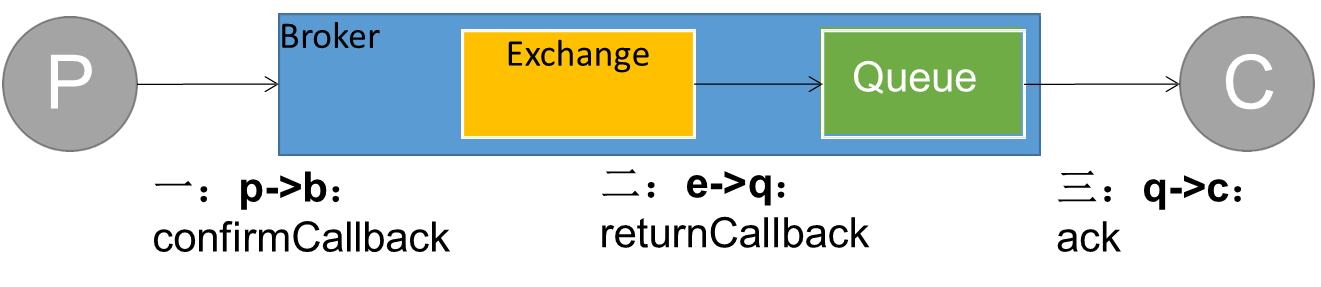

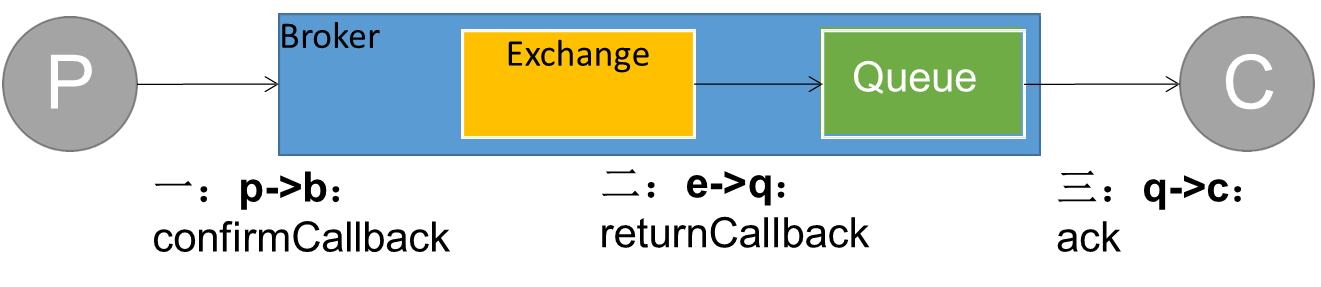

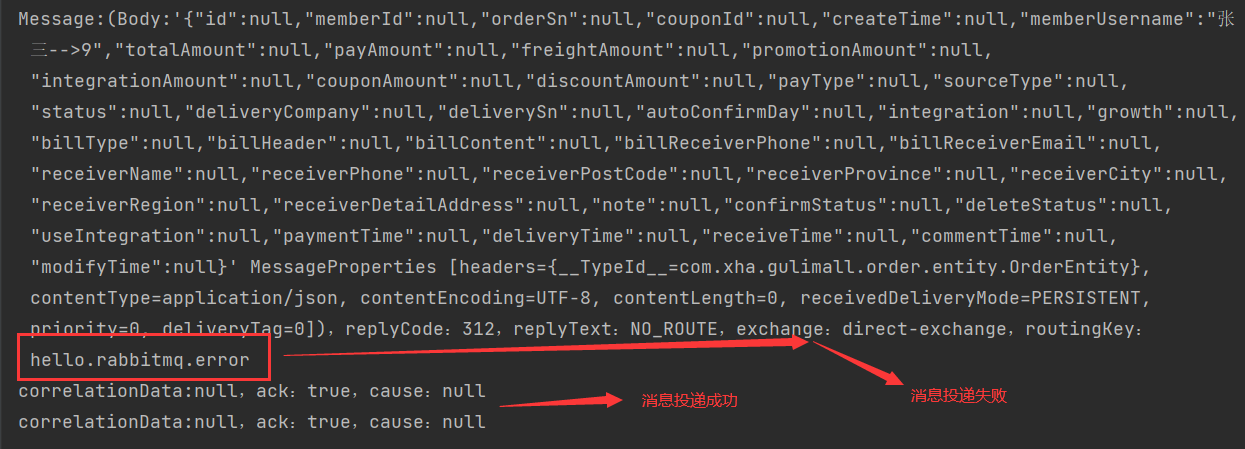

11.21.9消息可靠投递—生产端确认(ConfirmCallback)

11.21.9.1开启消息确认

使用ConfirmCallback回调函数来实现消息回调。

设置配置文件,在消息发送成功或消息发送失败的时候都触发回调函数

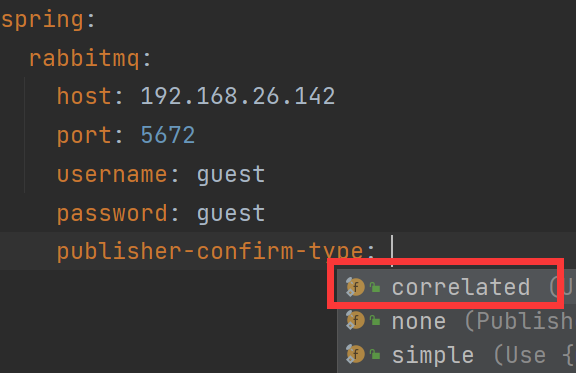

spring.rabbitmq.publisher.confirm.type的参数讲解:

- correlated:发布消息成功或失败到交换机后会触发回调方法

- none:禁止发布确定模式,是默认值

- simple:和单个发布确定的模式相同

spring:

rabbitmq:

host: 192.168.26.142

port: 5672

username: guest

password: guest

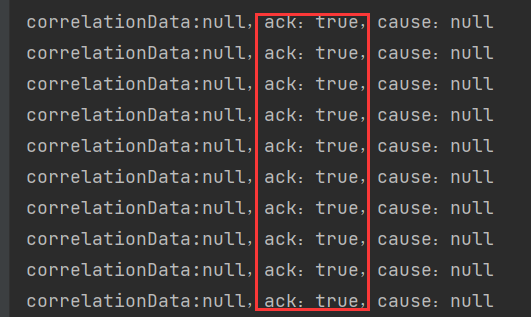

publisher-confirm-type: correlated11.21.9.2全局配置确认回调

当发送消息,Broker收到就会触发确认回调

import org.springframework.amqp.rabbit.connection.CorrelationData;

import org.springframework.amqp.rabbit.core.RabbitTemplate;

import org.springframework.amqp.support.converter.Jackson2JsonMessageConverter;

import org.springframework.amqp.support.converter.MessageConverter;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import javax.annotation.PostConstruct;

import javax.annotation.Resource;

@Configuration

public class RabbitMQMessageConfig {

@Resource

private RabbitTemplate rabbitTemplate;